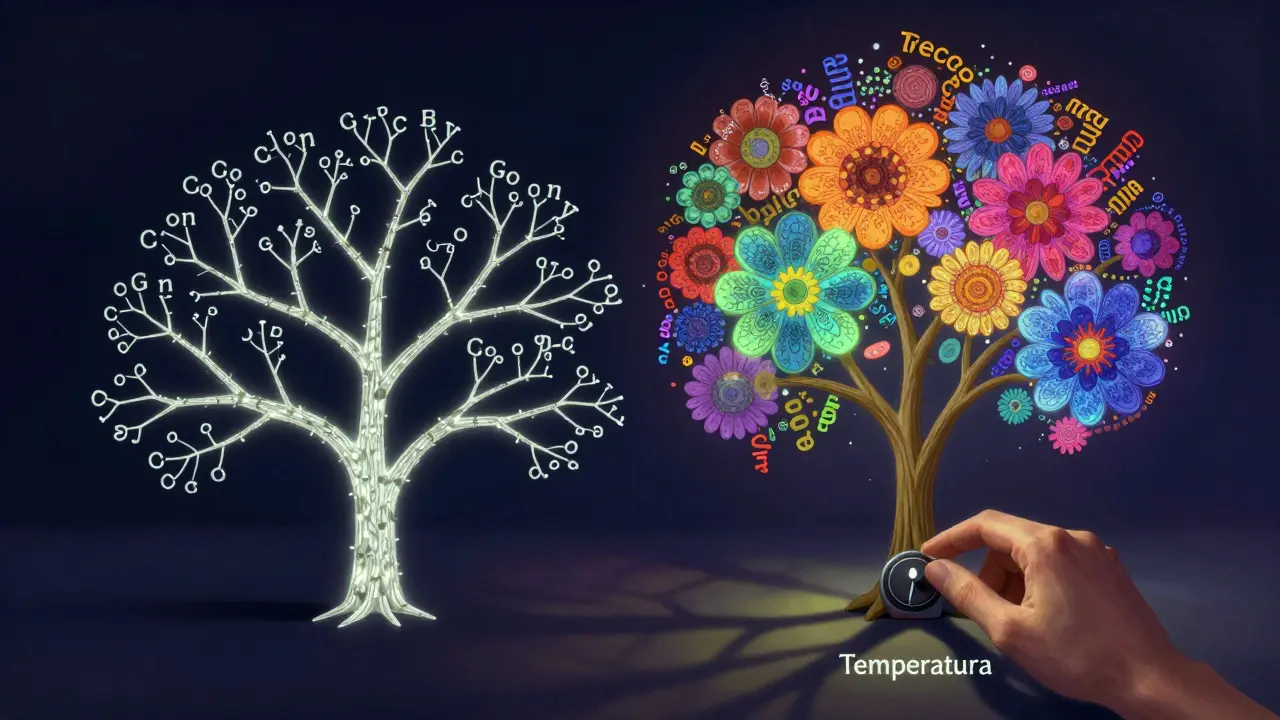

Se você já usou um modelo de linguagem grande - como GPT, Llama ou Claude - e percebeu que às vezes ele responde como um poeta e outras vezes como um contabilista, a culpa não é do modelo. É da temperatura.

O que é temperatura em modelos de linguagem?

Temperatura não tem nada a ver com calor. É um número que você define para controlar o quão aleatório ou previsível será o texto gerado. Imagine que o modelo tem uma lista de palavras possíveis para continuar sua frase, cada uma com uma probabilidade. A temperatura decide se ele vai escolher sempre a mais provável ou se vai dar uma chance para as menos prováveis.

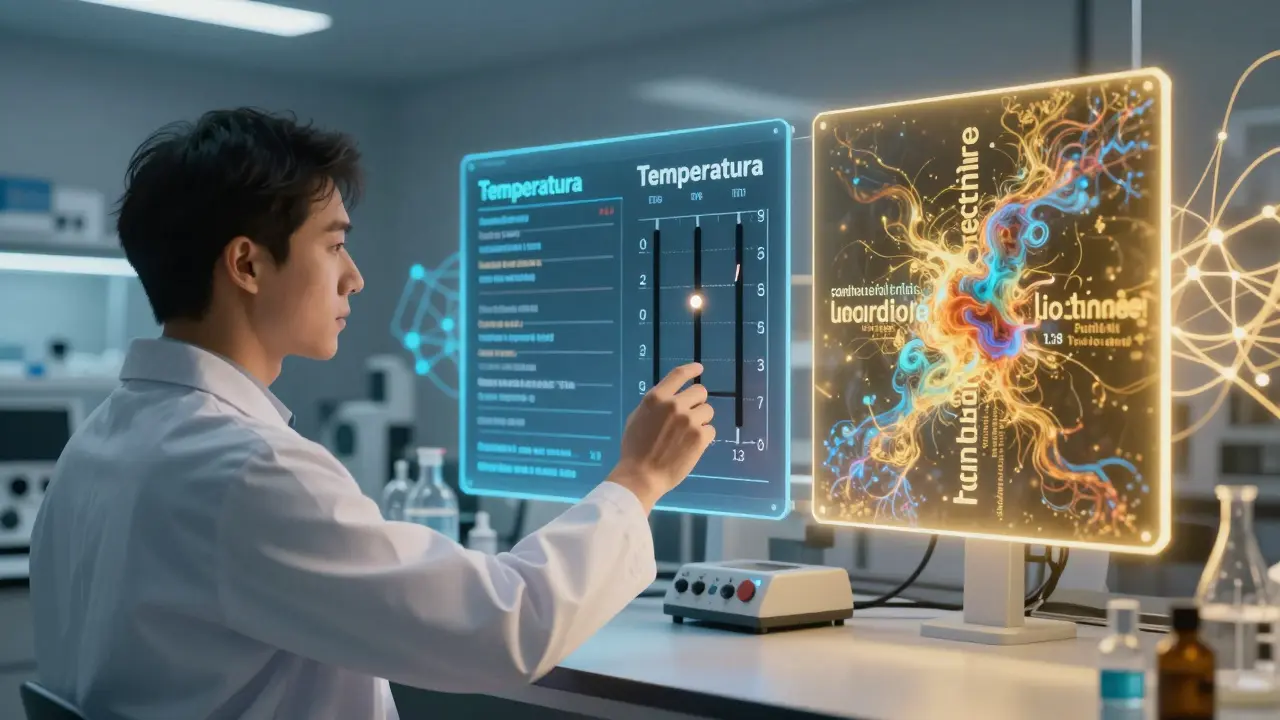

Quando a temperatura é 1.0, o modelo usa as probabilidades originais, como calculadas pela rede neural. É o ponto neutro. Mas se você baixa para 0.2? Ele vira um perfeccionista: só escolhe as opções mais certas, ignora ideias estranhas, e quase sempre dá a mesma resposta para a mesma pergunta. Se sobe para 1.3? Ele vira um artista: pega palavras raras, faz conexões inesperadas, e às vezes inventa coisas que não existem.

A matemática por trás disso é simples: a temperatura altera a distribuição de probabilidade com uma fórmula exponencial. Em temperaturas baixas, o topo da distribuição fica bem mais alto - a palavra mais provável vira quase certeza. Em temperaturas altas, a curva fica mais plana, e até palavras com 0,1% de chance podem aparecer.

Quando usar temperatura baixa (0.0 a 0.3)

Se você precisa de respostas exatas, consistentes e sem surpresas, use temperatura baixa. É o padrão em aplicações onde erro é caro.

- Extrair dados de formulários ou documentos: o modelo deve retornar sempre o mesmo formato, mesmo que a entrada mude levemente.

- Sistemas de atendimento médico: uma recomendação de dosagem de remédio não pode variar entre duas respostas.

- APIs de negócios: se você integra a IA a um sistema financeiro, cada resposta precisa ser previsível para não quebrar o fluxo de trabalho.

Estudos da Vellum.ai mostram que, com temperatura abaixo de 0.3, 98,7% das respostas a um mesmo prompt são idênticas - ou quase. Isso é essencial para compliance, auditoria e automação confiável. Empresas de serviços financeiros usam temperatura média de 0.25, com variação mínima, para garantir que nenhum resultado viole regulamentações.

Mas atenção: temperatura 0.0 não é garantia de perfeição. Mesmo com temperatura zero, variações de hardware (como cálculos em GPU) podem introduzir pequenas diferenças. Não existe determinismo absoluto - apenas muito, muito próximo.

Quando usar temperatura média (0.4 a 0.6)

Essa faixa é o ponto de equilíbrio. Ideal para tarefas que exigem precisão, mas permitem um pouco de variação criativa.

- Resumos de artigos técnicos: o conteúdo precisa ser fiel, mas pode ser reescrito de forma mais clara.

- Respostas de assistentes virtuais: não quer que ele repita a mesma frase sempre, mas também não quer que invente fatos.

- Redação de e-mails profissionais: o tom precisa ser adequado, mas pode variar para evitar repetição.

É a faixa recomendada pela maioria dos desenvolvedores que não estão nem no modo “máquina” nem no modo “poeta”. É o que chamam de “Modo Equilibrado” - um padrão emergente documentado no rascunho da norma IEEE P3652.1 de novembro de 2024.

Quando usar temperatura alta (0.7 a 1.5)

Aqui é onde a IA começa a surpreender - e às vezes assustar.

Com temperatura entre 0.8 e 1.2, o modelo explora muito mais opções. O CodeSignal descobriu que, nessa faixa, a seleção de tokens únicos aumenta 3,2 vezes em comparação com temperatura 0.2. Isso significa mais ideias, mais variações, mais criatividade.

- Criação de slogans de marketing: um prompt como “me dê 10 frases para um app de ioga” pode gerar 12 opções viáveis com temperatura 0.85 - e só uma com 0.2.

- Escrita criativa: poesia, histórias, diálogos de personagens.

- Brainstorming: quando você quer que a IA jogue ideias fora da caixa.

Mas há um custo. A Tetrate analisou 5.000 respostas em tarefas de recuperação de conhecimento e descobriu que, ao subir de temperatura 0.2 para 1.0, a precisão factual caiu 27%. Coerência também diminuiu 19%. Ou seja: a IA pode soar bonita, mas está mentindo.

Um caso real: um usuário no Reddit contou que seu sistema de perguntas médicas deu recomendações perigosas de dosagem porque a temperatura foi definida acidentalmente em 1.2. Não foi erro de prompt. Foi erro de temperatura.

Temperatura não trabalha sozinha - e isso é crucial

Temperatura raramente é usada isolada. Ela interage com outras duas configurações: top-k e top-p (também chamado de nucleus sampling).

Top-p limita as escolhas a um grupo de palavras cujas probabilidades somadas chegam a um certo limite - por exemplo, 90%. Top-k limita ao top 5 ou top 10 tokens mais prováveis.

A ordem importa: primeiro, a temperatura modifica as probabilidades. Depois, top-p ou top-k filtra esse novo conjunto. Isso faz diferença real.

Exemplo:

- Temperatura 0.7 + top-p 0.9: o modelo pega as palavras mais prováveis, mas com um pouco de liberdade. Ideal para redação criativa com controle.

- Temperatura 1.2 + top-p 0.85: o modelo explora mais, mas corta as ideias mais absurdas. Bom para brainstorming.

- Temperatura 0.2 + top-p 1.0: ele só escolhe as melhores, sem exceções. Perfeito para automação.

Se você usar top-p 0.9 com temperatura 0.1, o modelo vai ser extremamente conservador - e quase não vai usar o top-p, porque já está escolhendo só uma palavra. Se usar top-p 0.9 com temperatura 1.3, ele vai explorar muito mais - e o top-p só vai cortar as ideias mais loucas.

Por que a mesma temperatura funciona diferente em modelos diferentes?

Um problema grande que poucos falam: a temperatura não é padronizada entre modelos.

Uma temperatura de 0.7 pode gerar respostas muito conservadoras no Llama 3 da Meta, mas totalmente criativas no Claude 3 Opus da Anthropic. Isso acontece porque cada modelo tem uma forma diferente de calibrar as probabilidades internas.

Isso significa que você não pode copiar e colar configurações de um modelo para outro. Se você ajustou tudo perfeitamente no GPT-4 e agora quer usar o Llama 3, precisa testar de novo.

Uma pesquisa da Gartner de maio de 2025 mostrou que 87% dos profissionais de IA em empresas precisam reajustar a temperatura quando mudam de modelo. É um gargalo de implementação que pode atrasar projetos por semanas.

Como descobrir a temperatura certa para o seu caso?

Não adivinhe. Teste.

O CodeSignal recomenda rodar pelo menos 50 prompts idênticos, variando a temperatura de 0.1 a 1.5 em passos de 0.1. Anote:

- Quantas respostas são idênticas?

- Quantas são úteis?

- Quantas são erradas ou absurdas?

Use uma planilha simples. Em cada linha, coloque um valor de temperatura. Nas colunas, registre:

- Consistência (0 a 10)

- Precisão factual (0 a 10)

- Criatividade (0 a 10)

- Coerência geral (0 a 10)

Depois, veja onde o gráfico se equilibra. Para automação, você quer consistência e precisão. Para marketing, você quer criatividade e variedade - mesmo que precise revisar algumas respostas.

As regras de ouro que ninguém te conta

- Temperatura 0.0 não é zero. Ela só reduz a aleatoriedade - não elimina. Se você precisa exatidão absoluta, use validação externa.

- Se sua resposta parece estranha, mas não errada, baixe a temperatura. Se parece repetitiva e chata, aumente.

- Nunca use temperatura acima de 1.2 para tarefas com risco real - saúde, finanças, direito.

- Documente sua temperatura. Se você mudar de modelo ou atualizar a IA, você vai esquecer o que funcionou.

- Se a IA está inventando fatos, não é um problema de prompt. É um problema de temperatura.

O futuro: temperaturas que se ajustam sozinhas

Empresas já estão testando sistemas que ajustam a temperatura automaticamente. A Google Research mostrou que um controlador dinâmico pode melhorar a qualidade das respostas em 22% ao mudar a temperatura com base no tipo de pergunta e na qualidade da resposta anterior.

Imagine perguntar: “Quais são os efeitos colaterais do medicamento X?” - e a IA automaticamente usa temperatura 0.2. Depois, você pede: “Me conte uma história sobre alguém que tomou esse remédio” - e ela muda para 1.0.

Esses sistemas ainda estão em fase experimental, mas são o futuro. Por enquanto, você precisa ser o controlador.

Resumo rápido

- Temperatura baixa (0.0-0.3): precisão, consistência, automação. Ideal para dados, medicina, finanças.

- Temperatura média (0.4-0.6): equilíbrio. Melhor para assistentes, resumos, e-mails.

- Temperatura alta (0.7-1.5): criatividade, variedade, exploração. Ideal para marketing, escrita, brainstorming.

- Use top-p junto com temperatura para controlar melhor a diversidade.

- A mesma temperatura pode ter efeitos diferentes em modelos diferentes - teste sempre.

- Se a IA está inventando coisas, baixe a temperatura. Se está repetitiva, aumente.

O que acontece se eu definir a temperatura em 0?

Temperatura 0 força o modelo a escolher sempre a palavra mais provável em cada passo. Isso torna as respostas extremamente previsíveis - quase sempre idênticas. Mas não é garantia de perfeição: variações de hardware ainda podem causar pequenas diferenças. É ideal para automação, mas não para criatividade.

Por que minha IA dá respostas diferentes mesmo com a mesma temperatura e prompt?

Mesmo com temperatura 0, o hardware (como GPUs) pode introduzir pequenas variações nos cálculos numéricos. Isso não é erro - é uma limitação física. Se você precisa exatidão absoluta, use validação externa ou regras de pós-processamento.

Temperatura e top-p são a mesma coisa?

Não. Temperatura muda as probabilidades de todas as palavras. Top-p filtra quais palavras são consideradas - apenas as que somam até um certo limite de probabilidade. Eles funcionam em sequência: temperatura primeiro, depois top-p. Usar um sem o outro muda totalmente o comportamento.

Qual é a temperatura ideal para gerar código?

Entre 0.1 e 0.3. Código precisa ser preciso, funcional e consistente. Uma temperatura alta pode gerar sintaxe errada ou lógica incoerente. A maioria dos desenvolvedores de IA usa temperatura 0.2 para geração de código - e sempre revisa o resultado.

Como sei se estou usando a temperatura certa?

Teste. Faça 50 perguntas iguais, variando a temperatura de 0.1 a 1.5. Anote quantas respostas são úteis, consistentes e corretas. O ponto ideal é onde você tem o melhor equilíbrio entre precisão e variedade - sem erros graves.

Posso usar temperatura alta para respostas médicas?

Nunca. A temperatura alta aumenta o risco de a IA inventar informações, como dosagens erradas ou tratamentos não comprovados. Para saúde, use sempre temperatura entre 0.1 e 0.3, e sempre valide com fontes confiáveis. A criatividade não tem lugar em diagnósticos.