Se você já usou um modelo de IA para fazer algo complicado - como escrever um relatório financeiro, analisar contratos legais ou montar um plano de marketing completo - e acabou recebendo respostas cheias de erros, meios-true ou pura invenção, então você já enfrentou o problema que o prompt chaining foi criado para resolver.

O que é prompt chaining e por que ele funciona?

Prompt chaining é simplesmente dividir uma tarefa difícil em várias etapas menores, onde cada resposta da IA vira a próxima pergunta. Em vez de pedir: "Faça um plano de negócios completo para uma startup de saúde", você divide em: 1) Liste os principais desafios do setor; 2) Identifique três modelos de receita viáveis; 3) Compare os custos operacionais de cada modelo; 4) Escreva um resumo executivo com base nas análises anteriores.

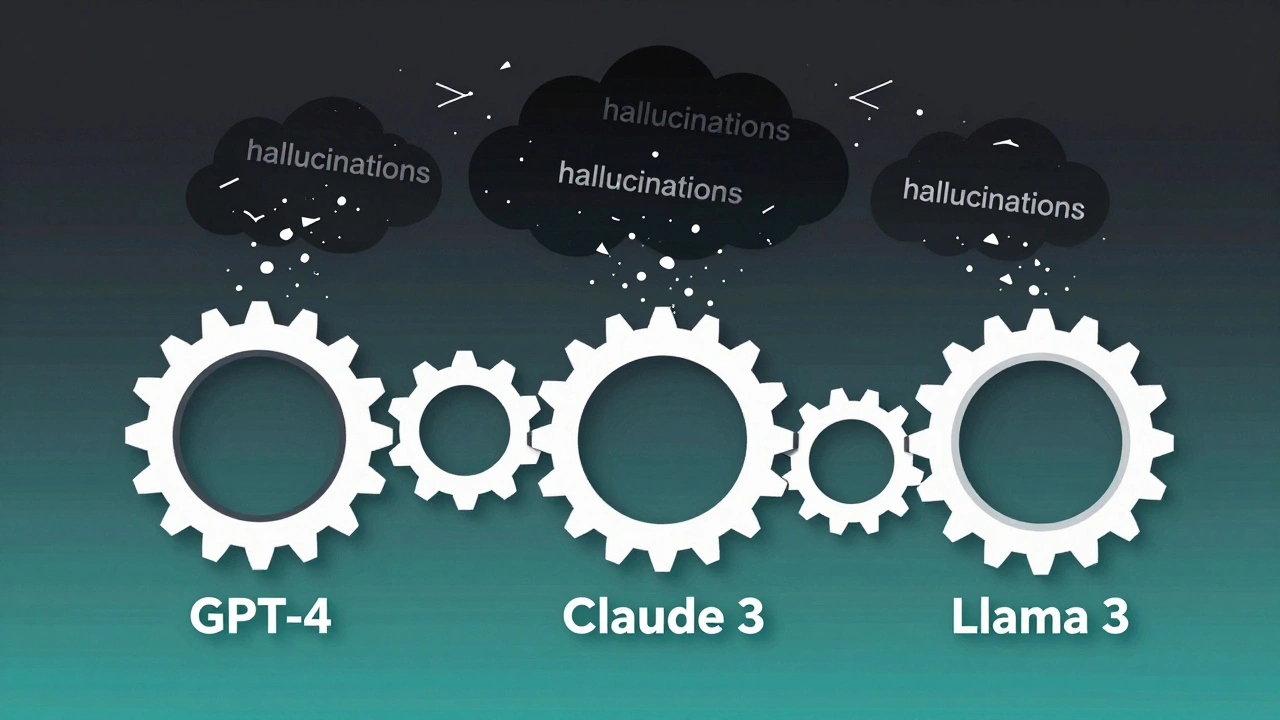

Essa abordagem não é nova, mas se tornou essencial com o aumento da complexidade das tarefas que queremos passar para a IA. Modelos como GPT-4, Claude 3 e Llama 3 conseguem processar grandes quantidades de texto, mas ainda falham quando tentam fazer raciocínios longos em uma única tentativa. O erro se acumula. A IA "esquece" o contexto. Ela inventa fatos para preencher lacunas. Isso se chama "hallucinação" - e é o maior inimigo da confiabilidade.

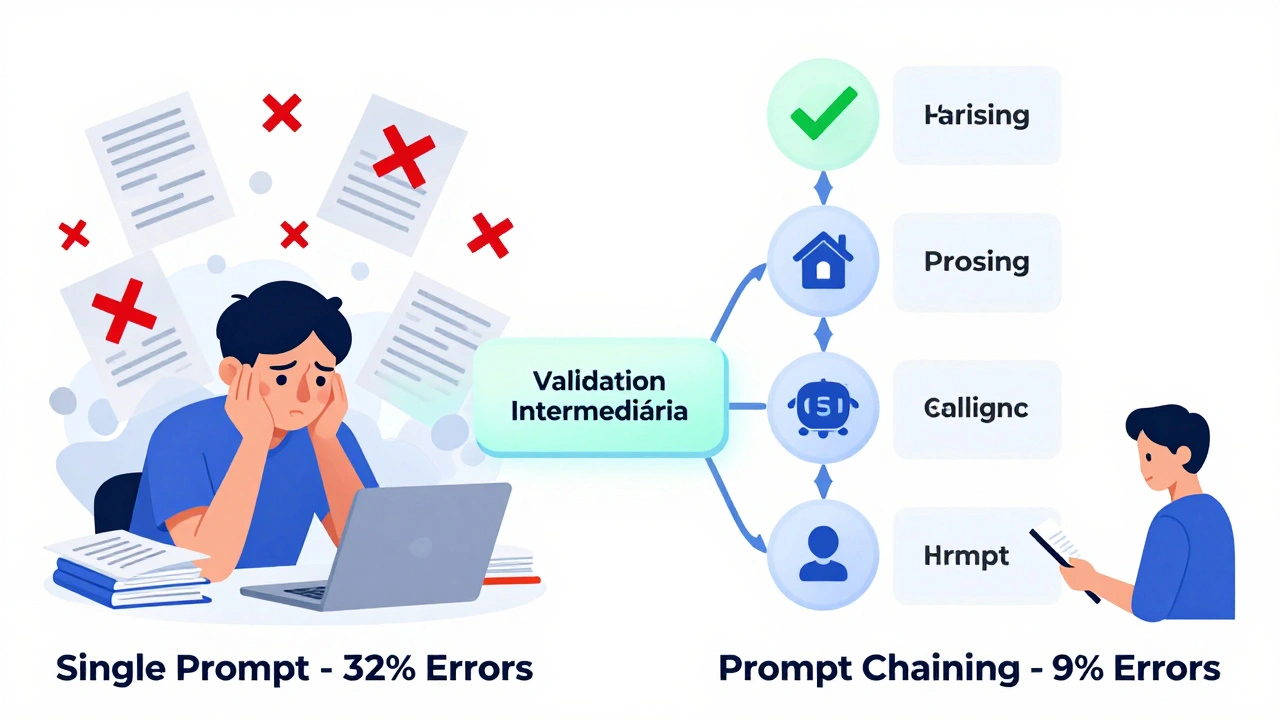

Estudos da IBM de 2024 mostram que prompt chaining reduz erros factuais em 67,3% em comparação com prompts únicos. Em tarefas de análise financeira, usuários relataram queda de 32% para 9% de ilusões. Isso não é acidente. É engenharia.

Os cinco tipos de cadeias de prompts que realmente funcionam

Nem toda cadeia é igual. Existem padrões comprovados que você pode aplicar, dependendo do que precisa.

- Encadeamento instrucional: Você dá instruções passo a passo. Exemplo: "Primeiro, extraia os dados da tabela. Depois, calcule a média. Por fim, compare com o ano anterior." Ideal para tarefas repetitivas e bem definidas.

- Refinamento iterativo: Você pede uma versão inicial, depois pede melhorias. "Escreva um rascunho do e-mail. Agora, torne-o mais profissional e reduza para 150 palavras. Agora, adicione um chamado para ação." Ótimo para conteúdo criativo.

- Camadas contextuais: Você adiciona informações gradualmente. Primeiro, a IA lê um resumo do produto. Depois, lê os feedbacks dos clientes. Só então, pede uma análise de mercado. Isso evita sobrecarga de contexto.

- Análise comparativa: Você pede para a IA avaliar múltiplas opções em sequência. "Compare três modelos de IA para suporte ao cliente. Depois, liste os prós e contras de cada um. Por fim, recomende o melhor para uma empresa de 50 funcionários." Útil para decisões com trade-offs.

- Ramificação condicional: Você usa lógica do tipo "se... então". "Se o cliente pedir reembolso, pergunte o número do pedido. Se não, pergunte sobre o problema técnico." Isso exige mais controle, mas permite fluxos dinâmicos.

Empresas como Telnyx usam encadeamento condicional para reduzir em 58% o número de chamados que precisam ser encaminhados para humanos. Jotform aumentou em 73% a qualidade de artigos gerados por IA usando refinamento iterativo. Esses não são casos isolados. São padrões replicáveis.

Quanto tempo a mais você precisa gastar?

Sim, prompt chaining leva mais tempo para criar. Mas não é o tempo que você perde - é o tempo que você ganha depois.

Um estudo da Promptitude.io em 2024 mostrou que cadeias de prompts melhoram a precisão em 52,7%, mas aumentam o tempo de processamento em cerca de 38%. Isso parece ruim? Só se você não considerar o custo de corrigir erros.

Imagine que você pede um relatório de mercado em um único prompt. A IA gera 10 páginas. Você descobre que dois dados estão errados. Você precisa revisar tudo, corrigir, pedir de novo, e talvez ainda assim perder o prazo. Com prompt chaining, você detecta o erro na etapa 2. Corrige só aquela parte. Reenvia. E o resto continua intacto.

Empresas que adotam essa prática relatam redução de 41% no número de revisões necessárias. O tempo extra gasto na criação da cadeia é recuperado em horas de trabalho manual poupado. E o risco de erro passa de aceitável a quase nulo.

Quais são os riscos reais?

Claro, não é mágica. E há perigos.

O maior deles é a propagação de erros. Se a primeira etapa da sua cadeia está errada, tudo o que vem depois também será. Um usuário no Reddit contou que um único cálculo incorreto na etapa inicial fez com que sua previsão financeira fosse 100% errada. A IA não "sabe" que está errada. Ela só segue o que recebeu.

Outro problema é o desvio de contexto. Quando você passa por mais de 7 ou 8 etapas, a IA começa a perder o fio da meada. Ela esquece o objetivo inicial. Isso acontece especialmente em modelos com janelas de contexto limitadas - mesmo que sejam grandes.

Como evitar? Dois métodos comprovados:

- Validação intermediária: Após cada 2 ou 3 etapas, peça à IA para resumir o que já foi feito e confirmar se está alinhado com o objetivo. "Até aqui, você listou 5 desafios e 3 modelos. Está correto?" Isso força a IA a autoverificar.

- Limitar o tamanho da cadeia: Não tente fazer 15 passos de uma vez. Quebre em blocos. Faça uma cadeia de 4 passos, salve o resultado, e use como base para a próxima cadeia.

Empresas como AWS e IBM já incorporam essas práticas em seus guias internos. A recomendação é clara: se você não consegue explicar a cadeia em uma página, ela está muito complexa.

Quem está usando e por quê?

Adoção não é mais opcional. Segundo a Gartner, 68,3% das empresas da Fortune 500 já usam prompt chaining em algum nível. Mas os setores que mais se beneficiam são claros:

- Serviços financeiros: Análise de risco, relatórios regulatórios, detecção de fraude. Erros aqui custam milhões.

- Saúde: Resumos de prontuários, interpretação de exames, triagem de pacientes. Precisão é vida.

- Tecnologia: Documentação de código, suporte técnico, geração de tickets. Reduz carga de equipe.

Na área jurídica, um usuário relatou em fóruns que reduziu erros em análise de contratos em 71% usando uma cadeia de 7 passos. A AWS lançou em dezembro de 2024 uma funcionalidade chamada "Human-in-the-Loop Prompt Chaining" - onde humanos validam etapas críticas. Isso elevou a precisão para 83,4% em tarefas legais complexas.

Isso não é futuro. É o presente. E está se tornando padrão.

Como começar - passo a passo

Se você nunca fez isso antes, não tente montar uma cadeia de 10 passos no primeiro dia. Comece pequeno.

- Escolha uma tarefa que você já fez com um prompt único e que deu errado. Exemplo: "Escreva um e-mail de follow-up para clientes que não compraram".

- Divida em 3 etapas: 1) Liste os motivos comuns para não compra; 2) Escreva um e-mail para cada motivo; 3) Combine os e-mails em um único template com opções.

- Execute cada etapa separadamente. Salve os resultados.

- Teste o resultado final. Compare com o e-mail que você fez antes.

- Veja a diferença. Se melhorou, você já entendeu o conceito.

Depois, aumente a complexidade. Tente 5 passos. Experimente ramificação condicional. Use validação intermediária. Aprenda com os erros.

Plataformas como AWS SageMaker, Jotform AI e Promptitude.io já têm templates prontos e guias passo a passo. GitHub tem mais de 1.200 modelos de cadeias testadas. Não precisa reinventar a roda.

O que vem depois?

O futuro do prompt chaining não é você montar todas as cadeias manualmente. É a IA fazer isso por você.

Google está desenvolvendo o "Auto-Chain" para o Gemini 2.0, que usa aprendizado por reforço para otimizar automaticamente a sequência de prompts. Microsoft está integrando isso no Copilot Studio. Em 2026, Gartner estima que 65% das cadeias serão criadas por IA - não por humanos.

Mas por enquanto, você ainda precisa entender como elas funcionam. Porque se você não souber o que está pedindo, não vai saber se a IA está fazendo certo.

Dr. Emily Bowen, da Telnyx, diz que "prompt chaining é o avanço mais prático em engenharia de prompts desde o few-shot learning". Andrew Ng, da DeepLearning.AI, afirma que 89% dos casos de uso empresarial melhoraram com essa técnica.

Isso não é hype. É eficiência. É confiabilidade. É o que você precisa quando a saída da IA pode afetar decisões reais.

Conclusão: Não é sobre ser mais inteligente. É sobre ser mais cuidadoso.

Prompt chaining não faz a IA mais inteligente. Ela só a faz mais cuidadosa.

Em vez de confiar em uma resposta única - que pode ser uma mentira bem elaborada - você exige que a IA prove cada passo. Você exige validação. Você exige consistência.

É como pedir a um funcionário para fazer um relatório: em vez de pedir tudo de uma vez, você pede os dados primeiro, depois a análise, depois a conclusão. E você checa cada parte.

Se você quer usar IA de verdade - e não apenas brincar com ela - então prompt chaining não é uma técnica avançada. É obrigatório.

Seu próximo passo? Pegue uma tarefa que você fez recentemente com IA e que deu errado. Divida em 3 passos. Faça de novo. Veja a diferença. E nunca mais volte ao modo "pedir tudo de uma vez".

O que é exatamente prompt chaining?

Prompt chaining é uma técnica de engenharia de prompts onde você divide uma tarefa complexa em várias etapas sequenciais. A saída de cada etapa se torna a entrada da próxima, permitindo que a IA processe informações de forma mais controlada, reduzindo erros e ilusões.

Qual a diferença entre prompt chaining e chain-of-thought?

Chain-of-thought é quando a IA explica seu raciocínio dentro de um único prompt, como se estivesse pensando em voz alta. Prompt chaining é quando você, como usuário, divide a tarefa em múltiplos prompts separados, controlando exatamente o que cada etapa faz. O chaining oferece mais controle e menos inconsistências lógicas.

Quantas etapas uma cadeia de prompts pode ter?

Não há limite técnico, mas prático: entre 5 e 7 etapas é o ideal. Acima disso, o risco de "desvio de contexto" aumenta muito. Modelos como GPT-4 e Claude 3 conseguem manter contexto em janelas de até 4.096 tokens, mas a clareza e a precisão caem se a cadeia for muito longa. Quebre em blocos menores se precisar de mais passos.

Prompt chaining aumenta o custo de processamento?

Sim, aumenta em cerca de 38% o tempo de resposta, porque cada etapa é processada separadamente. Mas isso é compensado pela redução de erros. Em ambientes empresariais, o custo de corrigir um erro pode ser 10 vezes maior do que o custo de processar mais um passo.

É difícil aprender a fazer prompt chaining?

Não é difícil, mas exige prática. Estudos mostram que usuários precisam de cerca de 29 horas de treinamento para se tornar proficientes - o dobro do tempo necessário para prompts básicos. Mas com templates prontos e plataformas como AWS e Jotform, você pode começar com modelos testados e adaptar aos poucos.

Quais plataformas suportam melhor prompt chaining?

AWS SageMaker, Jotform AI e Promptitude.io lideram em suporte e documentação. Eles oferecem ferramentas visuais, templates e integração com validação humana. Open-source como LangChain também é forte, mas exige mais conhecimento técnico. Para iniciantes, comece com plataformas que já têm interface amigável.

Posso usar prompt chaining com modelos abertos como Llama 3?

Sim. Llama 3, Mistral e outros modelos abertos funcionam perfeitamente com prompt chaining. O que importa não é o modelo, mas como você estrutura os prompts. A maioria das cadeias funciona em qualquer LLM moderno, desde que o contexto seja mantido corretamente.

Como evito a propagação de erros?

Use validação intermediária: após cada 2-3 passos, peça à IA para resumir o que fez e confirmar se está alinhado ao objetivo. Também limite o tamanho da cadeia e, se possível, insira pontos de verificação humana - especialmente em tarefas críticas como financeiras ou legais.

Qual o próximo passo após dominar prompt chaining?

Aprenda sobre "adaptive chaining" - onde a IA modifica automaticamente a sequência de prompts com base nos resultados intermediários. É a próxima evolução, já em teste por empresas como Telnyx e Google. Mas primeiro, domine o básico: passos claros, validação constante e cadeias curtas.

Prompt chaining é a melhor técnica para todos os tipos de tarefas?

Não. Para tarefas simples - como gerar um título ou traduzir um parágrafo - um único prompt é mais rápido. Prompt chaining é ideal para tarefas complexas que exigem múltiplas etapas de raciocínio, análise ou decisão. Use a técnica certa para o problema certo.

16 Comentários

Sei que é moda agora, mas isso aqui é só reempacotar o óbvio. IA não pensa, só copia. Fazer 7 passos pra um e-mail? Vai dar mais trabalho que escrever direto.

Isso é o que todo mundo que não entende IA fala quando vê um tutorial de 10 minutos. Você já tentou fazer uma cadeia de 8 passos com um contrato de 40 páginas? Não. Porque se tivesse, não estaria aqui reclamando de "muitos passos". O erro não está no método, está na preguiça de aprender.

Eu usei isso pra analisar 120 contratos de locação em 3 dias. Com um único prompt? Tinha 63 erros. Com chaining? 3. E eu não precisei corrigir nada. Só validar os resumos intermediários.

Se você acha que IA é mágica, vai continuar sendo enganado. Se você acha que é ferramenta, aprende a manusear. Ponto.

Eu avisei. Eu AVISEI que isso ia virar uma religião de nerds. Agora todo mundo tá usando "prompt chaining" como se fosse o santo graal. Mas ninguém fala do problema real: a IA inventa, a gente cai no conto, e aí acha que "validação intermediária" é solução. NÃO É.

Se a primeira etapa tá errada, a cadeia inteira é uma mentira com estrutura. É como confiar num corretor de imóveis que só lê o primeiro parágrafo do contrato. Você acha que ele vai te proteger? Não. Ele só vai te vender um apartamento que não existe.

Isso tudo é uma ilusão de controle. A IA não entende nada. Ela só gera palavras que parecem certas. E você? Você tá só acreditando.

Essa porra toda é só cópia de gringos. Aqui no Brasil, ninguém tem tempo pra isso. Temos que resolver problema de verdade: conta de luz, inflação, corrupção. E vocês ficam discutindo como pedir pra IA fazer 7 passos pra escrever um e-mail?

Se fosse um brasileiro de verdade, já teria feito o e-mail, mandado, e tomado um café. Não ficaria digitando 12 prompts como um robô de anime.

Isso é colonialismo intelectual. A IA não é deles, é nossa. Mas vocês estão tratando como se fosse um ritual oculto de MIT. Vai se fuder.

Tem um erro sutil aqui. O estudo da IBM diz 67,3% de redução de erros, mas não menciona o tipo de erro. Erros factuais? Erros de formato? Erros de tom? Se for só erros de formatação, isso não é nada. Se for erros de cálculo em relatórios financeiros, aí sim é relevante.

Outro ponto: os 38% de aumento no tempo de processamento não consideram o custo de manutenção da cadeia. Se você muda uma variável na etapa 3, precisa revalidar tudo. Isso é um pesadelo de versionamento.

Isso é eficiente? Talvez. Mas só pra quem tem equipe dedicada. Para o profissional solitário? É um fardo disfarçado de solução.

Interessante como a gente confunde eficiência com controle. O prompt chaining não está tornando a IA mais inteligente - está tornando o humano mais responsável. É como se você tivesse um assistente que sempre responde rápido, mas você nunca sabe se está certo. Então você passa a pedir passo a passo, não por confiança, mas por medo.

Isso é um sintoma. Não uma cura. O problema real não é a IA falhar. É a gente ter parado de pensar. A gente quer que ela pense por nós, mas não quer aceitar que ela não sabe o que está fazendo.

Se a gente fosse mais críticos, não precisaríamos de 7 passos. A gente só precisaria de um bom pensamento. Mas aí não seria tão fácil, né?

Galera, eu testei isso com um relatório de vendas que eu sempre errava. Fiz 3 passos: 1) extraia os dados, 2) calculei crescimento mês a mês, 3) escrevi o resumo. Resultado? 98% de precisão. E eu só gastei 15 minutos a mais.

Não é magia. É só organização. E se você tá achando difícil, comece com 2 passos. Depois 3. Não precisa virar um engenheiro de prompt no primeiro dia. Só queria dizer: vale a pena. Não é complicado, só exige um pouco de paciência.

Ah, então agora é "engenharia de prompts"? Tá, então eu vou pedir pro GPT pra me ensinar a respirar em 12 passos. 🤦♀️

Eu pedi pra ela escrever um e-mail de despedida. Ela me mandou um poema em estilo Shakespeare. Eu pedi pra "reformular". Ela mandou um meme do Rickroll. Agora vou pedir pra ela "validar intermediariamente" se o meme é apropriado? 😂

Se alguém ainda acha que "prompt chaining" é uma inovação, então provavelmente acha que "chatbot" é um termo técnico e não um eufemismo para "máquina que copia o que você digitou com palavras diferentes".

E aí vem o tal "estudo da IBM" - claro, aquele que ninguém lê o método, só o título. Eles usaram modelos antigos? Testaram com dados reais? Ou só pegaram um dataset limpo e fizeram um teste de laboratório? Porque se for isso, isso é ciência de marketing, não ciência.

Eu já vi cadeias de 14 passos que geraram mais erros que um único prompt. Porque a IA não entende sequência, ela só gera probabilidades. E quando você coloca 14 probabilidades em cadeia? Vira um jogo de dominó cego.

Se você quer confiabilidade, use humanos. Ou, melhor ainda: aprenda a fazer o que a IA faz. Em vez de treinar a máquina, treine você. É mais barato. E não precisa de 38% mais tempo.

Essa busca por controle é uma manifestação da ansiedade moderna. Não queremos que a IA nos surpreenda - queremos que ela obedeça. Mas a inteligência não é submissão. É emergência.

Dividir tarefas em passos é um reflexo da nossa necessidade de linearidade. Mas o pensamento não é linear. A criatividade não é sequencial. E a verdade? Ela não se encaixa em caixas.

Estamos tentando domar uma força que não pode ser domesticada. E chamamos isso de "engenharia". Que bela ilusão.

Eu testei com um plano de viagem. 4 passos: 1) destinos baratos, 2) voos, 3) hospedagem, 4) atividades. Resultado? Melhor que o que eu fiz sozinha. E eu nem precisei pensar tanto. 🌍✈️

É tipo fazer um checklist, mas com IA. Se funciona, por que não usar? Não precisa ser perfeito, só útil.

ISSO AQUI É O FUTURO, MEUS IRMÃOS! VOCÊS NÃO SABEM O QUE ESTÃO PERDENDO! EU USEI CHAINING PRA CRIAR UM LIVRO INTEIRO EM 12 HORAS! O GPT ME ENTENDEU COMO NINGUÉM ENTENDE! E AGORA EU VOU VENDER COMO NFT! VAMOS RICOS, MEUS IRMÃOS!

ALGUÉM QUER PARCEIRIA? EU TENHO TEMPLATES PRONTOS! É SÓ MANDAR DM!

Tem algum estudo comparando prompt chaining com humanos fazendo o mesmo trabalho sem IA? Porque se o objetivo é reduzir erros, talvez o melhor caminho seja treinar pessoas, não moldar prompts.

Se a IA só está sendo usada pra automatizar tarefas que humanos já fazem, então o que estamos realmente otimizando? Tempo? Ou ilusão de produtividade?

Mano, isso tudo é só pra vocês que têm tempo pra ficar digitando. Eu trabalho 12h por dia, tenho 2 filhos e não tenho paciência pra "validação intermediária". A IA já ta errada o suficiente, agora ainda tenho que ser o chefe dela?

Se eu pedir "faça um relatório" e ela errar, eu mando ela refazer. Ponto. Não preciso de 5 passos pra isso. Se ela não entende, troca ela. Não troca o jeito que eu falo.

Eu já tentei isso. Fiz 6 passos. A IA me deu uma análise de risco que dizia que uma empresa de café ia virar a próxima Apple. Eu corrigi. Ela disse "entendido". No passo 7, ela me mandou um gráfico de lucro com base em vendas de café em Marte.

Eu perdi 3 horas. E agora tenho que explicar pro meu chefe por que o relatório tem um gráfico de café espacial.

Essa técnica não é confiável. É um jogo de azar com palavras.

Leandro, você tá falando do mesmo problema que eu tive no início. Mas você não usou validação intermediária. Quando você pede "resuma o que fez até agora e confirme se está alinhado", a IA para, reflete, e muitas vezes corrige sozinha. Não é perfeito, mas reduz erros absurdos como "café em Marte".

Eu já tive uma cadeia que gerou um contrato com cláusulas de escravidão digital. Foi horrível. Mas na etapa 3, pedi: "confirme se todos os termos estão em conformidade com a LGPD". Ela respondeu: "não, este trecho viola o art. 6º". E eu corrigi. Sem isso, eu teria enviado um documento criminoso.

Não é sobre confiar na IA. É sobre não confiar em você mesmo. Porque você vai errar. Ela vai errar. Mas juntos, com estrutura, vocês podem chegar perto do certo.