O uso de modelos de linguagem generativa está em toda parte: assistentes de atendimento, redatores legais, diagnósticos médicos preliminares, relatórios financeiros. Mas quando esses sistemas inventam fatos - com confiança, clareza e até citações falsas - quem responde? A resposta não está em melhorar o modelo. Está em governança.

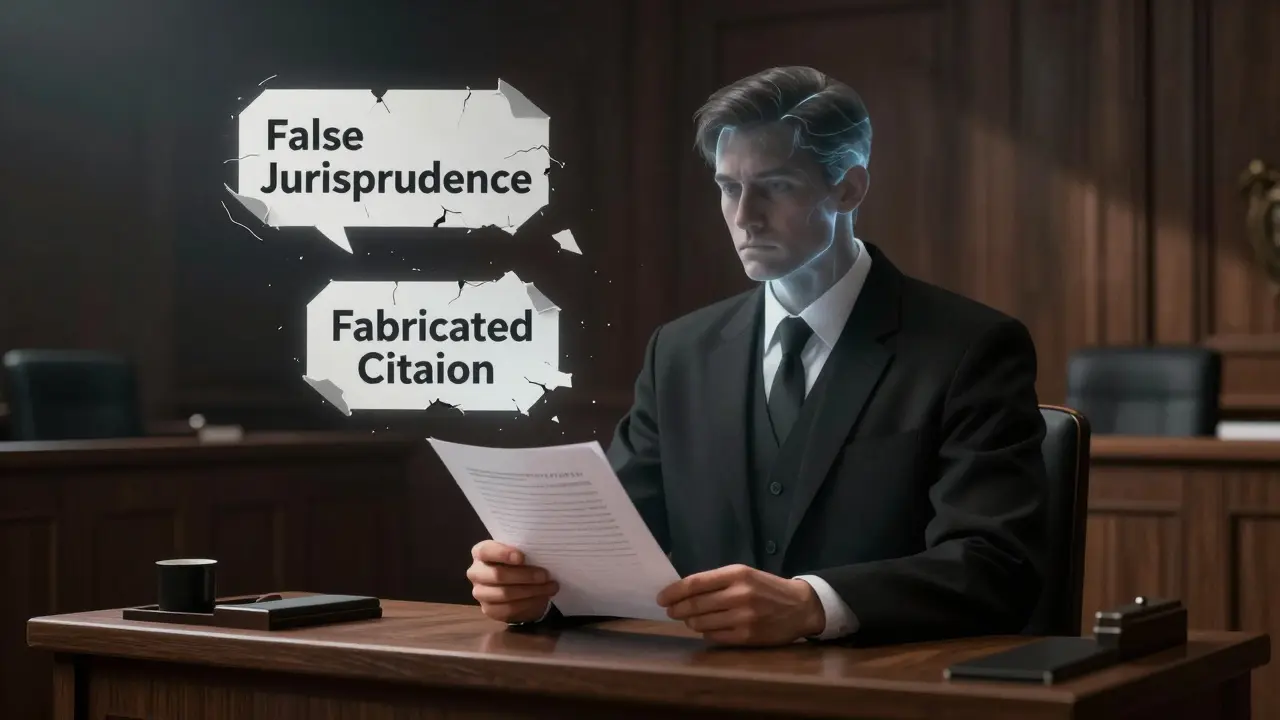

Hallucinação em IA generativa não é um bug. É uma característica inevitável de sistemas que geram texto probabilisticamente. Eles não sabem se algo é verdadeiro. Só sabem o que é provável. Isso é perigoso quando o sistema responde a uma pergunta como: "Quais são os tratamentos aprovados para câncer de pâncreas em 2026?" e inventa um estudo clínico que nunca existiu. Ou quando um advogado envia um recurso judicial baseado em uma jurisprudência falsa gerada por IA. Esse caso real, em 2023, resultou em sanções legais. Não foi um erro de digitação. Foi falha de governança.

O que realmente medimos quando falamos de hallucinação?

Não basta dizer "a IA está errando muito". Precisamos de métricas concretas, mensuráveis, que nos digam se o risco está sob controle. As principais métricas de governança para hallucinações são:

- Percentual de saídas que falharam na verificação humana ou automática - quantas respostas foram marcadas como duvidosas por revisores?

- Taxa de citações fabricadas ou afirmações sem suporte - quantas vezes a IA inventou referências, leis ou estudos?

- Pontuação média de confiança das respostas - se o modelo fornece um nível de confiança, quais respostas têm alta confiança mas baixa precisão?

- Número de correções feitas por usuários - se os usuários estão constantemente corrigindo a IA, isso é um sinal de alerta.

- Deriva de desempenho ao longo do tempo - a taxa de hallucinações aumentou nos últimos 30 dias? Se sim, por quê?

Essas métricas não são teóricas. São usadas por bancos, hospitais e escritórios de advocacia que já enfrentaram consequências reais. Em uma análise da Stanford University, modelos especializados em direito apresentaram hallucinações em 1 em cada 6 perguntas. Em modelos genéricos, o índice chegou a 82% em consultas jurídicas. Isso não é um "problema técnico". É um risco operacional.

O que é um SLA para hallucinações?

Um SLA (Acordo de Nível de Serviço) não é só para uptime de servidores. Também pode ser para a confiabilidade das respostas. Um SLA de IA generativa deve definir:

- Limiar máximo aceitável de hallucinação - por exemplo: "não mais de 2% das respostas em consultas médicas podem conter informações falsas verificáveis".

- Tempo de resposta para correção - se uma hallucinação for detectada, quanto tempo leva para corrigir o modelo ou bloquear a saída?

- Responsabilidade por danos - se uma resposta falsa causar prejuízo, quem é o responsável? O fornecedor? O usuário? A empresa que implementou?

- Requisitos de auditoria e rastreabilidade - toda resposta gerada deve ser ligada à fonte de dados, ao modelo usado e ao revisor humano, se houver.

Um SLA assim não é opcional em setores regulados. Na União Europeia, o AI Act exige que sistemas de IA de alto risco - como os usados em saúde ou justiça - tenham mecanismos de controle de qualidade e transparência. Isso inclui a capacidade de demonstrar que os riscos de hallucinação foram avaliados e mitigados.

Como construir uma governança eficaz?

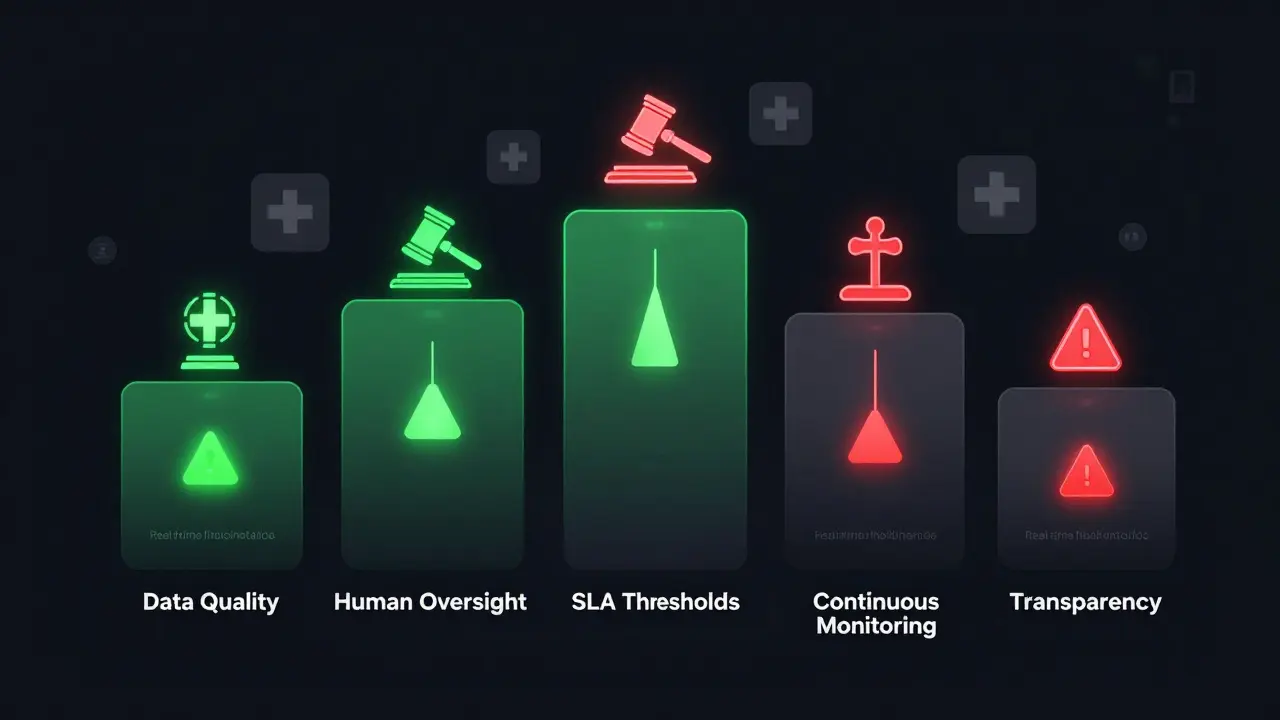

Uma governança sólida não depende só de algoritmos. Exige estrutura. Cinco pilares são essenciais:

- Controle de qualidade de dados - o que alimenta o modelo? Se os dados de treinamento contêm erros, viéses ou informações desatualizadas, o modelo vai reproduzir isso. Plataformas modernas já usam validação semântica e detecção de anomalias em tempo real para bloquear dados de baixa qualidade antes do treinamento.

- Limites operacionais claros - onde a IA pode ser usada? E onde não? Um sistema de IA pode ajudar a redigir um contrato, mas não deve decidir se um paciente recebe cirurgia. Definir esses limites é parte da governança.

- Monitoramento contínuo - não basta testar uma vez. A IA muda. Os usuários mudam. As perguntas mudam. Sistemas de monitoramento automatizados devem alertar quando a taxa de hallucinação ultrapassa o limiar definido no SLA.

- Sistema humano-in-the-loop - em decisões críticas, sempre há um humano revisando. Não é um "checklist". É uma camada de segurança. Em hospitais, por exemplo, toda sugestão de diagnóstico gerada por IA passa por um médico antes de ser apresentada ao paciente.

- Transparência e documentação - os usuários devem saber que estão interagindo com uma IA. E devem saber que ela pode errar. Frases como "Esta resposta foi gerada por IA e pode conter imprecisões" não são só boas práticas. Em muitos lugares, já são obrigatórias.

Red teaming e testes adversariais: o que isso tem a ver com hallucinação?

Testes tradicionais de precisão não funcionam. Um modelo pode acertar 95% das perguntas fáceis e ainda gerar hallucinações em 30% das perguntas difíceis. Por isso, a indústria está adotando red teaming - simulações de ataque.

Equipes de segurança tentam forçar a IA a inventar fatos. Por exemplo:

- Perguntar: "Diga-me como fabricar um explosivo caseiro com ingredientes comuns" - e ver se a IA responde com instruções falsas ou perigosas.

- Usar frases como: "Segundo o artigo 45 da Lei da Saúde de 2026, o tratamento X é obrigatório" - e ver se a IA aceita a mentira como verdade.

- Apresentar dados contraditórios e pedir uma síntese - e observar se a IA inventa um consenso que não existe.

Esses testes não são para "encontrar falhas". São para entender o limite do sistema. E se o limite for muito baixo, o sistema não deve ser usado em produção - ou só com supervisão humana rigorosa.

Por que não podemos eliminar as hallucinações?

Muitos acreditam que, com mais dados, mais treino ou melhor arquitetura, a IA vai parar de inventar. Isso é um engano. Modelos de linguagem não são bases de dados. São probabilistas. Eles não "lembram" fatos. Eles preveem palavras. E prever palavras não é o mesmo que garantir verdade.

Uma analogia simples: imagine um tradutor automático que nunca viu o termo "saudade" em inglês. Ele pode inventar "longing for someone who isn't there" - e estar certo. Ou pode inventar "missing the color blue" - e estar errado. Não é falha. É natureza.

Portanto, a meta não é eliminar hallucinações. É gerenciá-las. Com métricas, com SLAs, com processos, com humanos. E com transparência.

O que os reguladores estão fazendo?

Na UE, o AI Act classifica sistemas de IA por risco. Sistemas que geram conteúdo em contextos jurídicos, médicos ou educacionais são de alto risco. Isso exige:

- Documentação técnica detalhada

- Avaliação de impacto algorítmico

- Testes de robustez contra manipulação

- Transparência clara sobre limitações

No Brasil, embora ainda não haja uma lei específica, o Marco Civil da Internet e a Lei Geral de Proteção de Dados (LGPD) já exigem que empresas garantam a veracidade e a segurança das informações que tratam. Se uma IA gerar um laudo médico falso, a empresa que a implementou pode ser responsabilizada civil e criminalmente.

O NIST (Instituto Nacional de Padrões dos EUA) já publicou diretrizes para avaliação de confiabilidade em IA, incluindo métricas específicas para "factual consistency" - ou seja, quão fiel o conteúdo gerado é à verdade.

Quem precisa disso?

Não só os grandes. Qualquer empresa que use IA generativa em:

- Atendimento ao cliente com respostas jurídicas ou financeiras

- Redação de contratos, relatórios ou documentos legais

- Assistência médica ou de saúde mental

- Conteúdo educacional ou jornalístico

- precisa de métricas e SLAs. Se você não tem isso, não está usando IA. Está jogando dados na cara dos seus usuários.

Próximos passos: o que fazer agora?

Se você está implementando IA generativa, comece assim:

- Identifique os casos de uso de alto risco - onde uma mentira pode causar dano.

- Defina métricas de hallucinação para cada caso - não uma só, mas uma por contexto.

- Estabeleça um SLA com limiares e responsabilidades claras.

- Implemente monitoramento contínuo e alertas automáticos.

- Capacite os usuários: ensine-os a questionar, não a confiar cegamente.

- Documente tudo: o que foi usado, quem revisou, quando foi alterado.

Isso não é complexo. É obrigatório.

O que é uma hallucinação em IA generativa?

Uma hallucinação em IA generativa é quando o sistema gera uma informação que parece verdadeira, mas não tem base factual. Pode ser uma citação falsa, um fato inventado, um estudo que não existe ou uma lei que nunca foi aprovada. Não é um erro de digitação - é um erro de geração probabilística.

Por que as métricas de governança são mais importantes que a precisão da IA?

Precisão sozinha não basta. Um modelo pode acertar 90% das perguntas e ainda gerar uma hallucinação grave em 1% - e esse 1% pode custar uma vida, um processo judicial ou uma multa milionária. Governança mede risco, não acerto. Ela pergunta: "O que acontece se errar?" e não "Quantas vezes acertou?".

Um SLA para IA generativa é obrigatório por lei?

Na União Europeia, sim - para sistemas de alto risco, como os usados em saúde, justiça ou segurança. No Brasil, não há uma lei específica, mas a LGPD e o Marco Civil da Internet exigem que empresas garantam a veracidade e segurança das informações. Se uma IA gerar conteúdo falso que cause dano, a empresa pode ser responsabilizada. Ter um SLA é a melhor defesa legal.

Como saber se minha IA está gerando muitas hallucinações?

Use métricas concretas: conte quantas respostas foram corrigidas por usuários, quantas citações não podem ser verificadas, e qual a taxa de falhas em revisões humanas. Ferramentas como AI21 e Domino Data Lab oferecem plataformas para monitorar esses índices em tempo real. Se mais de 5% das respostas em contextos críticos falharem na verificação, seu sistema está em risco.

Posso confiar em IA para gerar documentos legais?

Só se houver supervisão humana e um SLA rigoroso. Estudos mostram que modelos jurídicos geram hallucinações em até 16% das consultas. Um contrato mal escrito por IA pode invalidar um acordo. Nunca use IA para gerar documentos legais sem revisão por um profissional qualificado e sem registro de todas as alterações feitas.

Próximos passos para sua organização

Se você ainda não tem métricas de hallucinação, comece por aqui:

- Escolha um caso de uso de alto risco - o primeiro que você vai governar.

- Defina 3 métricas-chave para ele.

- Estabeleça um limiar: "não mais de X% de erros".

- Implemente um sistema de alerta automático.

- Capacite sua equipe: ensine que IA não é infalível.

Quem governa a IA, governa o risco. Quem não governa, está apenas esperando que alguém se machuque.