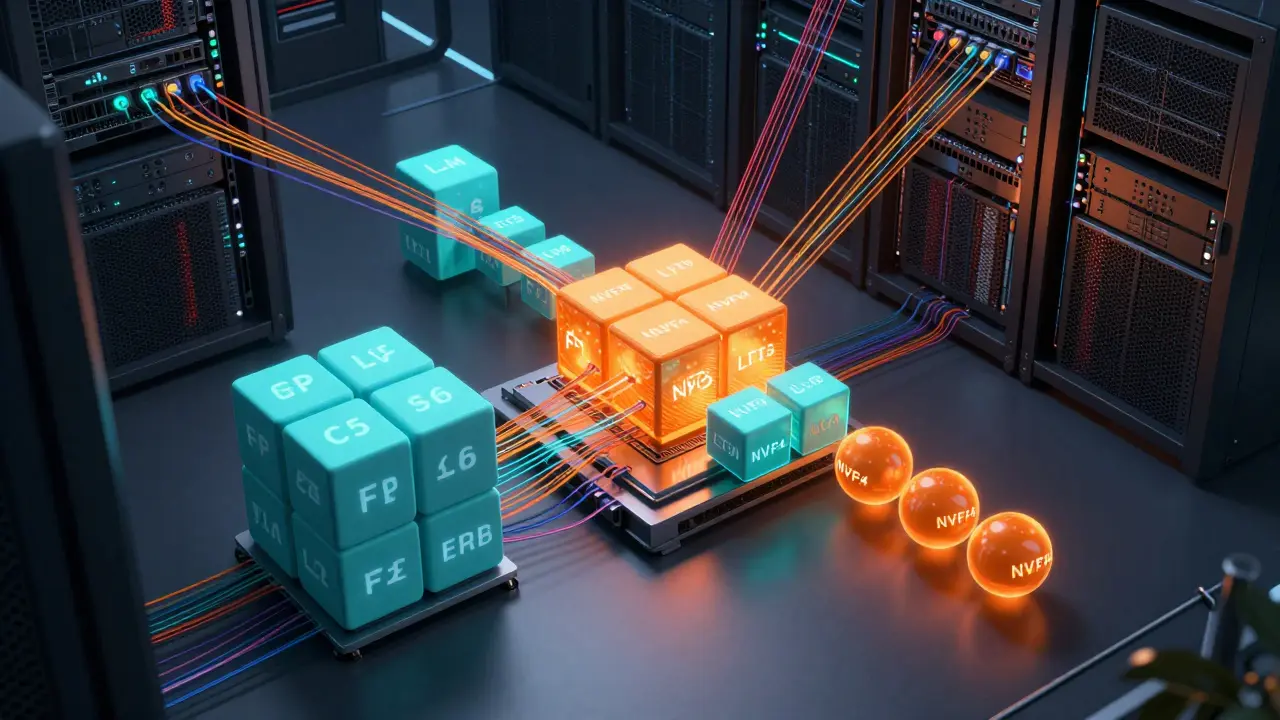

Se você já usou um modelo de linguagem grande (LLM) e notou que ele demora para responder frases longas, ou que seu computador trava ao gerar textos de milhares de palavras, o problema não está no modelo. Está na forma como ele calcula a atenção. E a solução? KV caching e batch contínuo.

O que é KV caching e por que ele muda tudo

Quando um LLM gera texto token por token, ele precisa calcular a atenção em cada passo. Sem otimização, isso significa recalcular todas as palavras anteriores a cada novo token. Imagine escrever um livro e, antes de escrever cada frase, reler todo o que já foi escrito. Isso é ineficiente. O KV caching resolve isso armazenando os resultados da atenção já calculados - os keys e values - em memória.Isso reduz a complexidade de cálculo de O(n²) para O(n) por token. Em termos práticos: para uma sequência de 2.000 tokens, o modelo não precisa mais fazer 4 milhões de cálculos a cada passo. Ele só calcula o token atual e recupera os anteriores da memória. Isso é o que permite que modelos como LLaMA-3 8B gerem respostas de 4.000 tokens em segundos, em vez de minutos.

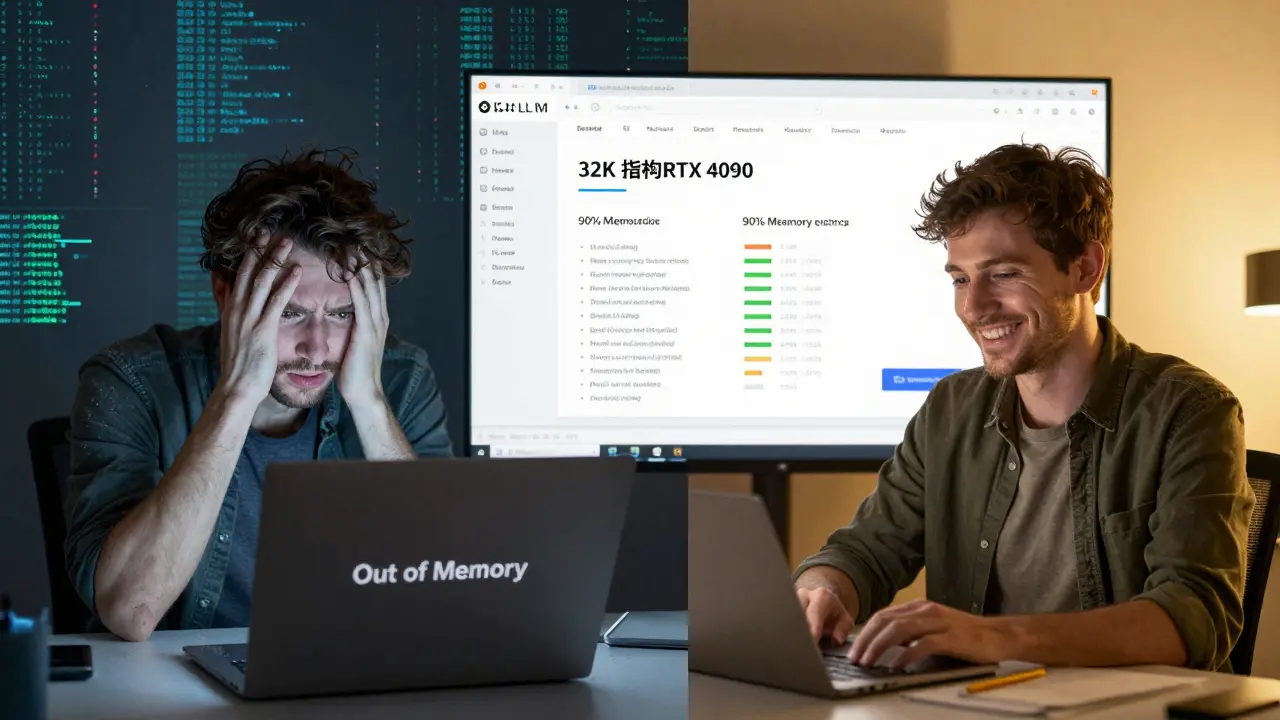

Mas há um preço: memória. O cache de KV cresce linearmente com o tamanho do contexto. Para um modelo de 7 bilhões de parâmetros, gerando 32.000 tokens em FP16, o cache ocupa cerca de 13,4 GB - mais que o próprio modelo. Em GPUs de entrada, isso é um problema. Segundo dados da NVIDIA de 2025, 68% das tentativas de implantação de LLMs em ambientes de borda falham só por causa do consumo de memória do cache.

Como a compressão do cache está resolvendo o problema de memória

A solução não é apenas ter mais memória. É usar melhor o que já tem. Técnicas como NVFP4, desenvolvida pela NVIDIA, reduzem o tamanho do cache em 50% sem perder quase nada de precisão. Em 12 testes de benchmark, a perda de acurácia foi inferior a 1%. Isso significa que você pode rodar um modelo de 7B em uma RTX 4090 com contexto de 32k tokens - algo que antes exigia uma A100.Outra inovação é o SpeCache, que comprime o cache em 2,3x com apenas 0,8% de aumento na perplexidade. Isso é crucial para aplicações que precisam de longos contextos, como análise de contratos ou resumos de livros. E o KVzip? Ele chega a 4x de compressão, mesmo com contextos de até 170k tokens.

Mas nem tudo são flores. Essas compressões têm custos. NVFP4 só funciona em GPUs da arquitetura Blackwell (RTX 6000 Ada e superiores). E mesmo com compressão, há perda de precisão - 0,9% em MMLU, 1,2% em GSM8K. Para tarefas criativas, como gerar histórias, a degradação pode chegar a 3-5%, segundo o Microsoft Research. Isso não é negligenciável.

Batch contínuo: quando vários pedidos se tornam um só

Imagine que você tem 10 usuários pedindo respostas ao mesmo tempo. Sem batch contínuo, o servidor processa cada pedido em sequência: um por um. Cada um espera seu turno. Com batch contínuo, o sistema agrupa pedidos que estão em diferentes estágios de geração. Um usuário pode estar no 5º token, outro no 12º, outro no 1º. O modelo processa todos juntos, aproveitando os mesmos cálculos de atenção e memória.Isso aumenta o throughput em até 3,8x em comparação com o processamento individual. A vLLM, uma das principais bibliotecas open-source, usa essa técnica e já é adotada por 31% das empresas que implementam LLMs em produção, segundo a O’Reilly. A Scale AI relatou um aumento de 4,1x no throughput de seu chat API após implementar batch contínuo com KV caching.

Mas há um detalhe: latência variável. Enquanto o throughput sobe, o tempo de resposta individual pode oscilar. Um usuário pode esperar 2 segundos, outro 5. Isso acontece porque o sistema prioriza eficiência geral, não resposta rápida para cada um. Para aplicações como assistentes em tempo real, isso pode ser um problema. Mas para chatbots de suporte, APIs de resumo ou sistemas de geração em lote? É perfeito.

Quem está usando isso e por que

Na prática, as empresas que mais se beneficiam são as que lidam com alto volume de requisições. Anthropic reduziu seus custos de infraestrutura em 2,3 milhões de dólares por mês só com compressão de cache. O mesmo aconteceu com empresas de atendimento ao cliente que escalaram de 100 para 10.000 requisições por minuto.Desenvolvedores individuais também estão adotando. Um usuário do Reddit, @LLM_developer42, relatou que, com KV caching e NVFP4 em uma RTX 4090, reduziu o tempo de geração de uma resposta de 4.000 tokens de 3 minutos para 15 segundos. Isso é transformador para quem está treinando ou testando modelos localmente.

Por outro lado, quem tenta rodar isso em dispositivos móveis ou em nuvens baratas enfrenta desafios. O transferência de cache entre CPU e GPU adiciona 18-22ms por operação - o suficiente para causar lentidão perceptível. E o PyTorch, por padrão, não gerencia memória contígua bem, o que aumenta o overhead em 15-18%. A solução? Usar frameworks como vLLM, que já resolvem isso por você.

Como começar a usar

Se você quer implementar isso, aqui vai o passo a passo real:- Use uma GPU da arquitetura Ada ou Blackwell (RTX 4090, RTX 6000 Ada, etc.) para aproveitar NVFP4.

- Instale a vLLM 0.5.1 ou superior. É a implementação mais madura e documentada.

- Configure o tamanho do cache para 50-70% da memória VRAM disponível.

- Use NVFP4 se possível. Se não, use FP8. Evite FP16 a menos que tenha mais de 48GB de VRAM.

- Habilite batch contínuo (está ativado por padrão na vLLM).

- Monitore a utilização de memória com

nvidia-smie ajuste o tamanho máximo do contexto conforme necessário.

Desenvolvedores levam em média 2-3 semanas para dominar essas configurações, segundo dados da Lambda Labs. O maior erro? Ignorar a compressão. Muitos tentam rodar LLMs com contexto longo usando FP16 sem cache comprimido - e desistem porque o GPU trava.

O futuro: o que vem por aí

O que está por vir é ainda mais interessante. A Meta já anunciou que o Llama 4 terá redimensionamento dinâmico de cache - o sistema ajusta automaticamente o tamanho do cache conforme o contexto necessário. Isso elimina a necessidade de definir limites rígidos.Google DeepMind sugeriu em novembro de 2025 que modelos futuros podem ser projetados desde o início para serem “cache-aware”. Isso significa que a arquitetura da atenção será reescrita para reduzir o cache em 3-5x sem compressão. É como construir uma casa com paredes que já têm isolamento embutido, em vez de adicionar isolamento depois.

Segundo a Gartner, até 2026, todas as plataformas comerciais de LLM terão essas técnicas como padrão. E o mercado de otimização de inferência deve chegar a 4,8 bilhões de dólares até 2027. Isso não é uma tendência. É uma exigência.

Conclusão: eficiência não é opcional, é obrigatória

Se você está trabalhando com LLMs em produção - seja em uma startup, em uma grande empresa ou só por hobby - ignorar KV caching e batch contínuo é como tentar dirigir um carro sem combustível. Você pode começar, mas não vai chegar longe.O custo de não fazer isso é alto: mais servidores, mais energia, mais latência, mais frustração. E o ganho? Menos de 1% de perda de qualidade por até 5x de redução de custo. É uma troca que qualquer engenheiro de IA deve fazer.

Os modelos estão ficando maiores. Os contextos estão ficando mais longos. E a memória? Ela não cresce na mesma velocidade. Então, otimizar o que já tem é a única forma de continuar avançando. Não é mágica. É engenharia.

O que é KV caching e como ele melhora a velocidade dos LLMs?

KV caching armazena os resultados das operações de atenção (keys e values) já calculadas durante a geração de texto. Em vez de recalcular todas as palavras anteriores a cada novo token, o modelo apenas recupera esses valores da memória. Isso reduz a complexidade de cálculo de O(n²) para O(n), tornando a geração de textos longos viável. Sem isso, gerar 2.000 tokens exigiria milhões de cálculos repetidos.

Por que o cache de KV consome tanta memória?

O cache cresce linearmente com o tamanho do contexto e o número de camadas do modelo. Para um LLM de 7B em FP16, cada token adicionado consome cerca de 2 bytes × 32 camadas × 32 cabeças × 4.096 dimensões. Para 32.000 tokens, isso soma 13,4 GB. Em modelos maiores ou com mais camadas, o valor pode ultrapassar 50 GB. Isso supera o tamanho dos próprios pesos do modelo em contextos longos.

Qual é a diferença entre NVFP4 e FP8?

NVFP4 é uma técnica proprietária da NVIDIA que usa 4 bits por valor, reduzindo o cache em 50% com perda de precisão inferior a 1%. FP8 usa 8 bits e reduz em 50% em relação ao FP16, mas não é tão eficiente quanto NVFP4. Em testes, NVFP4 mantém 99,3% da acurácia em tarefas de conhecimento, enquanto FP8 cai para 97,1%. Além disso, NVFP4 só funciona em GPUs Blackwell, enquanto FP8 é compatível com várias arquiteturas.

O batch contínuo aumenta a latência para usuários individuais?

Sim, pode aumentar a variabilidade da latência. Enquanto o throughput geral melhora muito (até 3,8x), um usuário pode esperar mais tempo se seu pedido estiver em um lote com pedidos mais longos. Isso acontece porque o sistema prioriza processar vários pedidos juntos, não responder o mais rápido possível. Para aplicações que exigem respostas rápidas e consistentes, como chatbots em tempo real, isso pode ser um problema. Para processamento em lote, é ideal.

Posso usar KV caching em um laptop com uma GPU de entrada?

É possível, mas com limitações. Em GPUs com menos de 16GB de VRAM, você só conseguirá contextos curtos (até 4k tokens) sem compressão. Com NVFP4, é possível chegar a 8k em uma RTX 4060. Para contextos maiores, você precisará de compressão como SpeCache ou reduzir o número de camadas. Mas em laptops sem GPU dedicada, não é viável - o cache ocupa mais memória que o próprio modelo.

Quais frameworks devo usar para implementar isso?

A vLLM é a escolha mais madura e documentada, com suporte nativo a KV caching, batch contínuo e NVFP4. Text Generation Inference (TGI) da Hugging Face também é bom, mas menos otimizado para batch contínuo. Se você está em produção e quer desempenho, vá de vLLM. Se está aprendendo, comece com o exemplo oficial da vLLM no GitHub - tem tutoriais atualizados semanalmente.

KV caching é necessário para todos os modelos de linguagem?

Não. Para modelos pequenos (menos de 1B de parâmetros) e contextos curtos (até 512 tokens), o ganho é mínimo. Mas para qualquer LLM com mais de 7B de parâmetros e contextos acima de 2k tokens, é essencial. Sem ele, a inferência é lenta, cara e inviável em produção. A indústria já adotou isso como padrão - 82% das empresas que usam LLMs em 2025 já implementam KV caching.

Quais são os riscos de usar compressão de cache?

O principal risco é perda de qualidade em tarefas criativas ou de precisão. Técnicas como NVFP4 e SpeCache podem aumentar a perplexidade em 1-5%, o que afeta a coesão de histórias, a precisão de cálculos ou a fidelidade a fatos. Em aplicações de alta confiança - como diagnósticos médicos ou análise jurídica - isso exige monitoramento adicional. A União Europeia já está discutindo regulamentações que exigem divulgação dessas perdas em aplicações de risco alto.

2 Comentários

Essa porra de KV caching é só mais um truque de engenheiro que não resolve o problema real: GPU brasileira é lixo e ninguém tem grana pra A100. Mas tá bom, vamos continuar fingindo que isso é acessível pra quem não mora na Califórnia.

Se você não sabe que NVFP4 só funciona em Blackwell, você não deveria estar lendo isso. Isso aqui é pra quem já tem GPU de verdade, não pra quem usa RTX 3050 com 6GB e acha que é gamer. Pare de reclamar e compre um hardware decente.