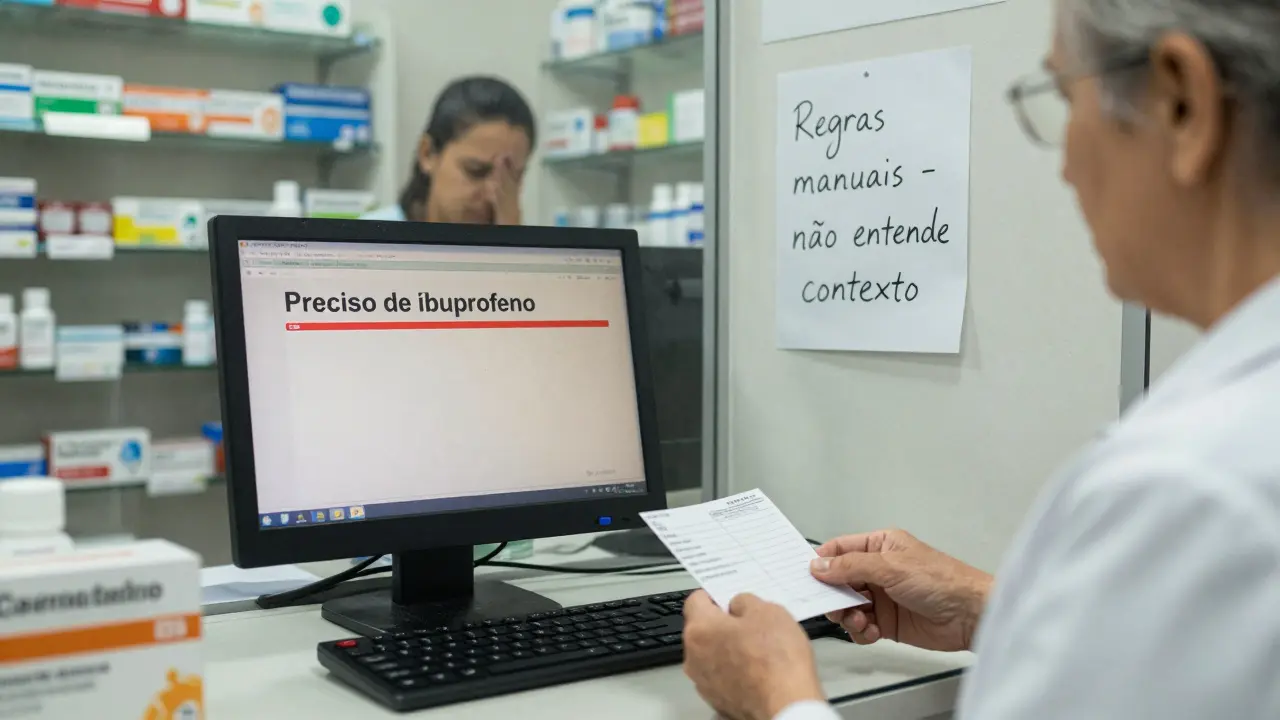

Em 2015, um sistema de atendimento ao cliente em uma grande rede de farmácias no Brasil ainda usava regras manuais para entender pedidos de reposição de remédios. Se o cliente digitasse "preciso de ibuprofeno", o sistema respondia corretamente. Mas se dissesse "meu pé tá doendo, tem algo que alivia?" - falhava. Isso não era falha de programação. Era limitação de NLP estatístico.

Hoje, o mesmo sistema responde com naturalidade, sugere opções de analgésicos, até pergunta se o cliente tem alergia. Tudo isso graças a NLP neural - e, mais especificamente, aos grandes modelos de linguagem (LLMs). O que mudou? Nada menos que a forma como máquinas entendem e geram linguagem humana.

O que é NLP estatístico - e por que ele foi revolucionário na sua época

Antes de 2010, o NLP não tinha "inteligência". Tinha estatística. Modelos como Cadeias de Markov e modelos de n-gramas contavam quantas vezes certas palavras apareciam juntas em textos. Se "vou ao" aparecia 1.200 vezes antes de "médico" e apenas 80 vezes antes de "supermercado", o sistema escolhia "médico" como a próxima palavra mais provável.

Essa abordagem funcionava bem para tarefas simples: corretor ortográfico, autocompletar de teclado T9, ou até tradução básica de frases curtas. Bibliotecas como NLTK e spaCy, criadas nos anos 2000, se tornaram padrão em universidades e startups. Era possível rodar esses sistemas em um laptop com 4GB de RAM.

Os modelos eram pequenos - poucos milhões de parâmetros. Eram transparentes: você podia abrir o código e ver exatamente por que uma palavra foi escolhida. Isso era crucial em áreas como saúde e finanças, onde cada decisão precisa ser explicada a auditores, médicos ou reguladores.

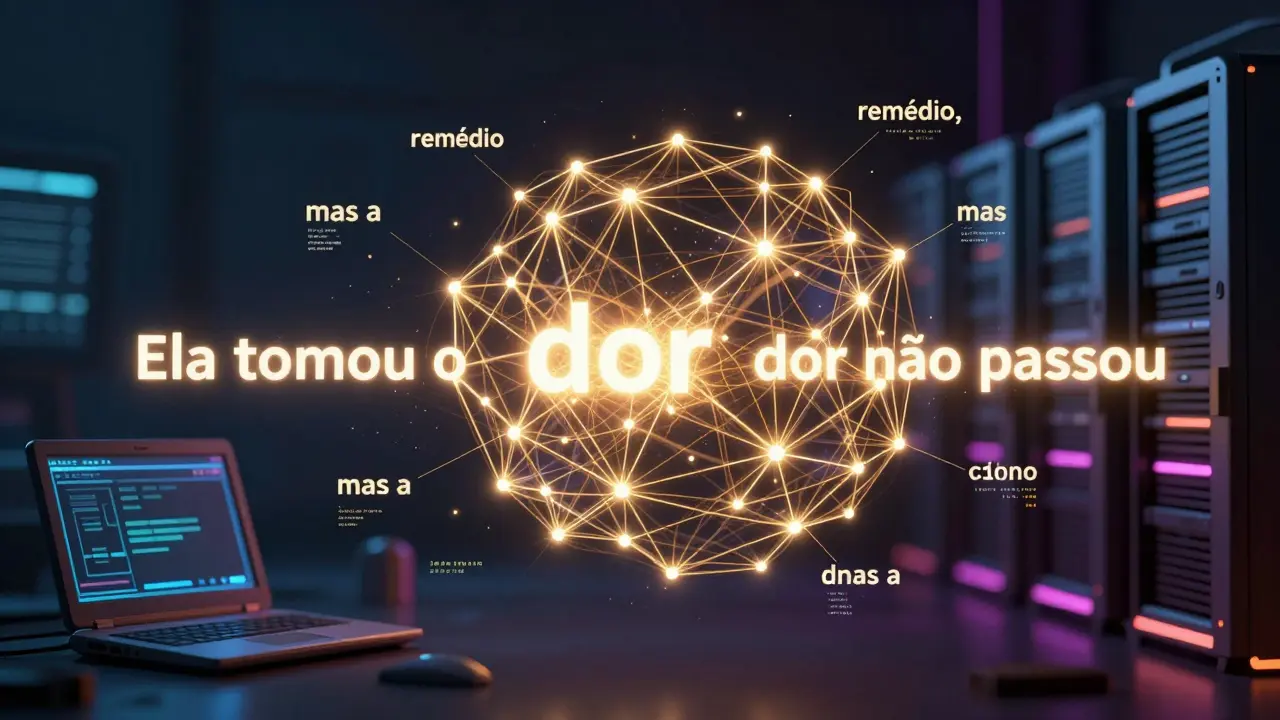

Mas tinha um problema gigante: não entendia contexto. Se você dissesse "A dor está piorando depois que tomei o remédio", o sistema não sabia que "remédio" era o sujeito da dor. Ele só via pares de palavras. Era como tentar entender um romance lendo só frases soltas.

A revolução que ninguém previa: o Transformer e o fim da era estatística

Tudo mudou em dezembro de 2017, com um artigo de apenas 12 páginas: "Attention Is All You Need". Pesquisadores do Google Brain apresentaram o Transformer - uma arquitetura que não olhava palavras uma por uma, mas todas ao mesmo tempo.

Em vez de prever a próxima palavra com base só na anterior, o Transformer analisava a relação entre "dor" e "remédio" mesmo que estivessem separados por cinco palavras. Isso se chamava "atenção" - e permitia que a máquina entendesse que "ela" em "Ela tomou o remédio, mas a dor não passou" se referia à pessoa, não ao remédio.

Em 2018, o BERT chegou - um modelo treinado com bilhões de palavras de artigos da Wikipédia e livros. Ele não só entendia contexto, mas conseguia responder perguntas como "Quem descobriu a penicilina?" com base em trechos que nunca havia visto antes. Em 2020, o GPT-3 surgiu com 175 bilhões de parâmetros. Ele escrevia poemas, códigos, e-mails profissionais e até ensaios acadêmicos.

Os números falaram mais alto: enquanto modelos estatísticos alcançavam 65% de precisão em tarefas de linguagem, o BERT chegou a 93,2%. O GPT-3 fez 86,4% no SuperGLUE - um teste que exigia raciocínio, lógica e entendimento de ambiguidade. Em 2023, publicações científicas sobre NLP neural superaram as estatísticas em quase cinco vezes.

Por que os LLMs venceram - e onde ainda falham

Os modelos de linguagem grandes não são apenas mais precisos. Eles são versáteis. Um único modelo pode traduzir, resumir, classificar, responder perguntas e até criar conteúdo criativo - tudo com o mesmo sistema. Antes, você precisava de um modelo para cada tarefa: um para tradução, outro para análise de sentimento, outro para extração de entidades.

Na prática, isso mudou negócios. Um hospital em São Paulo usava regras manuais para identificar diagnósticos em prontuários. Levaria semanas para atualizar as regras. Hoje, usa um LLM fine-tuned: em horas, aprende novas terminologias e detecta condições raras com 91% de precisão.

Mas o preço é alto. Treinar o GPT-3 custou US$ 4,6 milhões. Rodar uma versão mínima exige GPUs com centenas de gigabytes de memória. E os modelos são caixas pretas: em 78% dos casos, não é possível dizer por que ele escolheu uma resposta. Isso é um problema em áreas reguladas. Um médico não pode prescrever um tratamento baseado em algo que ninguém entende.

Além disso, eles inventam coisas. Em 2023, um estudo da Stanford HAI mostrou que 18 a 25% das respostas de LLMs contêm informações falsas - e elas soam plausíveis. Um paciente perguntou: "Qual é a dose segura de ibuprofeno para crianças?" O LLM respondeu corretamente - mas citou um estudo que não existe. Isso é chamado de "alucinação".

Quem ainda usa NLP estatístico? E por quê?

Apesar da explosão dos LLMs, o NLP estatístico não morreu. Ele se adaptou.

Na área de saúde, muitos hospitais brasileiros ainda usam spaCy com regras de correspondência para extrair nomes de medicamentos de prontuários. Por quê? Porque precisa ser 100% confiável. Se o sistema errar e sugerir um remédio que o paciente é alérgico, é risco de vida. Regras manuais não inventam nada. Elas só reconhecem o que já foram programadas para ver.

Empresas de seguros e bancos também preferem modelos tradicionais para análise de documentos legais. Um contrato de seguro pode ter 50 páginas. Um LLM pode resumir, mas não consegue garantir que não omitiu uma cláusula de exclusão. Um modelo estatístico com regras definidas por advogados pode.

Na prática, isso virou uma estratégia híbrida. Um sistema pode usar spaCy para extrair entidades (nomes, datas, medicamentos) e depois passar o contexto para um LLM para gerar um relatório em linguagem natural. Em 2022, um estudo da Universidade de Stanford mostrou que esse tipo de sistema combinado atingiu 89,7% de precisão - melhor que qualquer um isolado.

Quem ganha com cada abordagem? Um comparativo real

| Característica | NLP Estatístico | NLP Neural (LLMs) |

|---|---|---|

| Parâmetros | 10³ a 10⁶ | 10⁹ a 10¹² |

| Hardware necessário | Laptop com 4GB RAM | GPU com 700GB+ de memória |

| Precisão em tarefas complexas | 60-75% | 85-95% |

| Entendimento de contexto | Baixo - só palavras vizinhas | Alto - usa atenção em toda a frase |

| Interpretabilidade | Alta - regras visíveis | Baixa - caixa preta |

| Tempo de implementação | 2-4 semanas | 3-6 meses |

| Custo operacional | Baixo - centavos por requisição | Alto - US$ 0,02 por 1.000 tokens |

| Principais ferramentas | NLTK, spaCy, Stanford CoreNLP | GPT, BERT, Llama, Claude |

O futuro não é um ou outro - é os dois juntos

Os grandes nomes da área já estão dizendo isso: o futuro não é escolher entre estatístico e neural. É combinar.

Yoshua Bengio, ganhador do Prêmio Turing, fala em "neuro-simbólico" - modelos que usam redes neurais para reconhecer padrões e regras simbólicas para garantir lógica e precisão. Em maio de 2023, o Google lançou o Atlas, que busca informações em bancos de dados confiáveis antes de gerar respostas - reduzindo alucinações em 34%.

Em dezembro de 2023, a Microsoft lançou o Phi-2: um modelo com apenas 2,7 bilhões de parâmetros, mas que performa como modelos 10 vezes maiores. Isso prova que qualidade de dados importa mais que tamanho. E isso é um retorno às raízes do NLP estatístico: cuidado com o que você ensina, não só com quantas palavras você usa.

Indústrias reguladas - saúde, finanças, jurídico - já estão adotando esse caminho. Um relatório da IDC prevê que, até 2026, 65% das novas implementações de NLP em empresas serão híbridas.

Como escolher o que usar - e quando

Se você está começando:

- Use NLP estatístico se: precisa de confiança absoluta, tem poucos recursos, trabalha em áreas reguladas, ou precisa explicar cada decisão.

- Use NLP neural se: quer criar conteúdo, atender clientes com respostas naturais, lidar com linguagem informal ou tem acesso a infraestrutura e dados de qualidade.

- Use ambos se: quer o melhor dos dois mundos - precisão + criatividade, controle + escalabilidade.

Um desenvolvedor de um app de saúde no Rio de Janeiro me contou: "Usei spaCy para extrair sintomas dos relatos dos pacientes. Depois, passei para um LLM para gerar um resumo em linguagem simples. Resultado? 80% menos tempo de trabalho dos médicos, e os pacientes entendem melhor. E se o LLM errar? O sistema ainda mostra a origem do dado - a regra do spaCy. Assim, ninguém perde o controle."

Desafios que ninguém fala - e o que vem por aí

Os LLMs consomem tanta energia que um único treinamento emite 284 toneladas de CO₂ - equivalente ao uso de cinco carros durante toda a vida útil. Isso não é só um problema ambiental. É um problema de sustentabilidade.

Empresas pequenas não podem pagar por isso. E reguladores estão começando a exigir transparência. Em 2024, a ANS (Agência Nacional de Saúde) no Brasil passou a exigir que sistemas de IA em saúde mostrem como chegaram a uma conclusão. LLMs puros não conseguem.

Enquanto isso, o mercado cresce. Em 2022, o valor global do NLP era de US$ 13,87 bilhões. Em 2030, deve chegar a US$ 100 bilhões. Mas o crescimento não será só de LLMs. Será de soluções inteligentes - que sabem quando usar uma regra simples e quando usar uma rede neural.

Como disse Timnit Gebru, ex-líder de ética da Google: "O custo computacional pode forçar um retorno às formas mais eficientes. E talvez, no fim, a melhor IA seja a que sabe quando não precisar ser tão grande."

NLP estatístico ainda é útil hoje?

Sim. Em áreas onde precisão, explicabilidade e baixo custo são mais importantes do que criatividade - como saúde, direito e finanças - modelos estatísticos como spaCy e NLTK ainda são essenciais. Eles não inventam respostas, não consomem muita energia e podem ser auditados. Muitas empresas usam eles em combinação com LLMs para garantir segurança.

Por que LLMs geram informações falsas?

LLMs não "sabem" nada. Eles preveem a próxima palavra com base em padrões aprendidos. Se em milhões de textos a frase "a penicilina foi descoberta por Alexander Fleming" aparece junto com dados errados, o modelo pode repeti-la mesmo que seja falsa. Isso é chamado de "alucinação". Não é erro de programação - é uma consequência do modo como eles aprendem.

Posso usar LLMs em um projeto com orçamento limitado?

Sim, mas com cuidado. Você não precisa treinar um modelo do zero. Use APIs como GPT-3.5-turbo ou modelos abertos como Llama 3. Comece com tarefas simples, como resumir textos ou responder perguntas frequentes. Evite usá-los em decisões críticas sem verificação humana. O custo por requisição é baixo - cerca de US$ 0,02 por 1.000 tokens - mas pode subir rápido se mal usado.

Qual é a curva de aprendizado para cada tipo de NLP?

Para NLP estatístico: 2 a 4 semanas com bibliotecas como spaCy ou NLTK. Você aprende a criar regras e usar modelos prontos. Para LLMs: 3 a 6 meses. Você precisa entender prompt engineering, fine-tuning, limites de tokens, custos e como lidar com viés e alucinações. É um salto técnico muito maior.

O que é um modelo híbrido de NLP?

É um sistema que usa NLP estatístico para tarefas precisas (como extrair nomes de medicamentos de um texto) e LLMs para tarefas criativas (como explicar o diagnóstico em linguagem simples). O resultado é mais confiável, eficiente e explicável. É o caminho que empresas sérias já estão adotando - e que dominará o mercado até 2026.

Se você quer entender o que está por trás dos chatbots que usam todos os dias, ou se quer construir algo que realmente funcione - não basta saber que "IA é o futuro". É preciso saber quando usar uma regra simples, e quando deixar uma máquina pensar por você. O verdadeiro poder não está em escolher entre estatístico ou neural. Está em saber quando cada um deve falar.