Otimização de Modelos de IA: Como deixar sua IA mais rápida, barata e eficaz

Quando você fala de otimização de modelos de IA, o conjunto de técnicas usadas para fazer sistemas de inteligência artificial responderem mais rápido, com menos recursos e maior precisão. Também conhecido como eficiência de prompts, isso não é algo só para engenheiros de elite — é algo que qualquer pessoa que usa ChatGPT, Gemini ou outras ferramentas de IA precisa entender para não desperdiçar tempo e dinheiro. Muita gente acha que quanto mais texto você envia, melhor a resposta vai ser. Mas isso é um erro caro. Cada palavra que você digita vira um token, e cada token custa. Modelos como GPT-4 e Claude 3 não são infinitos: eles têm limites de processamento, e se você não otimizar, acaba pagando por palavras que não agregam nada.

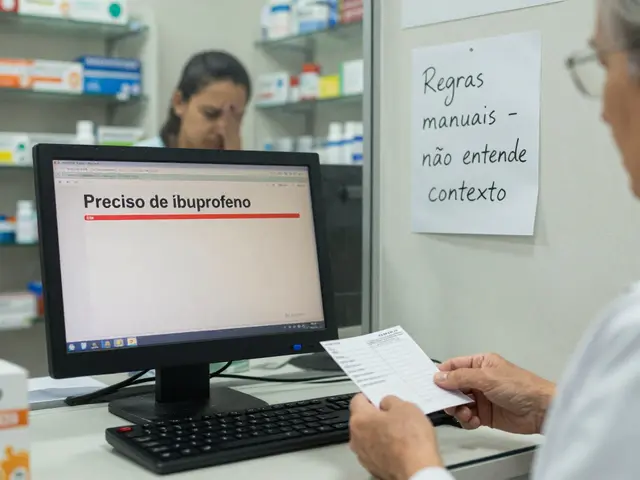

Isso leva direto a outro conceito essencial: prompt compression, a prática de reduzir o tamanho dos seus pedidos sem perder o significado. Também chamado de reduzir tokens, essa técnica é como fazer um resumo do seu pensamento antes de mandar para a IA. Em vez de escrever cinco frases para pedir um relatório, você aprende a usar uma só, bem estruturada. E isso não é só teoria — empresas de saúde já usam isso para gerar relatórios médicos em segundos, e desenvolvedores aplicam em código para economizar milhares de dólares por mês em custos de API. Outro ponto que você precisa saber: LLM, sigla para Large Language Model, ou modelo de linguagem de grande porte, como GPT, Gemini ou Claude, não são todos iguais. Alguns são mais pesados, outros mais rápidos. A otimização de modelos de IA não é só sobre o que você pede, mas também sobre qual modelo você escolhe para cada tarefa. Usar o GPT-4 para resumir um e-mail é como usar um caminhão para levar uma sacola de pão. O GPT-3.5 ou modelos menores fazem o mesmo trabalho, com metade do custo.

Se você está usando IA no dia a dia — seja para escrever, estudar, criar currículos ou até gerar imagens — entender essas bases muda tudo. Você deixa de ser alguém que só digita e espera milagres, e passa a ser quem controla a ferramenta. E isso não exige ser um especialista. É só sobre aprender o mínimo necessário para não se deixar levar por promessas vazias. No fim, a otimização de modelos de IA não é sobre fazer a IA ser mais inteligente. É sobre você ser mais esperto ao usá-la.

Na lista abaixo, você vai encontrar guias práticos que mostram exatamente como isso funciona na vida real: como reduzir tokens sem perder qualidade, como escolher o modelo certo, como evitar gastar dinheiro com prompts inúteis, e até como empresas já estão usando isso para automatizar tarefas que antes levavam horas. Tudo isso sem jargões, sem teoria abstrata — só o que funciona.