Em 2026, ninguém mais pode ignorar que a inteligência artificial generativa está mudando como criamos conteúdo, tomamos decisões e até interagimos com máquinas. Mas com essa mudança vem um novo problema: quem controla o que a IA pode ou não fazer? A resposta não está em um único país, mas em uma rede complexa de leis, padrões e regras que variam de continente para continente. Se você desenvolve, usa ou apenas confia em IA generativa - seja para criar imagens, escrever textos ou automatizar serviços - entender esses quadros regulatórios não é mais opcional. É essencial.

O que realmente está em jogo?

A IA generativa não é só um gadget. Ela pode gerar vídeos falsos que enganam eleições, criar arte que copia artistas sem permissão, ou reforçar preconceitos em processos de contratação. Em 2024, um estudo da UE mostrou que 62% dos deepfakes circulando online eram gerados por modelos não regulados. Isso não é ficção científica - é um risco real. Por isso, governos estão correndo para criar regras. Mas não todos da mesma forma.

O modelo europeu: riscos classificados, regras rígidas

A União Europeia foi a primeira a criar um sistema completo. O AI Act (Regulamento (UE) 2024/1689), em vigor desde agosto de 2024, divide a IA em quatro níveis de risco:

- Risco inaceitável: Proibido. Isso inclui sistemas que manipulam emoções humanas (como jogos que exploram crianças) ou uso massivo de reconhecimento facial por governos.

- Risco alto: Exige auditoria, documentação técnica e supervisão humana. Aplica-se a sistemas usados em justiça, emprego, educação, serviços públicos e polícia.

- Risco limitado: Exige transparência. Se você está interagindo com um chatbot que não é humano, precisa saber disso.

- Risco mínimo: Sem regras obrigatórias. Exemplos: jogos de IA ou filtros de foto.

Além disso, modelos de base (como o GPT-4 ou Llama 3) agora precisam passar por avaliações sistemáticas. A Comissão Europeia exige que eles atinjam no mínimo 85% de precisão factual em testes padrão e mantenham disparidades de viés abaixo de 15% entre grupos demográficos. E há um detalhe técnico crucial: todas as entradas e saídas de sistemas de risco alto devem ser registradas por 10 anos. Isso não é só burocracia - é rastreabilidade.

China: controle rígido e alinhamento ideológico

Enquanto a Europa foca em riscos, a China foca em controle. Seu Regulamento de Serviços de IA Generativa (agosto de 2023) obriga empresas a:

- Registrar algoritmos no governo antes de lançar qualquer serviço.

- Aplicar marcas criptográficas em todo conteúdo gerado - como um "selo digital" que prova que é IA, não humano.

- Garantir que os conteúdos gerados estejam alinhados com "valores fundamentais socialistas".

Isso não é só sobre segurança. É sobre censura algorítmica. Empresas que violam podem ser bloqueadas no mercado chinês. Mas há um paradoxo: muitos desenvolvedores chineses relatam que essas regras forçaram melhorias reais. Um fundador de startup em Xangai disse que o processo de registro expôs três viéses críticos que sua equipe havia ignorado. A conformidade, por mais rígida que pareça, aumentou a qualidade.

Estados Unidos: um caos federal

Aqui, não há lei federal unificada. Em vez disso, cada estado age por conta própria. A Califórnia, com sua SB 1047 (em vigor desde janeiro de 2025), é a mais ousada. Exige que desenvolvedores de modelos grandes (como GPT-5 ou Claude 3) façam testes de "red teaming" com pelo menos três organizações independentes. Se algo der errado, precisam relatar em 72 horas.

Outros estados seguem o NIST AI Risk Management Framework - um guia voluntário com 47 práticas e 127 subpráticas. Mas sem sanções, muitas empresas ignoram. Apenas 37% das empresas de IA nos EUA têm um oficial de conformidade dedicado. Enquanto isso, a agência federal NTIA lançou em outubro de 2025 um quadro voluntário que 41 estados prometeram adotar até o segundo trimestre de 2026. A confusão é real: uma empresa que opera em Nova York, Texas e Califórnia enfrenta três regras diferentes.

Reino Unido e Suíça: a via da inovação

O Reino Unido escolheu um caminho diferente: não criar novas leis. Em vez disso, criou um "AI and Digital Hub" para orientar empresas com conselhos, não multas. O objetivo? Manter a competitividade. A Suíça, por sua vez, está finalizando sua própria lei em 2025 - mas com foco em transparência e auditoria independente, não em proibições.

Essa abordagem "pro-inovação" atrai startups, mas também gera críticas. Muitos especialistas temem que sem regras claras, os riscos se acumulem. O que funciona para uma economia pequena e tecnologicamente avançada pode não funcionar para um mercado global.

Padrões globais: o que realmente une os países?

Apesar das diferenças, há um núcleo comum. As Princípios da OCDE para IA, adotados por 42 países até novembro de 2025, são o ponto de referência mais usado. Eles pedem:

- Transparência nos sistemas

- Justiça e não discriminação

- Segurança e segurança

- Responsabilidade

Mas apenas 17 desses países os transformaram em leis obrigatórias. O restante usa como guia. Ainda assim, há sinais de convergência. O Código de Prática da GPAI, desenvolvido pela UE e pela OCDE, já é usado como padrão principal por 63% das grandes empresas de IA globais, segundo a McKinsey. Isso significa que mesmo onde não há lei, as empresas estão se alinhando a um mesmo conjunto de regras - por pura sobrevivência comercial.

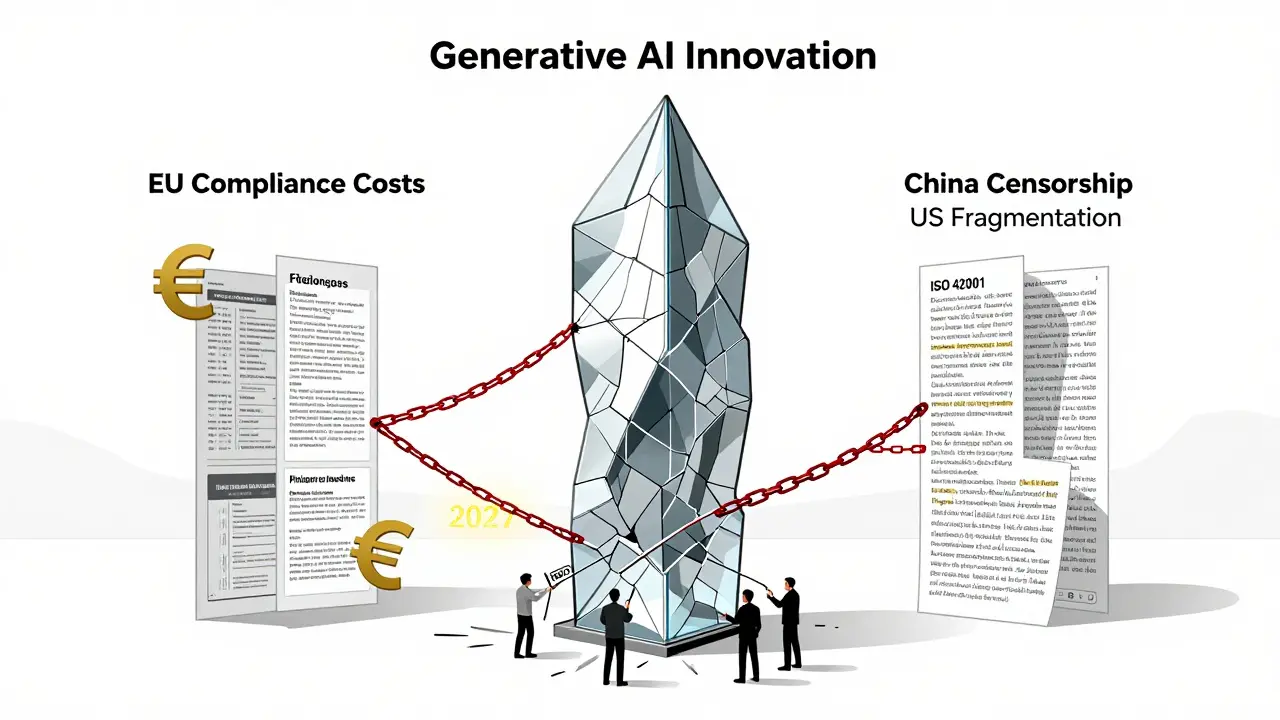

O custo da conformidade: quem paga?

Implementar essas regras não é barato. Um estudo da UE estima que desenvolvedores de IA de risco alto gastam em média €1,2 milhão por ano só em conformidade. Uma startup europeia relatou ter de contratar três novos especialistas e orçar €450 mil em auditorias externas - dinheiro que não estava no plano de 2024.

Pequenas empresas sofrem mais. Pesquisas mostram que 82% delas dedicam mais de 20% do tempo da equipe de engenharia à conformidade, contra apenas 37% das grandes empresas. Isso cria um desequilíbrio: startups menores são sufocadas, enquanto gigantes como Google ou Microsoft podem absorver os custos.

Além disso, o tempo de lançamento de produtos aumentou em média 5,7 meses por causa das regras. E há um conflito real: como mostrar transparência sem revelar segredos comerciais? 43% das empresas da UE dizem que isso é impossível. A solução? Documentação inteligente - não detalhes técnicos, mas provas de que os processos funcionam.

Como se preparar? O caminho prático

Se você está em uma empresa que usa IA generativa, aqui está o que fazer agora:

- Identifique onde sua IA atua: É usada em recrutamento? Em atendimento ao cliente? Em conteúdo público? Isso define o nível de risco.

- Use o NIST AI RMF: Mesmo que não seja obrigatório, é o melhor ponto de partida. Ele te ajuda a mapear riscos, medir impactos e gerenciar controles.

- Considere a ISO 42001: É a primeira norma internacional de gestão de IA. Certificar-se nela mostra credibilidade e facilita o acesso a mercados como a UE.

- Invista em treinamento: A Salesforce gastou US$8,2 milhões em 2025 para treinar 70.000 funcionários. Isso não é excesso - é prevenção.

- Monitore mudanças: A cada trimestre, revise as leis em seus mercados. Em 2027, 34 países exigirão relatórios de pegada de carbono de modelos treinados. Você quer estar preparado?

O futuro está aqui - e é mais próximo do que parece

Em 2027, 85% das economias avançadas terão leis de IA vinculativas. E o mercado de tecnologia de conformidade já atingiu US$14,7 bilhões em 2025. Isso não é uma tendência. É uma transformação estrutural.

As regras não vão desaparecer. Elas vão se tornar parte do DNA do desenvolvimento de IA. Quem entender primeiro - e agir com inteligência - vai ganhar confiança, mercado e sustentabilidade. Quem esperar, vai enfrentar multas, bloqueios e perda de reputação.

Não se trata de escolher entre inovação e controle. Trata-se de construir inovação que dure - e que não prejudique quem confia nela.

Quais são as principais leis de IA em vigor em 2026?

As principais leis em vigor em 2026 são: o AI Act da União Europeia (em vigor desde agosto de 2024), o Regulamento de Serviços de IA Generativa da China (agosto de 2023), a SB 1047 da Califórnia (janeiro de 2025), e a Lei de IA da Coreia do Sul. A Suíça e o Japão estão finalizando seus quadros em 2025-2026. A maioria dos países ainda segue diretrizes voluntárias baseadas nos princípios da OCDE.

A IA generativa precisa ser registrada em todos os países?

Não. Apenas em países com legislação prescritiva, como China e UE (para modelos de base). Na UE, os modelos de IA generativa de uso geral (GPAI) precisam ser registrados e avaliados. Na China, todos os serviços de IA generativa devem ser registrados antes do lançamento. Nos EUA, não há registro federal - apenas exigências de teste e relato em alguns estados.

O que é "transparência algorítmica" e por que importa?

Transparência algorítmica significa dar aos usuários informações claras sobre como a IA funciona - sem revelar segredos comerciais. Por exemplo: "Este conteúdo foi gerado por IA" ou "Este sistema foi treinado com dados de 2020 a 2023". É obrigatório na UE para IA de risco limitado e alto. Na China, exige-se que o funcionamento básico seja compreensível ao usuário. A ideia é evitar engano e construir confiança.

Como as empresas pequenas podem sobreviver a essas regras?

Usando ferramentas de conformidade escaláveis. Plataformas como Trustible AI ajudam a automatizar documentação e auditorias. Também é crucial buscar certificação ISO 42001 - ela é reconhecida internacionalmente e reduz a necessidade de múltiplas auditorias. Muitos países oferecem "sandbox" regulatórios, onde startups testam produtos com regras temporárias mais leves. A Europa e o Reino Unido já têm esses programas.

Existe uma lei global da IA?

Não há uma única lei global. Mas há uma convergência crescente. O Código de Prática da GPAI, apoiado pela UE e OCDE, é usado por 63% das grandes empresas como padrão global. Isso significa que, mesmo sem lei, muitas organizações estão adotando regras comuns. A tendência é que, nos próximos anos, os países alinhem suas leis a esses padrões - especialmente em segurança, viés e transparência.

O que acontece se eu não me conformar?

As consequências variam. Na UE, multas podem chegar a 7% do faturamento global ou €35 milhões, o que for maior. Na China, serviços podem ser bloqueados e empresas podem perder licenças. Nos EUA, multas são menores, mas a perda de reputação e processos judiciais podem ser devastadores. Em todos os casos, a exposição pública e a perda de confiança do consumidor são os maiores riscos.