Quando você digita um prompt na IA e recebe uma resposta perfeita em segundos, é fácil achar que está no controle. Mas o que você não vê é o que realmente está em jogo. O maior risco de usar IA hoje não é ela ficar inteligente demais. É ela repetir seus vieses - e você nem perceber.

Seu prompt não é neutro - e a IA não é inocente

Você acha que só pede para a IA escrever um e-mail profissional? Talvez. Mas a IA pega cada palavra, cada escolha de tom, cada exemplo que você dá, e usa isso para moldar o que ela acredita ser "correto". Se você sempre pede para ela fazer um currículo de homem com 10 anos de experiência, ela vai achar que engenheiros são, por padrão, homens. Se você pede para ela escrever um texto sobre enfermeiras usando palavras como "cuidadosa" ou "dedicada", ela vai associar esse cargo a traços femininos - mesmo que isso não seja verdade.Isso não é erro. É aprendizado. A IA foi treinada com bilhões de textos da internet - e a internet é cheia de estereótipos, preconceitos e desigualdades. Quando você usa IA, você não está pedindo uma máquina neutra. Você está pedindo a um espelho que reflete o pior e o melhor da humanidade. E se você não cuidar do que coloca nesse espelho, ele vai te devolver uma versão distorcida da realidade.

Quem paga o preço? Você, mas não da forma que espera

Pense em um recrutador que usa IA para filtrar currículos. Ele pede: "Encontre os candidatos mais qualificados para a vaga de gerente de projetos". A IA, treinada com dados históricos, escolhe 90% homens. Por quê? Porque nos últimos 20 anos, 90% dos gerentes foram homens. A IA não está sendo preconceituosa - ela está sendo lógica. Mas a lógica dela é baseada em um passado injusto. E agora, ela está bloqueando mulheres qualificadas - só porque o sistema anterior falhou.Isso não acontece só em recrutamento. Acontece em empréstimos bancários, diagnósticos médicos, até na forma como o sistema de justiça avalia risco de reincidência. Em Porto Alegre, um estudo da UFRGS mostrou que algoritmos usados em programas sociais tinham 30% mais chances de negar auxílio a famílias de bairros periféricos - não por causa da renda, mas por causa do nome da rua, do padrão de escrita nos formulários e até da frequência de palavras como "crise" ou "dificuldade" nos textos que a IA havia lido antes.

Seu prompt é um contrato invisível

Você acha que só está pedindo um texto? Na verdade, você está treinando a IA - mesmo que não queira. Cada vez que você aceita uma resposta sem questionar, você está dizendo: "Isso está certo". E a IA aprende isso. Ela não tem consciência, mas tem memória. E ela guarda tudo.Se você sempre pede para a IA criar imagens de CEOs com terno e gravata, e ela sempre mostra homens brancos, você está reforçando um padrão. Se você pede para ela corrigir o português de alguém que fala com sotaque nordestino e ela "corrigir" para um português "padrão" que soa como de São Paulo, você está dizendo que um sotaque é errado. Isso não é linguagem. É exclusão.

As empresas que vendem IA dizem que "os usuários são responsáveis". Mas ninguém te ensinou como usar esse espelho. Ninguém te disse que seu "bom prompt" pode estar alimentando um ciclo de discriminação. E você, sem querer, está virando parte do problema.

O que você pode fazer - e o que não pode

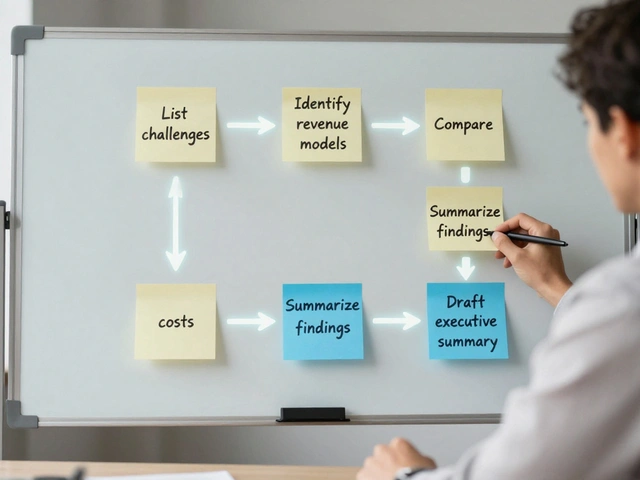

Não adianta só dizer "não quero viés". Você precisa agir. Aqui estão três coisas que funcionam:- Varie os exemplos. Em vez de pedir "um médico de 40 anos", peça "um médico de 40 anos, mulher, negra, moradora de periferia". Forçe a IA a ver além do estereótipo.

- Pergunte "por quê?" Se a IA responder algo estranho, peça a explicação. Ela vai te mostrar os padrões que usou. Muitas vezes, você vai ver que ela usou dados antigos, desatualizados ou tendenciosos.

- Use IA que permite auditoria. Algumas ferramentas, como o Llama 3 e o Mistral, permitem que você veja quais dados foram usados para gerar a resposta. Não use ferramentas que escondem isso.

Isso não é só ética. É eficiência. Uma IA que vê o mundo de forma mais ampla faz melhores previsões, cria soluções mais criativas e atende mais pessoas. A IA que só repete o que já existe é uma IA que não evolui.

Por que isso é pior do que "IA tomar o controle"?

Filmes mostram IA dominando o mundo, matando pessoas, tomando decisões. Mas isso é ficção. O que está acontecendo agora é muito mais silencioso - e mais perigoso.Quando uma IA toma decisões erradas por viés, ninguém a culpa. Ela não tem intenção. Você acha que a pessoa que foi negada no empréstimo vai processar uma máquina? Não. Ela acha que foi rejeitada por ser "menos qualificada". E aí, o preconceito vira verdade. A IA não inventou o racismo. Ela só o tornou automático. E quando algo é automático, ninguém se sente responsável.

Isso é o que torna o viés algorítmico o maior risco: ele não é um erro. É um sistema. E ele está sendo alimentado por você - todos os dias - sem que você saiba.

Se você só usa IA para tarefas fáceis, está em risco

Muita gente pensa: "Eu só uso para resumir e-mails ou gerar ideias de post no Instagram. Não tem problema." Mas o problema não está no que você faz. Está no que você deixa de questionar.Se você aceita que a IA escreve "mulheres são boas em cuidar" sem pensar duas vezes, você está normalizando isso. Se você não corrige quando ela usa "ele" como padrão para médicos, você está ensinando a IA - e a si mesmo - que certos papéis são masculinos.

IA não é uma ferramenta neutra. É um reflexo. E se você não olha com cuidado para o que ela devolve, você vai acabar acreditando no reflexo - e esquecendo a realidade.

Qual é o maior risco de usar IA em prompts?

O maior risco é a IA reproduzir e amplificar vieses humanos - como racismo, sexismo e desigualdade social - sem que você perceba. Isso acontece porque ela aprende com dados do passado, que já são tendenciosos. Quando você usa prompts sem questionar os resultados, você está treinando a IA a achar que esses vieses são normais.

Como saber se minha IA está sendo preconceituosa?

Faça testes simples: peça para a IA gerar perfis de profissionais com diferentes gêneros, etnias e regiões. Compare os resultados. Se ela sempre mostra homens brancos como CEOs ou mulheres como enfermeiras, há viés. Também peça para ela explicar por que escolheu certas palavras. Se a resposta for vaga ou baseada em estereótipos, ela está reproduzindo preconceitos.

Posso confiar na IA para escrever textos importantes, como currículos ou e-mails profissionais?

Pode, mas nunca sem revisão. A IA é rápida, mas não é justa. Ela pode omitir candidatos qualificados por causa de seu nome, sotaque ou endereço. Sempre revise os textos gerados. Pergunte: "Isso representa todos?" e "Será que alguém poderia se sentir excluído com isso?"

Existe alguma IA que não tem viés?

Não. Todas as IA grandes são treinadas com dados da internet, e a internet reflete os preconceitos da sociedade. O que existe são ferramentas que permitem auditoria - como Llama 3 e Mistral - que mostram quais dados foram usados. Isso não elimina o viés, mas te dá poder para identificá-lo e corrigi-lo.

O que acontece se eu não corrigir os vieses da IA?

O viés se torna normal. Ele se espalha por contratos, decisões de recrutamento, serviços públicos e até leis. A IA não inventa o preconceito, mas ele se torna mais difícil de ver - porque parece automático, técnico, "científico". E quando algo parece neutro, ninguém questiona. E aí, a desigualdade se consolida.

2 Comentários

IA é só um espelho do lixo que a gente coloca nela, e ninguém quer olhar no espelho.

Mano, eu uso IA pra resumir relatório de vendas e ainda assim ela me devolveu um texto só com homens brancos como 'gerentes ideais'. Aí eu fui ver o histórico dos meus prompts... merda, eu sempre usei 'executivo masculino' como exemplo. Tô me sentindo um porco.