Se você já usou um chatbot que parece entender exatamente o que você quis dizer - mesmo que sua pergunta não seja perfeita -, provavelmente está interagindo com algo que usa BERT é um modelo de linguagem desenvolvido pelo Google em 2018 que revolucionou a forma como sistemas de inteligência artificial compreendem texto. Também conhecido como Bidirectional Encoder Representations from Transformers, ele não é só mais um algoritmo: é o que faz o Google entender perguntas como "Como conserto uma torneira que vaza?" e responder com dicas reais, não com resultados genéricos.

Como o BERT mudou tudo na compreensão de linguagem

Antes do BERT, os sistemas de IA tratavam palavras como peças soltas. Se você escrevesse "eu fui ao banco" e outra pessoa dissesse "o banco do rio", o sistema pensava que eram coisas diferentes só porque a palavra "banco" aparecia em contextos distintos. Ele não entendia a relação entre as palavras ao redor.

BER T mudou isso. Ele lê uma frase de ambos os lados ao mesmo tempo. Isso significa que, ao ver a palavra "banco" em "o banco do rio", ele olha para as palavras antes e depois: "o" e "do rio". Isso permite que ele saiba que aqui "banco" é a margem de um rio, não uma instituição financeira. Esse processo se chama bidirecionalidade - e é o que torna o BERT tão poderoso.

Antes do BERT, modelos como Word2Vec ou GloVe só olhavam para uma direção. Eles eram bons em identificar palavras similares, mas não em entender nuance. O BERT, por outro lado, aprendeu com mais de 3.3 bilhões de palavras do texto da web. Ele viu como as pessoas realmente escrevem - com erros, abreviações, gírias e frases incompletas. E aprendeu a lidar com tudo isso.

Por que o BERT é tão importante para prompts de IA?

Quando você digita um prompt como "explique como funciona o clima", o sistema por trás da sua IA precisa saber se você quer uma explicação simples, científica, ou até para crianças. O BERT ajuda a IA a entender o que você realmente quer - não apenas as palavras que você usou.

Por exemplo, se você escrever: "O que é um buraco negro e como ele afeta o tempo?", o BERT não apenas identifica as palavras-chave. Ele entende que "afetar o tempo" aqui provavelmente se refere à dilatação temporal da relatividade, não ao clima. Isso acontece porque o modelo já viu milhões de frases parecidas em artigos científicos, vídeos e fóruns.

Isso é crucial para prompts eficazes. Se você escreve um prompt vago, o BERT ajuda a IA a preencher as lacunas. Ele não pede para você reformular. Ele entende. E isso faz toda a diferença quando você quer respostas precisas, sem ter que ser um expert em redação.

Como o BERT funciona por dentro

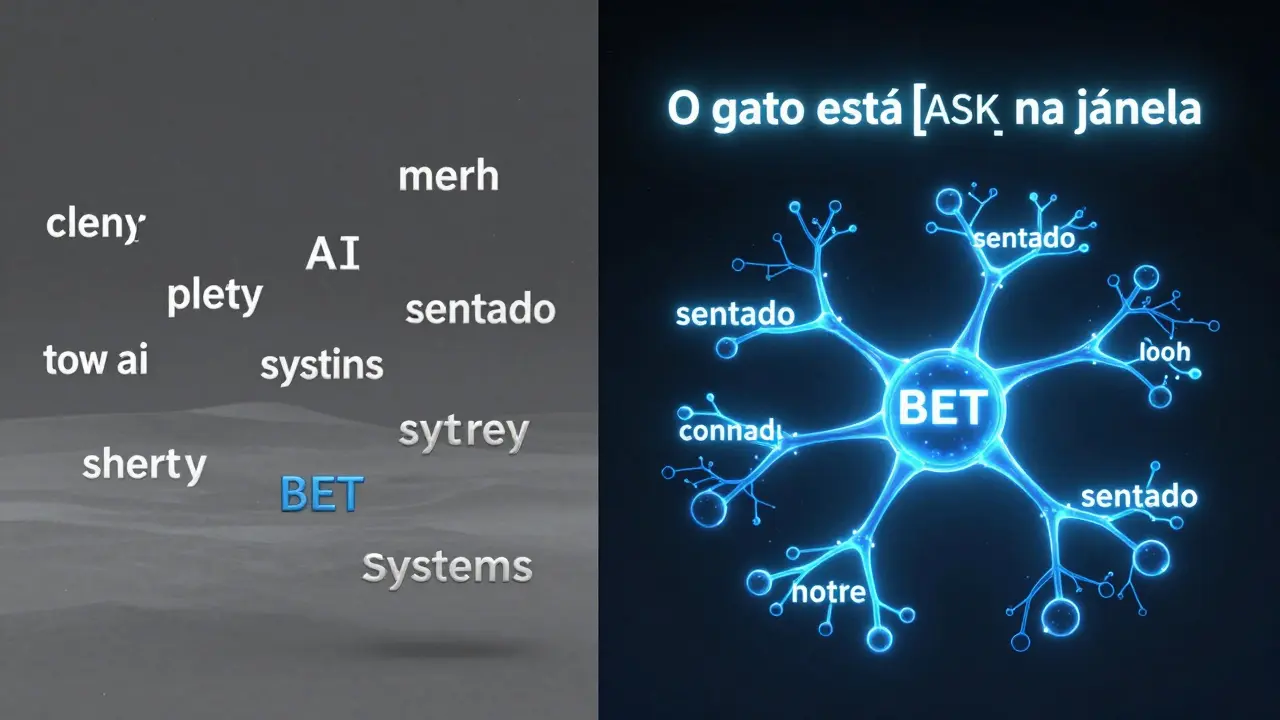

O BERT é baseado em uma arquitetura chamada Transformer, criada pelo Google em 2017. Mas enquanto os Transformers anteriores processavam palavras em sequência, o BERT usou uma técnica chamada masking - ou mascaramento.

Na hora de treinar, o modelo pegava frases como:

- "O gato está [MASK] na janela."

- "Eu comprei um [MASK] para o aniversário."

E perguntava: "Qual palavra falta?". Ele não olhava só para a esquerda ou direita. Ele olhava para tudo ao mesmo tempo. Ao longo de milhões de tentativas, ele aprendeu que "[MASK]" em "o gato está [MASK] na janela" quase sempre é "sentado". E em "eu comprei um [MASK] para o aniversário", é quase sempre "presente".

Essa técnica fez o BERT aprender contextos profundos. Ele não memoriza respostas. Ele aprende padrões. E isso o torna flexível - capaz de entender perguntas novas, mesmo que nunca tenha visto exatamente aquela frase antes.

BERT vs. outros modelos de linguagem

É comum confundir BERT com outros modelos como GPT ou Llama. Mas eles funcionam de forma diferente.

| Modelo | Como lê o texto | Principal uso | Força |

|---|---|---|---|

| BER T | Bidirecional (esquerda e direita) | Compreensão de texto | Entender perguntas, classificar sentimentos, buscar informações |

| GPT | Unidirecional (só da esquerda para direita) | Gerar texto | Criar respostas, histórias, códigos |

| Word2Vec | Palavras isoladas | Relações de palavras | Identificar sinônimos, categorias básicas |

O BERT não é bom para criar textos longos. Ele não gera histórias como o GPT. Mas ele é excelente em responder perguntas como: "Essa avaliação é positiva ou negativa?" ou "Qual é o assunto principal deste texto?". É por isso que ele está por trás da busca do Google, da análise de comentários em produtos e até de sistemas de atendimento ao cliente.

Onde você encontra o BERT no dia a dia

Provavelmente você já interagiu com o BERT sem saber. Aqui estão alguns exemplos reais:

- Quando você pesquisa "qual a diferença entre café e chá" e o Google mostra um resumo direto na parte de cima da página - isso é BERT entendendo sua intenção.

- Quando o YouTube sugere vídeos com base em comentários que você leu - BERT analisa o tom e o conteúdo.

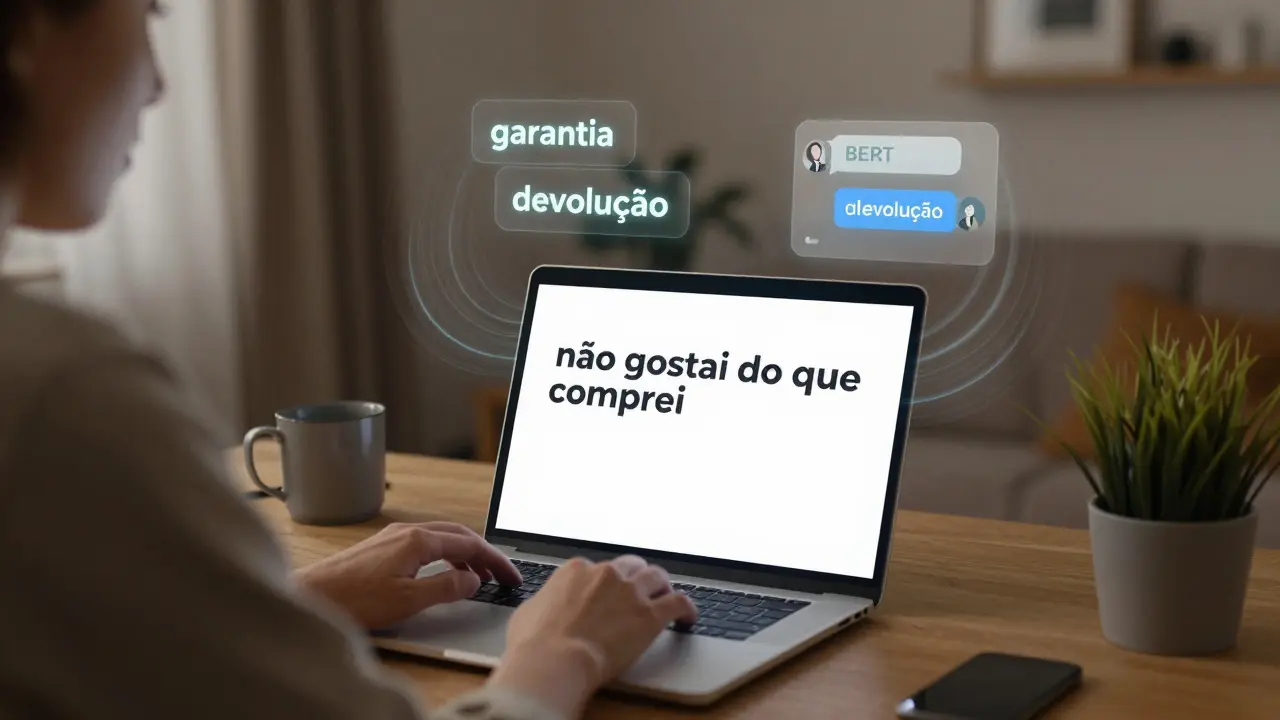

- Quando um chatbot de uma loja online responde "você quer saber sobre garantia ou devolução?" depois de você dizer só "não gostei do que comprei" - isso é BERT interpretando emoção e contexto.

Na prática, o BERT é o que faz com que a IA pareça mais humana. Ele não responde como um robô que memorizou respostas. Ele responde como alguém que realmente entendeu o que você disse.

Limitações do BERT

Não é perfeito. O BERT ainda tem falhas.

- Ele não entende bem sarcasmo. Se você escrever "ah, claro, mais um dia de trabalho...", ele pode achar que é positivo.

- Ele não tem memória de conversa. Cada frase é analisada isoladamente - não lembra o que você disse 5 frases atrás.

- É pesado. Exige muita potência de computação. Por isso, muitos apps usam versões menores, como DistilBERT, que são mais rápidas, mas menos precisas.

Apesar disso, ele continua sendo a base de muitos sistemas modernos. E mesmo as versões mais leves ainda superam modelos antigos em quase todos os testes de compreensão.

O futuro do BERT

Em 2026, o BERT original já não é mais o mais usado - mas suas ideias estão em tudo. Modelos como BERT-wwm, RoBERTa, e até o próprio GPT-4 usam princípios que ele introduziu. A ideia de entender o contexto por ambos os lados virou padrão.

Hoje, empresas como Microsoft, Amazon e até startups em Lisboa usam versões do BERT para melhorar buscas, atendimento ao cliente e análise de documentos legais. Ele não é só um modelo antigo. É o alicerce da nova geração de IA que entende linguagem.

Se você quer usar IA de forma mais eficaz - especialmente em prompts - entender o BERT é como entender o alfabeto. Não precisa saber como ele foi feito. Mas precisa saber que ele está lá, trabalhando atrás das cenas, transformando suas frases confusas em respostas claras.

O BERT é o mesmo que o GPT?

Não. O BERT foi feito para entender texto, enquanto o GPT foi feito para gerar texto. O BERT lê de ambos os lados para descobrir o significado. O GPT lê de esquerda para direita e tenta adivinhar a próxima palavra. Eles são complementares, não iguais.

Por que o BERT é tão importante para buscas do Google?

Antes do BERT, o Google respondia a buscas com base em palavras-chave. Agora, ele entende o que você quer dizer. Por exemplo, se você busca "como fazer bolo sem ovo", o Google entende que você quer uma receita alternativa, não apenas páginas que mencionam "bolo" e "ovo". Isso aumenta a precisão das respostas em até 40%.

O BERT ainda é usado em 2026?

Sim, mas raramente na versão original. A maioria dos sistemas usa versões mais leves, como DistilBERT ou RoBERTa, que são mais rápidas e eficientes. Mas todas essas versões herdam o princípio central do BERT: entender o contexto por ambos os lados da palavra. Ele é o pai de todos os modelos modernos de compreensão de linguagem.

Posso usar o BERT para criar meus próprios prompts?

Você não precisa usar o BERT diretamente. Mas entender como ele funciona ajuda a escrever prompts melhores. Se você sabe que o modelo olha para o contexto completo, evite frases ambíguas. Use palavras que deixem claro o que você quer. Por exemplo, em vez de "explique isso", diga "explique como o BERT entende palavras em uma frase". Isso dá ao sistema muito mais informação para trabalhar.

O BERT funciona em português?

Sim. O Google treinou versões do BERT em múltiplos idiomas, incluindo português. Ele entende expressões como "fazer um bolo" ou "chegar atrasado" com boa precisão. Modelos em português como BERTimbau foram criados especialmente para o português brasileiro e europeu, e são usados em universidades e empresas em Portugal e Brasil.