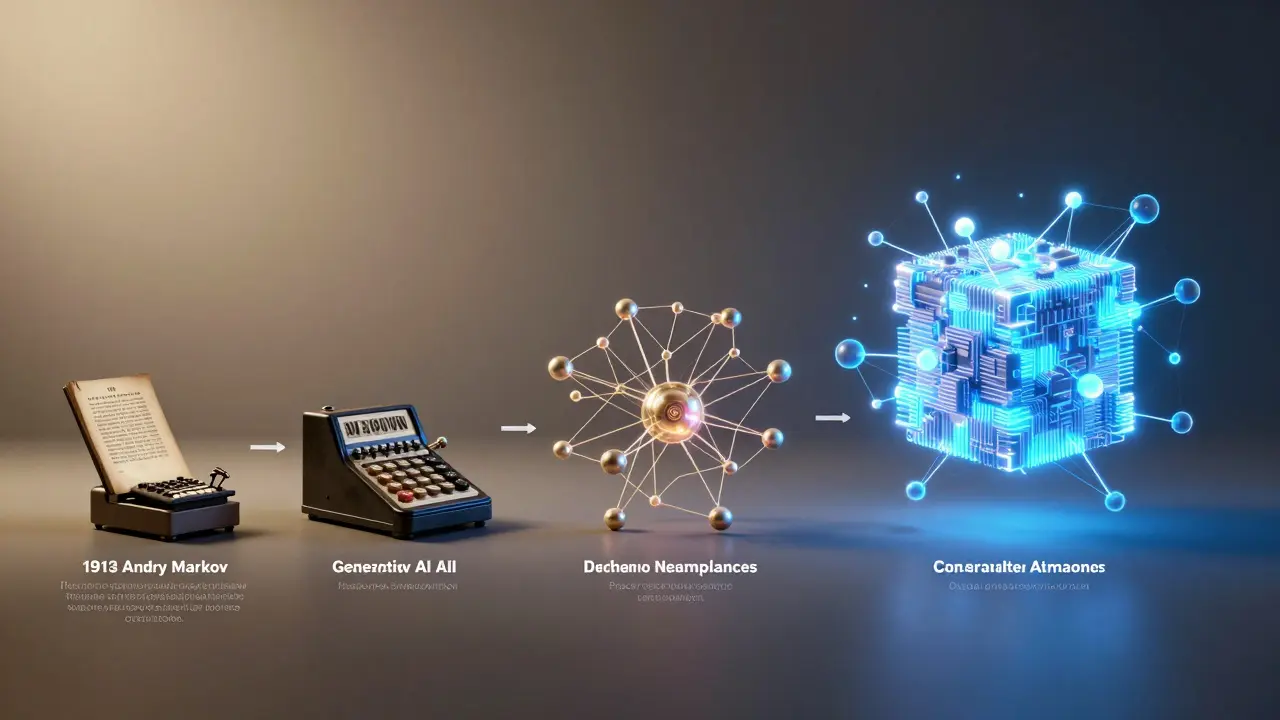

Se você já usou uma ferramenta de IA que escreve textos, gera imagens ou até responde perguntas como se fosse uma pessoa, você está interagindo com o resultado de décadas de pesquisa técnica. A IA generativa não surgiu do nada. Ela foi construída passo a passo, com ideias que começaram com matemática pura e evoluíram até virar a força que move hoje os chatbots, os geradores de imagem e os assistentes inteligentes. A jornada vai desde os primeiros modelos probabilísticos do início do século XX até os transformers que dominam o cenário em 2026. E não foi um caminho linear - houve períodos de entusiasmo, esquecimento, e revoluções repentinas.

As raízes matemáticas: Markov e a ideia de prever o próximo passo

Tudo começou com um matemático russo, Andrey Markov, que em 1913 analisou uma sequência de letras em um poema. Ele queria saber se a próxima letra poderia ser prevista apenas pela letra anterior. A resposta foi sim. Isso deu origem aos Modelos de Markov são sistemas probabilísticos que preveem o próximo elemento em uma sequência com base apenas no estado atual, sem memória de eventos anteriores. Essa ideia simples, mas poderosa, virou a base de todos os modelos de geração de sequência por décadas.

Em 1950, Alan Turing publicou seu artigo "Computing Machinery and Intelligence", onde propôs um teste simples: se uma máquina pudesse conversar de forma indistinguível de um humano, ela seria considerada inteligente. Não importava como ela funcionava por dentro - só importava o que ela produzia. Essa visão pragmática, focada na saída e não no mecanismo, moldou toda a pesquisa em IA generativa desde então. Foi o primeiro passo para pensar em máquinas como criadoras de conteúdo, não apenas calculadoras.

Os primeiros passos da IA: ELIZA e o efeito que ninguém esperava

Em 1964, Joseph Weizenbaum, do MIT, criou ELIZA o primeiro chatbot da história, que simulava uma terapeuta psicanalítica usando correspondência de padrões e substituição de palavras. ELIZA não entendia nada. Ela apenas trocava palavras como "eu sinto" por "você sente" e jogava de volta as perguntas do usuário. Mas os humanos? Eles começaram a acreditar que a máquina os entendia. Esse fenômeno virou o Efeito ELIZA a tendência humana de atribuir intenção, emoção e consciência a sistemas simples que imitam conversação.

Apesar do impacto psicológico, ELIZA não era inteligente. Era um espelho. E isso explica por que a IA passou por uma longa "inverno". Nos anos 70 e 80, os cientistas prometeram máquinas que pensavam, mas só entregaram sistemas que repetiam. O financiamento secou. A ideia de IA generativa quase desapareceu.

Redes neurais e o retorno da esperança: perceptron, RNNs e LSTMs

Em 1958, Frank Rosenblatt criou o perceptron a primeira rede neural artificial capaz de aprender com dados, com pesos ajustáveis e função de ativação. Era o primeiro passo real para um sistema que não seguia regras fixas, mas aprendia com exemplos. Mas os computadores da época não tinham poder suficiente. O perceptron foi esquecido por anos.

Em 1982, os Redes Neurais Recorrentes (RNNs) arquiteturas que processam sequências mantendo um estado interno, permitindo que o passado influencie o futuro foram introduzidas. Elas eram a primeira tentativa real de criar máquinas que "lembrassem" o que aconteceu antes. Mas tinham um problema grave: esqueciam rápido. Se você quisesse prever a próxima palavra em um texto longo, a RNN não conseguia lembrar o início da frase.

Em 1997, Jürgen Schmidhuber e seu time criaram o LSTM (Long Short-Term Memory) uma variante de RNN com portas de memória que permitem reter informações por longos períodos, superando o problema do esquecimento. Isso foi um divisor de águas. O LSTM conseguiu aprender padrões complexos, como gramática de linguagens formais, algo que modelos anteriores não conseguiam. Em 2007, eles usaram o LSTM para criar o primeiro sistema de reconhecimento de fala que superou métodos tradicionais. Ainda hoje, esse sistema é a base de muitos assistentes de voz.

GANs, VAEs e a era da geração criativa

Enquanto os modelos de texto evoluíam, outro ramo da IA generativa estava se desenvolvendo: a geração de imagens. Em 2013, Diederik Kingma e Max Welling introduziram os VAEs (Variational Autoencoders) modelos probabilísticos que aprendem a codificar dados em uma representação compacta e depois reconstruí-los, gerando novas variações. Eles eram elegantes, mas as imagens geradas eram borradas, como se fossem sonhos confusos.

Em 2014, Ian Goodfellow apresentou os GANs (Generative Adversarial Networks) arquiteturas compostas por duas redes que competem: uma gera imagens, outra tenta identificar se são falsas; o resultado é uma geração cada vez mais realista. Era como um artista e um crítico trabalhando juntos. O artista tentava enganar o crítico, e o crítico ficava mais esperto. Com o tempo, o artista virou um mestre. GANs geraram rostos falsos, pinturas em estilo de Van Gogh, e até roupas de moda. Mas tinham um problema: eram instáveis. Treinar um GAN era como equilibrar uma bicicleta em uma corda.

O salto definitivo: o transformer e o fim da recorrência

Em 2017, um grupo de pesquisadores do Google publicou um artigo com um título simples: "Attention is All You Need". Eles propuseram algo radical: eliminar completamente as redes recorrentes. Em vez disso, usariam self-attention um mecanismo que permite que cada elemento de uma sequência se relacione com todos os outros ao mesmo tempo, permitindo paralelismo total no treinamento.

Isso foi um choque. Por décadas, os modelos de sequência tinham que processar os dados um por um, como ler uma frase da esquerda para a direita. O transformer lia a frase inteira de uma vez. Não importava se a frase tinha 10 ou 1000 palavras - o computador podia analisar tudo ao mesmo tempo. Isso fez o treinamento ficar mil vezes mais rápido.

Em 2018, a OpenAI lançou o GPT-1 o primeiro modelo generativo baseado em transformer, treinado em bilhões de páginas da web para prever a próxima palavra. Ele não era perfeito, mas mostrou o potencial. O GPT-2, em 2019, já escrevia parágrafos convincentes. O GPT-3, em 2020, com 175 bilhões de parâmetros, parecia entender o mundo. Ele podia escrever poemas, explicar física quântica, e até codificar em Python - tudo com poucos exemplos.

Transformers dominam: de textos a imagens e o custo da revolução

O transformer não parou no texto. Em 2021, o DALL-E usou transformers para gerar imagens a partir de descrições em linguagem natural. Em 2022, o Stable Diffusion combinou transformers com diffusion models modelos que geram imagens invertendo um processo de adição de ruído, começando do caos e refinando até a forma final. Eles produziam fotos que pareciam reais - com detalhes de luz, sombra, textura. O Midjourney e o DALL-E 2 vieram logo depois.

Mas essa revolução tem um preço. Treinar o GPT-3 consumiu cerca de 1.300 megawatts-hora de energia - o equivalente ao consumo anual de 120 lares brasileiros. Os modelos precisam de GPUs caras, com 40GB ou mais de memória. E mesmo assim, eles ainda "alucinam". Dão respostas certas, mas inventam fatos. Eles não entendem a realidade - apenas padrões estatísticos.

Em 2023, o GPT-4 chegou com capacidade de processar até 25.000 palavras de entrada. Ele conseguia entender documentos inteiros, fazer cálculos complexos e até analisar imagens. Mas o que mais impressionou foi a capacidade de raciocínio - algo que os LSTMs nunca tiveram.

O que vem depois? Mambas, RAG e o futuro da IA

Hoje, em 2026, o transformer ainda domina. Mas os cientistas já estão buscando alternativas. Em dezembro de 2023, o DeepMind apresentou o Mamba uma arquitetura baseada em modelos de espaço de estado que mantém a eficiência dos transformers com complexidade linear em vez de quadrática. Ele promete ser tão poderoso quanto um transformer, mas com 10 vezes menos memória.

Empresas estão usando RAG (Retrieval-Augmented Generation) técnica que combina geração de texto com busca em bases de dados reais para reduzir alucinações e aumentar precisão. Em vez de confiar só no conhecimento interno do modelo, ele consulta documentos confiáveis antes de responder. Isso já é usado por 67% das empresas que implementam IA generativa.

Alguns pesquisadores, como Geoffrey Hinton, acreditam que os transformers são um beco sem saída. Eles não construem "modelos do mundo" - não entendem causa e efeito, só correlação. Talvez a próxima revolução venha de modelos que aprendem com o ambiente, como crianças. Ou talvez a IA generativa evolua sem precisar de uma nova arquitetura - só com mais dados, mais computação e mais atenção à ética.

Por que isso importa?

A história da IA generativa não é só sobre algoritmos. É sobre como a humanidade aprendeu a criar coisas com máquinas. De um modelo que previa letras em um poema, até uma IA que escreve um romance ou desenha um logotipo em segundos. Cada passo foi feito por pessoas que não desistiram quando o mundo dizia que era impossível.

Agora, qualquer um pode usar essas ferramentas. Mas entender como elas funcionam - de Markov aos transformers - é o que separa quem apenas usa de quem realmente domina. Porque quando você entende o que está por trás, você não é só um usuário. Você se torna um diretor da próxima revolução.

O que é um modelo de Markov e como ele se relaciona com a IA generativa?

Um modelo de Markov é um sistema probabilístico que prevê o próximo elemento em uma sequência com base apenas no elemento atual, ignorando o histórico anterior. Foi criado por Andrey Markov em 1913 e é a base matemática mais antiga da IA generativa. Modelos como Hidden Markov Models (HMMs) foram usados nos anos 1950 para gerar fala e texto. Embora simples, eles introduziram a ideia central de que a geração de conteúdo pode ser feita por probabilidades - algo que todos os modelos modernos, incluindo transformers, ainda usam, só que de forma muito mais complexa.

Por que os transformers substituíram as RNNs e LSTMs?

RNNs e LSTMs processavam sequências uma palavra por vez, o que era lento e difícil de paralelizar. Transformers usam self-attention, que permite analisar todas as palavras ao mesmo tempo. Isso fez o treinamento ficar muito mais rápido - em vez de semanas, passou a levar horas. Além disso, transformers conseguem lidar com contextos muito mais longos. Enquanto um LSTM raramente ultrapassava 100 milhões de parâmetros, transformers como o GPT-3 chegaram a 175 bilhões, com desempenho muito superior em tarefas complexas.

Qual é a principal limitação dos transformers hoje?

A principal limitação é a complexidade quadrática da atenção: para uma sequência de N palavras, o modelo precisa calcular N² relações. Isso exige muita memória e energia. Treinar o GPT-3 consumiu energia equivalente a 120 lares por ano. Além disso, transformers não entendem causalidade - eles apenas reconhecem padrões. Isso faz com que eles "alucinem" - inventem fatos plausíveis, mas falsos - e não consigam raciocinar como humanos em tarefas matemáticas ou lógicas profundas.

O que são GANs e VAEs, e por que eles não dominaram como os transformers?

GANs (Generative Adversarial Networks) e VAEs (Variational Autoencoders) são modelos para gerar imagens e dados não sequenciais. GANs usam duas redes em competição - uma gera, outra julga. VAEs codificam dados em uma representação compacta e depois geram novas variações. Eles foram revolucionários para imagens, mas não funcionam bem com texto. Transformers, por outro lado, são universais: funcionam com texto, áudio, vídeo e até código. A versatilidade e a escalabilidade dos transformers os tornaram a escolha dominante, mesmo que GANs ainda sejam usados em aplicações específicas de arte.

Como o RAG ajuda a resolver os problemas dos modelos de IA generativa?

O RAG (Retrieval-Augmented Generation) combina a geração de texto de um modelo de IA com a busca em bases de dados confiáveis, como documentos, artigos ou bancos de conhecimento. Em vez de depender só do que o modelo "aprendeu" durante o treinamento (que pode estar desatualizado ou incorreto), ele consulta fontes reais antes de responder. Isso reduz drasticamente as alucinações e aumenta a precisão. Já é adotado por 67% das empresas que usam IA generativa em produção, especialmente em atendimento ao cliente, jurídico e médico.

O que é o Mamba e por que ele é importante?

O Mamba é uma nova arquitetura de IA desenvolvida pelo DeepMind em 2023. Ele usa modelos de espaço de estado, em vez de self-attention, para processar sequências. A grande vantagem é que sua complexidade é linear - ou seja, cresce proporcionalmente ao tamanho da entrada, não quadráticamente. Isso significa que ele pode processar textos muito longos com muito menos memória e energia. Se for bem-sucedido, o Mamba pode substituir transformers em aplicações onde custo e eficiência são críticos, como em dispositivos móveis ou sistemas embarcados.

Se você quer entender o que está por trás dos chatbots que você usa todos os dias, essa é a história. Não é magia. É matemática, paciência e décadas de tentativa e erro. E ainda estamos no começo.