Simulador de Risco de Privacidade para Geradores de Imagens IA

Este simulador ajuda a avaliar o risco de privacidade ao usar geradores de imagens com IA. Responda às perguntas abaixo para descobrir seu nível de risco e obter recomendações personalizadas.

Configurações do seu uso

Seu risco de privacidade

Recomendações para proteger sua privacidade

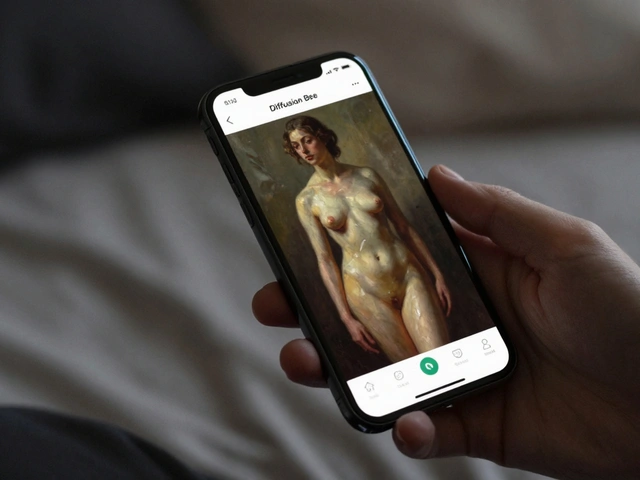

Ao usar um gerador de imagens como Crush AI uma plataforma que transforma textos em imagens com inteligência artificial, surge uma preocupação comum: será que a IA tem acesso ao que você escreve nos chats? Nesta leitura, vamos desvendar como essas ferramentas coletam, armazenam e utilizam seus prompts, quais riscos reais existem e como você pode se proteger sem abrir mão da criatividade.

Como o Crush AI gera imagens a partir de texto

O processo começa quando você digita um prompt, ou seja, a descrição que quer transformar em arte. O motor de IA, geralmente baseado em modelos de difusão como Stable Diffusion, interpreta as palavras, gera um vetor latente e converte esse vetor em pixels. Essa operação acontece em servidores da própria empresa ou em nuvens terceirizadas.

O que acontece com o seu prompt e a imagem gerada?

Assim que você envia o prompt, ele entra na fila de processamento. Na maioria dos casos, o texto é armazenado temporariamente para melhorar a latência e, posteriormente, pode ser mantido em bancos de dados para treinamento futuro do modelo. A política de retenção varia de acordo com a empresa, mas muitas plataformas adotam práticas de privacidade de IA que permitem analisar padrões de uso.

Comparação de políticas de privacidade entre os principais geradores de imagem

| Plataforma | Armazenamento de prompts | Uso para treinamento | Opção de exclusão |

|---|---|---|---|

| Crush AI | 30 dias (pode ser estendido) | Sim, com anonimização | Botão "Excluir histórico" no painel |

| DALL·E | Até 90 dias | Opcional - usuário pode optar por não participar | Solicitação via suporte |

| Midjourney | Armazenamento ilimitado em servidores Discord | Não usado para treinamento externo | Não há ferramenta direta - exclusão manual |

| Stable Diffusion (versão open‑source) | Não há armazenamento centralizado | Treinamento depende do usuário | Controle total pelo usuário |

Riscos reais de vazamento de conversas

Embora grandes provedores invistam em segurança, nenhum sistema está isento de falhas. Um vazamento pode ocorrer por:

- Configurações inadequadas de servidores em nuvem.

- Erros humanos ao expor logs de auditoria.

- Ataques de engenharia social que obtêm credenciais de admin.

Quando isso acontece, terceiros podem acessar o texto original, a imagem gerada e até metadados como hora e IP. Se o prompt contiver informações sensíveis - nomes, endereços ou ideias confidenciais - a consequência pode ser grave.

Como proteger sua privacidade ao usar geradores de imagem

- Leia a política de privacidade antes de começar. Verifique o prazo de retenção e se há opção de exclusão.

- Evite incluir dados pessoais reais nos prompts. Substitua nomes por pseudônimos.

- Use versões open‑source como Stable Diffusion em um ambiente local, se precisar de total controle.

- Ative a autenticação de dois fatores (2FA) nas contas do serviço.

- Apague regularmente o histórico de geração na plataforma.

- Considere criptografar o prompt antes de enviá‑lo, usando ferramentas que fazem “obfuscation” de texto.

Essas práticas são recomendadas tanto no Brasil - sob a LGPD - quanto na Europa, regida pelo GDPR. Ambas exigem transparência sobre coleta de dados e permitem que o usuário solicite a exclusão.

Regulamentação e direitos digitais: o que vem por aí

Em 2024, a Autoridade Nacional de Proteção de Dados (ANPD) começou a analisar casos específicos de IA generativa. A expectativa é que, até 2026, haja normas que obriguem empresas a:

- Fornecer relatórios claros de uso de dados para cada usuário.

- Permitir a portabilidade dos prompts em formatos legíveis.

- Implementar “right to be forgotten” (direito ao esquecimento) em tempo real.

Essas mudanças podem reduzir a possibilidade de que um crush de IA - ou seja, uma IA que “se apaixona” pelos seus dados - tenha acesso indefinido às suas conversas. Enquanto isso, fique de olho nos comunicados oficiais da ANPD e dos próprios provedores.

Perguntas frequentes

O Crush AI armazena meus prompts?

Sim, os prompts são guardados por até 30 dias para melhorar a performance e podem ser usados de forma anonimizada para treinar o modelo, salvo se você optar pela exclusão manual.

Posso excluir meus dados depois de gerar a imagem?

A maioria das plataformas, incluindo o Crush AI, oferece um botão de “Excluir histórico” que remove o prompt e a imagem dos servidores. Em alguns casos, pode ser necessário abrir um ticket de suporte.

O que fazer se descobrir que meus prompts vazaram?

Informe imediatamente o provedor, solicite a remoção dos dados e, se necessário, registre uma reclamação na ANPD ou no órgão de proteção de dados da sua região.

Existe diferença de privacidade entre serviços pagos e gratuitos?

Em geral, planos pagos oferecem opções avançadas de controle de dados, como retenção curta e exclusão automática, enquanto planos gratuitos costumam manter os dados por períodos maiores para fins de otimização.

Usar IA open‑source resolve o problema?

Rodar modelos como Stable Diffusion localmente elimina a coleta de dados por terceiros, mas ainda exige que você proteja seu próprio ambiente (firewall, atualizações).

10 Comentários

Olha, esses serviços guardam teu prompt por dias, nada de magia, é só log.

Isso é um roubo descarado, brasileiro tem direito de saber onde sua ideia vai parar! 😡 Não aceita essa exploração silenciosa, exige transparência agora!

Na prática, o Crush AI retém os prompts até 30 dias, enquanto o DALL·E vai até 90, e o Midjourney nem tem limite definido.

Quando você escreve um prompt, ele imediatamente entra em fila de processamento nos servidores da empresa.

Esses dados são frequentemente temporariamente armazenados para melhorar a latência da geração.

Depois, muitas plataformas mantêm cópias por semanas ou meses, como forma de treinar modelos futuros.

A boa notícia é que a maioria oferece mecanismos de exclusão manual, bastando clicar em “Excluir histórico”.

Entretanto, a efetividade desses botões depende da política interna de retenção, que nem sempre é clara.

Para quem preza pela privacidade, a solução mais segura é rodar modelos open‑source localmente, como o Stable Diffusion.

Assim, nenhum dado sai da sua máquina, e você controla totalmente os logs gerados.

Se preferir usar serviços online, habilite a autenticação de dois fatores (2FA) para proteger sua conta contra invasões.

Além disso, evite inserir informações pessoais nos prompts; use pseudônimos ou termos genéricos.

Caso a empresa ofereça a opção de não participar do treinamento, marque essa caixa sempre que disponível.

Fique atento às atualizações da LGPD no Brasil e do GDPR na Europa, que exigem relatórios de uso de dados.

A ANPD tem sinalizado que normas mais rígidas podem surgir até 2026, reforçando o direito ao esquecimento em tempo real.

Enquanto isso, mantenha um hábito de baixar e armazenar localmente as imagens que você realmente quer guardar.

Isso reduz a necessidade de depender do armazenamento em nuvem da plataforma.

Por fim, se perceber algum vazamento, denuncie imediatamente ao provedor e registre reclamação nos órgãos de proteção de dados.

Excelente panorama! Vale lembrar que há comunidades que compartilham scripts prontos para criptografar prompts antes de enviá‑los, o que pode ser um extra de segurança.

Além disso, participar de fóruns ajuda a ficar por dentro das atualizações das políticas de privacidade.

Na real, muita gente acha que essas políticas são só marketing; o fato é que o histórico pode ser acessado por funcionários internos se houver brecha.

Guardam tudo, ponto.

Se o preço da conveniência é sua privacidade, pense bem antes de pagar.

A verdade é que a maioria das IA ainda depende de dados massivos coletados sem consentimento explícito, uma afronta ao princípio da soberania digital.

Isso é pura tragédia, mexeu com a minha cabeça, nunca mais confio nesses monstros de algoritmo!!!