O que são bibliotecas de prompts e por que elas importam?

Se você já trabalhou com modelos de linguagem grande (LLMs) em equipe, provavelmente já passou por isso: um membro da equipe usa um prompt que funciona perfeitamente, mas quando outro tenta copiar e colar, o resultado é uma bagunça. Isso não é falha do modelo. É falha do processo. Quando cada pessoa cria seus próprios prompts do zero, você acaba com centenas de versões diferentes da mesma coisa - e nenhuma delas é documentada, testada ou reutilizável.

Bibliotecas de prompts são coleções organizadas de instruções pré-criadas, prontas para serem usadas, modificadas e compartilhadas. Elas não são só arquivos de texto. São infraestrutura. Assim como um time de desenvolvimento usa bibliotecas de código, times de IA precisam de bibliotecas de prompts. E isso não é mais opcional. Em 2026, 63% das empresas com mais de 10 profissionais de IA já usam sistemas formais de gestão de prompts, segundo o Forrester.

Por que isso faz tanta diferença? Porque prompts bem feitos reduzem o uso de tokens em até 37% e melhoram a qualidade das respostas em 52%, conforme um estudo da Stanford HAI de novembro de 2025. Isso significa menos custo, menos tempo e menos retrabalho. Mas só funciona se a biblioteca for bem estruturada.

Como estruturar um prompt para reutilização

Não adianta só salvar um texto qualquer como "prompt de resumo". Um prompt reutilizável precisa de estrutura. O padrão mais eficaz, adotado por equipes de Google, Microsoft e Anthropic, é o modelo contexto-instrução-exemplos.

- Contexto: O que o modelo precisa saber antes de responder? Ex: "Você é um assistente jurídico especializado em direito trabalhista português."

- Instrução: O que exatamente você quer que ele faça? Ex: "Resuma o texto abaixo em até 3 frases, destacando os direitos violados."

- Exemplos: Pares de entrada-saída que mostram o formato esperado. Ex: "Entrada: [texto] → Saída: [resumo]"

Essa estrutura não é sugestão. É regra. Equipes que seguem esse padrão têm 43% menos inconsistências entre os resultados produzidos por diferentes membros, segundo um estudo da IBM de outubro de 2025. E o melhor: você pode transformar isso em um template em JSON ou YAML, com variáveis dinâmicas. Por exemplo:

{

"name": "resumo_juridico",

"template": "Você é um assistente jurídico especializado em direito trabalhista português. Resuma o texto abaixo em até 3 frases, destacando os direitos violados.\n\nTexto: {{input_text}}\n\nExemplo: \nEntrada: [texto sobre demissão sem justa causa] \nSaída: O funcionário foi demitido sem justa causa, violando o artigo 396 do Código do Trabalho português. Recomenda-se ação judicial para indenização."

}Com isso, basta passar o texto real na variável {{input_text}} e o prompt funciona sempre da mesma forma - independentemente de quem o usa.

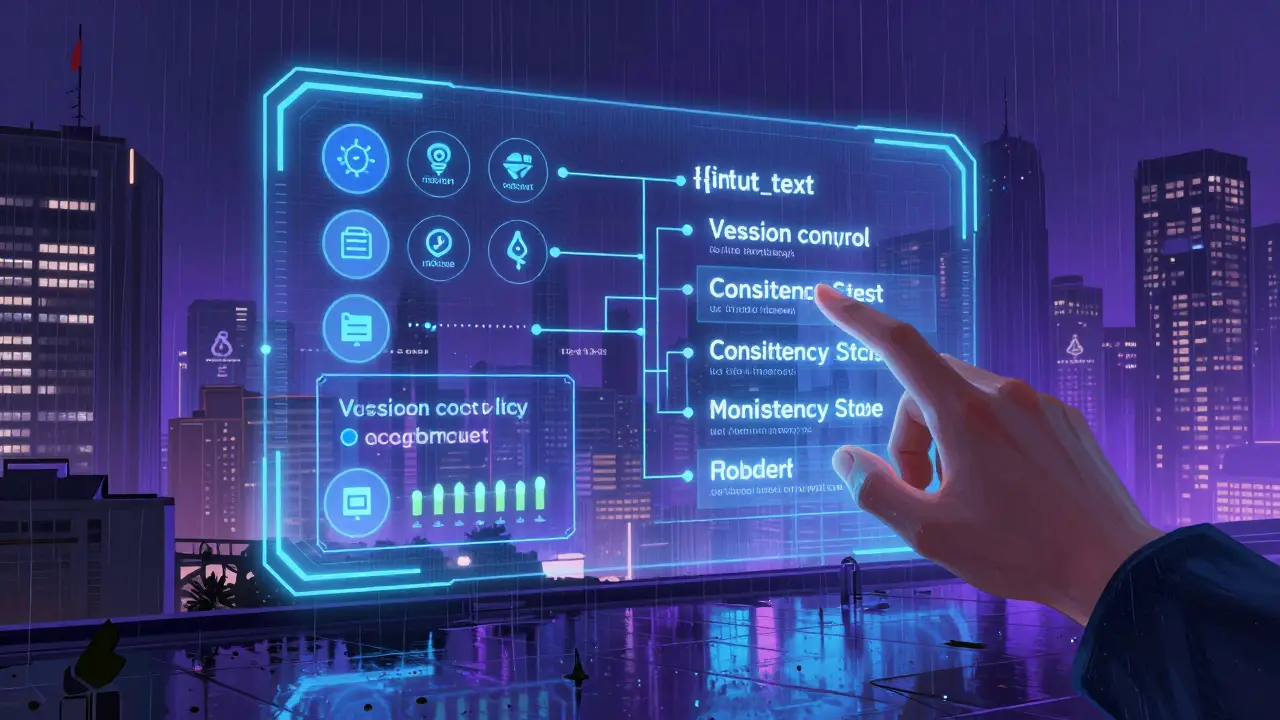

Por que versão e controle são essenciais

Imagine que você tem um prompt que gera relatórios financeiros. Funciona perfeitamente. Até que, em fevereiro, o modelo é atualizado. De repente, ele começa a ignorar partes importantes dos dados. Sem controle de versão, você não sabe qual versão do prompt estava em uso. Não sabe se o erro veio do modelo ou do prompt. E não consegue voltar atrás.

Equipes que usam bibliotecas de prompts profissionais integram tudo ao Git. Cada alteração no prompt é um commit. Cada versão tem um ID, um autor, uma data e uma descrição. Ferramentas como PromptHub (com mais de 2.800 estrelas no GitHub até 2026) permitem até comparar diferenças entre versões de prompts como se fossem códigos.

Isso não é só para segurança. É para responsabilidade. Se um relatório errado for gerado por um prompt desatualizado, você consegue rastrear exatamente quem alterou, quando e por quê. E se precisar reverter, basta um clique.

Como medir a eficácia de um prompt

Um prompt não é bom porque "parece certo". É bom porque funciona. E para saber se funciona, você precisa medir. As três métricas mais usadas por equipes de IA em 2026 são:

- Eficiência em tokens: Quantos tokens de entrada e saída o prompt gera? Prompts otimizados reduzem o uso em até 37%.

- Taxa de sucesso: Em quantas tentativas a saída atendeu aos critérios de qualidade? Um bom prompt tem mais de 85% de sucesso.

- Consistência: Se você rodar o mesmo prompt 10 vezes, quão parecidas são as respostas? A similaridade semântica entre elas deve ser acima de 0.85 (em escala de 0 a 1).

Essas métricas não são teóricas. Elas são integradas em plataformas como PromptFlow 2.0 da Google (lançado em dezembro de 2025) e em soluções open-source como PromptHub. Equipes que monitoram esses dados têm 29% mais qualidade nas saídas, segundo avaliações humanas da IBM.

Além disso, muitas equipes agora usam testes de regressão automáticos. Sempre que um novo modelo é implantado - como o GPT-4.5 ou o Claude 3.5 - a biblioteca roda todos os prompts principais e alerta se algum deles caiu de desempenho. Isso evita surpresas.

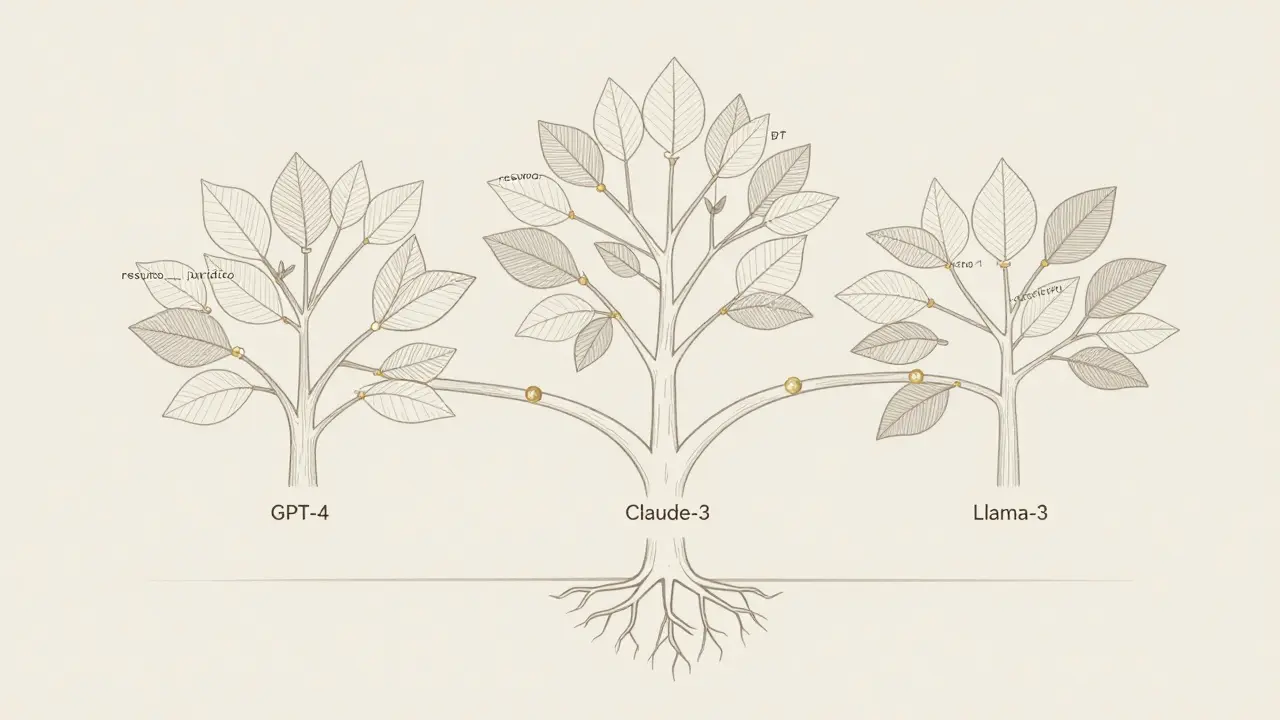

Diferenças entre modelos: um problema real

Um prompt que funciona perfeitamente no GPT-4 pode falhar no Claude 3 ou no Llama 3. Isso não é erro. É diferença de arquitetura. Modelos de raciocínio, como o Claude 3, respondem melhor a prompts com "chain-of-thought" (pensamento em etapas). Modelos mais tradicionais, como o GPT-4, podem se confundir se você pedir demais.

Equipes que não levam isso em conta acabam criando versões duplicadas do mesmo prompt para cada modelo - e isso vira um pesadelo de manutenção. A solução? Estruturar sua biblioteca com ramificações por modelo.

Exemplo:

/prompts/resumo_juridico/gpt-4.json/prompts/resumo_juridico/claude-3.json/prompts/resumo_juridico/llama-3.json

Cada arquivo contém a mesma lógica, mas ajustada para as características do modelo. O sistema de deploy escolhe automaticamente o template correto com base no modelo em uso. Isso exige mais organização, mas evita erros em produção.

Um estudo da NYU em 2023 aponta que "existem diferenças importantes ao fazer prompts para modelos de raciocínio versus modelos GPT". Ignorar isso é como usar o mesmo código em Python e em JavaScript sem ajustar a sintaxe.

Desafios reais - e como superá-los

Não é tudo perfeito. Quem já implementou uma biblioteca de prompts sabe: o começo é doloroso. Segundo a Gartner, 73% dos gerentes de engenharia relatam que o primeiro sistema levou entre 80 e 120 horas para ser construído. E ainda assim, 61% dos usuários no Hacker News reclamam que o sistema ficou obsoleto quando um novo modelo foi lançado.

Então, como evitar isso?

- Comece pequeno. Não tente migrar todos os prompts de uma vez. Escolha 3-5 que são críticos e repetitivos - como resumos, classificações ou respostas a FAQs.

- Automatize testes. Use scripts para rodar prompts contra conjuntos de dados de teste. Se a saída mudar, dispare um alerta.

- Documente por que cada prompt existe. Não basta ter o código. Escreva: "Este prompt foi criado para evitar erros de interpretação em contratos de trabalho. Testado com 50 entradas reais em 2025."

- Reveja mensalmente. Marque uma reunião fixa toda quarta-feira para revisar prompts com baixa taxa de sucesso ou alta variação.

Equipes que fazem isso têm 68% menos tempo gasto com iteração de prompts. Um usuário do Reddit (u/AI_Engineer_2025) disse: "Antes levávamos 3 a 4 dias para ajustar um prompt. Agora, em 6 a 8 horas, já temos uma versão estável."

O futuro: de bibliotecas para "blueprints" de IA

As bibliotecas de prompts não vão parar no que são hoje. Em 2026, grandes empresas já estão testando o que chamam de "AI workflow blueprints" - templates que não só contêm prompts, mas também definem a sequência completa de ações: qual modelo usar, quando chamar uma API externa, como validar a saída, quando pedir revisão humana.

Microsoft já lançou o Project PromptBridge (janeiro de 2026), uma camada que tenta traduzir prompts entre modelos diferentes. Anthropic promete otimização assistida por IA no Claude 3.5 (previsto para o segundo trimestre de 2026). E o Regulamento Europeu de IA, que entrou em vigor em janeiro de 2026, exige que todas as aplicações de alto risco documentem os prompts usados - o que está forçando empresas a adotar sistemas formais.

Segundo a McKinsey, 92% dos profissionais de IA acreditam que, até 2027, gerenciar prompts será tão comum quanto fazer testes de unidade em software. A Gartner vai além: prevê que "engenharia de prompts se tornará tão fundamental para o desenvolvimento de IA quanto testes de unidade são para a engenharia de software".

Mas há um aviso. Dr. James Manyika, ex-chefe da Google AI, alertou em novembro de 2025: "Depender demais de templates sem entender o funcionamento interno do modelo cria sistemas frágeis, vulneráveis a atualizações." E Dr. Margaret Mitchell, em um workshop da NeurIPS em 2025, lembrou: "Rigidez excessiva pode sufocar abordagens criativas que, em casos únicos, produziriam resultados melhores."

A resposta não é evitar templates. É usá-los como base - e manter espaço para experimentação. Um prompt bem documentado, versionado e testado é uma ferramenta. Não uma prisão.

Como começar hoje

Você não precisa de uma plataforma cara. Nem de um time de 10 pessoas. Pode começar com 3 passos simples:

- Reúna todos os prompts que sua equipe já usa. Colete-os em uma pasta. Não importa se estão desorganizados.

- Escolha o mais usado e transforme em template. Use o formato contexto-instrução-exemplos. Adicione variáveis. Salve como JSON.

- Coloque no Git e peça para todos usarem. Não force. Mostre o resultado: "Este template reduziu o uso de tokens em 30% e gerou respostas mais consistentes."

Em 4 a 6 semanas, você terá uma biblioteca funcional. Em 3 meses, ela estará ajudando novos membros a entrarem na equipe sem precisar de treinamento intensivo. E em 6 meses, você estará olhando para trás e se perguntando como conseguia trabalhar sem ela.

O que é mais importante em um prompt reutilizável: a estrutura ou a criatividade?

A estrutura. Prompts reutilizáveis precisam de consistência para funcionar em equipe. A criatividade tem seu lugar - mas em testes, não em produção. Use templates para garantir que tudo funcione, e depois permita que membros da equipe criem variações experimentais em branches separados. Isso equilibra eficiência e inovação.

Posso usar a mesma biblioteca de prompts para diferentes modelos, como GPT-4 e Claude 3?

Sim, mas não diretamente. Cada modelo entende instruções de forma diferente. O ideal é ter versões separadas do mesmo prompt para cada modelo, dentro da mesma biblioteca. Isso evita erros e garante que cada versão seja otimizada para o comportamento específico do modelo. Ferramentas como PromptHub e Project PromptBridge ajudam a gerenciar essas variações.

Como saber se um prompt está obsoleto?

Quando a qualidade cai. Monitore a taxa de sucesso e a consistência das respostas. Se, após uma atualização do modelo, o mesmo prompt passar a gerar saídas mais vagas, erradas ou incoerentes, ele está obsoleto. Implemente testes automáticos que rodem semanalmente. Se um prompt cair abaixo de 80% de sucesso, marque-o para revisão.

Preciso de conhecimento técnico avançado para criar uma biblioteca de prompts?

Não. Você precisa entender como escrever bons prompts e usar Git básico. Não precisa saber como treinar modelos. Muitas equipes começam com um engenheiro de IA e um analista que conhece bem os processos. A parte técnica - JSON, Git, integração - pode ser aprendida em duas semanas. O que importa é a disciplina de documentar e testar.

Existe algum risco legal em usar prompts sem documentação?

Sim. O Regulamento Europeu de IA, em vigor desde janeiro de 2026, exige que todas as aplicações de alto risco - como recrutamento, crédito ou diagnóstico médico - documentem exatamente quais prompts foram usados. Se você não tiver registros, pode enfrentar multas ou proibições. Mesmo que sua empresa não esteja na UE, ter documentação é uma prática de boa governança e proteção contra erros.

Próximos passos: o que fazer agora

Se você está em uma equipe de IA:

- Hoje: Reúna os 5 prompts mais usados por sua equipe.

- Esta semana: Escolha um e transforme em template com contexto-instrução-exemplos.

- Esta quinzena: Crie um repositório no Git e suba o primeiro template.

- Este mês: Peça para dois colegas usarem e anote os resultados.

Se você é gestor:

- Defina uma política de uso de prompts: todos os prompts em produção devem vir da biblioteca.

- Designe alguém para manter e revisar os templates mensalmente.

- Integre a biblioteca ao pipeline de CI/CD: se um prompt falhar nos testes, o deploy não avança.

A engenharia de prompts não é mais uma arte. É uma disciplina. E quem a adota primeiro, ganha tempo, dinheiro e qualidade - antes mesmo que os outros saibam que existia um problema.

8 Comentários

Essa ideia de biblioteca de prompts é ótima, mas na prática todo mundo ainda faz do jeito que acha melhor. Se não tem cultura de documentação, não adianta nada. Já vi time inteiro perder 2 semanas por causa de um prompt que ninguém sabia qual versão estava rodando.

Sei que parece chato, mas se não virar padrão, vira caos.

Template funciona só se ninguém mexer. Se um analista resolver 'melhorar' o prompt sem testar, o sistema desaba. Não é sobre estrutura, é sobre disciplina. E disciplina é o que falta.

Vocês estão tratando IA como se fosse um programa de Excel. Prompts não são código. São conversas. Se você botar tudo em template, vai matar a criatividade. O modelo não é uma máquina de respostas, é um parceiro. E parceiro não responde bem a ordens rígidas.

Se você quer eficiência, use regras de negócio. Se quer inteligência, deixe espaço para o caos.

Ah, então agora os brasileiros estão inventando gestão de prompts? Nós em Portugal já usamos isso desde 2024. E com muito mais rigor. Vocês acham que JSON resolve? Tem que ter controle de versão, revisão por pares, e auditoria de impacto. Sem isso, é só teoria de faculdade.

Se quiserem fazer direito, aprendam com os europeus. Não com os startups de São Paulo.

ISSO É UMA MERDA. TUDO QUE EU FAÇO É PERSONALIZADO. SE EU USAR UM TEMPLATE, MEU PROMPT VIRA UM ROBÔ. EU NÃO TRABALHO COM ROBÔS, TRABALHO COM INTELIGÊNCIA. VOCÊS ESTÃO MATANDO A ALMA DA IA COM ESSES TEMPLATES.

Vocês estão falando de estrutura como se fosse a única coisa que importa. Mas e a intuição? E o contexto real? Um prompt que funciona em 85% dos casos é bom o suficiente. O resto é perfeccionismo de quem nunca teve que entregar resultado na prática.

Eu já tive que corrigir relatórios quebrados por causa de templates rígidos. O modelo não é um robô. Ele precisa de espaço para respirar. Template é bom, mas não pode virar prisão.

Se você não tem um sistema de versionamento de prompts, você não é engenheiro de IA. Você é um amador que cola prompt no chat e espera que o modelo adivinhe o que você quer.

Eu já vi empresa perder R$200 mil por causa de um prompt desatualizado. E aí veio o pessoal dizendo 'ah, mas eu gosto de improvisar'. Não é improvisação, é negligência. E isso tem nome: incompetência disfarçada de criatividade.

template bom = menos trabalho. ponto.