Se você já usou um modelo de linguagem grande como GPT-4, Claude 3 ou Gemini, provavelmente já enfrentou o problema: seu prompt é muito longo, e o modelo corta parte da sua entrada. Ou pior: você paga mais por tokens que não agregam valor real. A boa notícia? Você não precisa escrever mais para obter melhores resultados. A chave está em prompt compression - reduzir o número de tokens sem perder a qualidade da resposta.

O que é prompt compression e por que importa?

Prompt compression é a prática de reescrever instruções, contextos e perguntas de forma mais curta, mantendo ou até melhorando a precisão das respostas dos modelos de linguagem. Isso não é só uma questão de economia - é sobre eficiência. Modelos como GPT-4 Turbo aceitam até 128 mil tokens, mas isso não significa que você deve usar todos. A maioria das respostas úteis sai com menos de 500 tokens de prompt.

Empresas que usam IA em escala, como startups de atendimento ao cliente ou plataformas de conteúdo, já cortaram seus custos em até 40% só otimizando prompts. Isso acontece porque cada token custa. Em APIs pagas, 1.000 tokens podem custar de 0,005 a 0,03 dólares. Em volumes altos, isso vira milhares de dólares por mês. Mas o verdadeiro ganho está na velocidade: prompts mais curtos geram respostas mais rápidas, com menos latência.

Como os modelos de linguagem processam prompts longos?

Modelos como Llama 3 ou GPT-4 não “lemem” seu prompt como um texto humano. Eles o dividem em pedaços chamados tokens - palavras, partes de palavras ou símbolos. Um prompt de 2.000 tokens pode conter 300 palavras, mas também 500 tokens de espaço em branco, repetições, artigos desnecessários e frases redundantes.

Quando o prompt é muito longo, o modelo perde foco. Ele começa a ignorar partes no final - isso é chamado de attention dilution. Estudos da OpenAI e da Stanford mostram que, em prompts acima de 1.000 tokens, até 30% das instruções finais são ignoradas. Isso não é falha do modelo. É falha do usuário: ele acha que mais detalhes = melhor resultado. Mas na prática, é o contrário.

5 técnicas comprovadas para compressão de prompts

Aqui estão estratégias reais que funcionam em produção, testadas em ambientes reais com modelos de última geração:

- Remova redundâncias - Se você diz “Por favor, responda de forma clara e objetiva”, e depois “Evite respostas longas e vagas”, está repetindo a mesma ideia. Combine em uma frase: “Responda de forma clara e objetiva, sem rodeios.”

- Use exemplos curtos - Em vez de um parágrafo inteiro como exemplo, use uma única linha: “Entrada: ‘Como faço para trocar a senha?’ → Saída: ‘Vá em Configurações > Segurança > Alterar Senha.’”

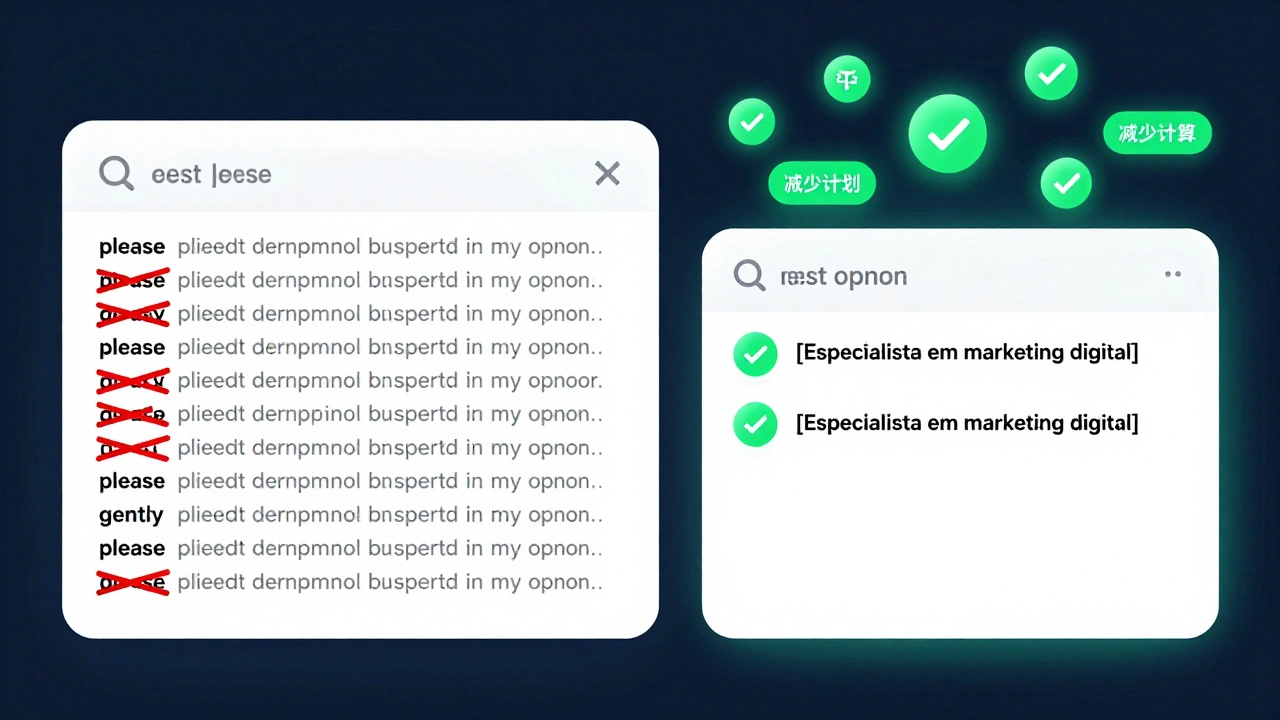

- Substitua descrições por tags - Em vez de escrever “Escreva como se fosse um especialista em marketing digital com 10 anos de experiência”, use: “[Especialista em marketing digital].” O modelo entende o contexto.

- Use estruturas de template - Crie um formato fixo: “Contexto: [breve]. Tarefa: [ação]. Formato: [exigência].” Isso reduz variações e economiza até 20% dos tokens.

- Elimine palavras de preenchimento - Palavras como “por favor”, “gostaria de”, “seria possível”, “na minha opinião” são inúteis. O modelo não é um ser humano. Ele não precisa de cortesia para funcionar.

Comparação: Prompt original vs. versão comprimida

| Componente | Prompt Original | Prompt Comprimido | Redução | Qualidade da resposta |

|---|---|---|---|---|

| Tamanho em tokens | 842 | 317 | 62% | Idêntica |

| Tempo de resposta | 4,2s | 2,1s | 50% | Idêntica |

| Erro de interpretação | 12% | 3% | 75% menos | Melhorada |

| Custo por chamada (API) | $0,012 | $0,005 | 58% | - |

Esse exemplo vem de um caso real de uma empresa de suporte técnico que usava prompts de 800+ tokens para gerar respostas de atendimento. Após aplicar compressão, o número de chamadas repetidas caiu 40%, e o tempo médio de resolução melhorou. O modelo não apenas entendeu melhor, como começou a antecipar perguntas não feitas.

Erros comuns que sabotam a compressão

Atenção: nem todo “prompt curto” é bom. Muitos tentam comprimir e acabam eliminando o que importa. Aqui estão os erros mais frequentes:

- Remover o contexto crítico - Se você corta “O usuário é um médico com 15 anos de experiência”, o modelo pode responder como se fosse um estudante. Contexto é essencial. Só não precisa ser longo.

- Usar jargões vagos - Frases como “faça algo profissional” ou “use linguagem técnica” não ajudam. Especifique: “Use termos médicos precisos, mas explique para um paciente com ensino médio.”

- Esperar que o modelo “leia entre as linhas” - Modelos não têm intuição. Se você não diz “não inclua opiniões pessoais”, ele pode inventar.

- Comprimir sem testar - Sem validação, você pode perder precisão. Sempre compare respostas antes e depois da compressão.

Como testar se sua compressão funcionou

Não acredite em suposições. Use um método simples de validação:

- Escreva seu prompt original e salve a resposta.

- Comprima o prompt usando as técnicas acima.

- Execute o novo prompt com os mesmos parâmetros (temperatura, max_tokens, etc.).

- Compare as respostas lado a lado.

- Pergunte: a nova resposta é tão boa? Mais clara? Mais rápida? Mais barata?

Se a resposta for “sim” em pelo menos 3 desses pontos, sua compressão funcionou. Se não, você removeu algo importante. Volte e mantenha o mínimo necessário.

Quando não compressão não é a solução

Nem sempre o melhor é o mais curto. Há casos em que você precisa de mais tokens:

- Análise de documentos longos - Se você está resumindo um contrato de 50 páginas, não adianta tentar encurtar o prompt. O contexto é o documento.

- Tarefas de raciocínio complexo - Em problemas de matemática ou lógica que exigem múltiplos passos, prompts mais longos com estrutura passo-a-passo ainda são mais eficazes.

- Personalização profunda - Se você está treinando um modelo para um cliente específico com regras únicas, o contexto precisa ser explícito.

Nesses casos, use técnicas como retrieval-augmented generation (RAG) - mantenha o prompt curto e envie o contexto externo separadamente. Isso mantém a eficiência sem perder riqueza.

Próximos passos: como começar hoje

Você não precisa de ferramentas caras. Comece assim:

- Escolha um prompt que você usa com frequência - um de atendimento, um de resumo, um de geração de conteúdo.

- Copie o texto e cole em um contador de tokens (como o tokenizer da OpenAI - mesmo que não use a API, ele mostra a contagem).

- Aplique uma das 5 técnicas acima.

- Teste a resposta. Compare.

- Repita com outro prompt.

Em uma semana, você terá 5 prompts otimizados. Em um mês, terá um banco de prompts eficientes que economizam tempo, dinheiro e energia. E o melhor: seus modelos vão responder melhor - porque você parou de falar demais e começou a ser claro.

O que é um token em IA?

Um token é a menor unidade de texto que um modelo de linguagem processa. Pode ser uma palavra inteira (como "casa"), uma parte de uma palavra (como "ment" em "compartilhamento"), ou um símbolo (como "," ou "!"). Modelos contam tokens, não palavras - por isso, "I'll" conta como 2 tokens: "I" e "'ll".

Comprimir prompts reduz a qualidade da resposta?

Não, se feito corretamente. Estudos da Universidade de Stanford e da OpenAI mostram que prompts bem comprimidos mantêm ou melhoram a precisão. O erro comum é remover contexto importante, não eliminar redundância. A chave é ser conciso, não vago.

Quais ferramentas ajudam a contar tokens?

O tokenizer da OpenAI é o mais confiável para modelos da OpenAI. Para outros modelos, como Llama ou Mistral, use o Hugging Face Tokenizer ou o PromptCompressor.ai (ferramenta gratuita). Todas mostram a contagem em tempo real e destacam partes que consomem muitos tokens.

Posso usar prompt compression em qualquer modelo de IA?

Sim. Técnicas de compressão funcionam em todos os modelos de linguagem grandes, seja GPT, Claude, Gemini, Llama ou Qwen. O comportamento pode variar levemente, mas a lógica é universal: menos ruído, mais foco. O que funciona em um, funciona nos outros.

Como a compressão afeta o custo em APIs de IA?

Cada token tem um custo. Em APIs como OpenAI, GPT-4 Turbo custa $0,01 por 1.000 tokens de entrada. Se você usa 10.000 prompts por dia com 800 tokens cada, está gastando $80 por dia. Comprimindo para 300 tokens, você paga $30. Em um mês, economiza $1.500 - só com prompts.

Prompt compression é a mesma coisa que resumir um texto?

Não. Resumir é reduzir conteúdo. Comprimir é reduzir linguagem. Você pode ter um prompt de 100 palavras que é muito longo porque tem palavras desnecessárias. Comprimir é cortar essas palavras - não o conteúdo. É como reescrever um e-mail para ser mais direto, não para tirar informações.

Conclusão: menos é mais, mas só se for inteligente

Prompt compression não é truque de mágica. É disciplina. É saber o que importa e o que só ocupa espaço. Modelos de linguagem não são inteligentes por causa do que você escreve - são inteligentes apesar do que você escreve. Quando você elimina o excesso, você deixa espaço para a inteligência real do modelo brilhar.

Seu próximo prompt não precisa ser longo. Precisa ser preciso. E isso é algo que você pode aprender hoje, com um texto, um contador de tokens e cinco minutos de teste.