Inteligência artificial e preconceito: o que você precisa saber agora

Quando você usa um algoritmo de seleção de currículos, um sistema de IA que analisa candidatos a empregos com base em padrões históricos, ele pode estar rejeitando mulheres ou pessoas de origens étnicas específicas — não porque é mal-intencionado, mas porque foi treinado com dados que refletem décadas de discriminação real. Isso é inteligência artificial e preconceito, o fenômeno em que sistemas de IA reproduzem e amplificam desigualdades sociais já existentes. Não é ficção científica. É o que está acontecendo em hospitais, tribunais, bancos e até em aplicativos de emprego. A IA não inventa preconceitos, ela só os copia com mais velocidade e mais autoridade.

Esse problema não vem só de dados ruins. Ele também aparece quando empresas usam ferramentas de reconhecimento facial, sistemas que identificam rostos em câmeras de segurança ou celulares treinadas quase exclusivamente com imagens de pessoas brancas. Resultado? Elas erram até 35% mais em rostos negros. Ou quando um chatbot de atendimento, um assistente automático usado por empresas para responder dúvidas de clientes ignora perguntas feitas com sotaques regionais ou linguagem informal — e acaba tratando clientes de baixa renda como "menos importantes". Esses não são erros técnicos. São falhas éticas. E elas afetam vidas reais: pessoas que perdem empregos, são negadas empréstimos ou são paradas pela polícia por causa de um algoritmo confuso.

Se você acha que isso não é problema seu, pense de novo. Você já usou um gerador de imagem que só mostra homens brancos como médicos? Já viu uma IA sugerindo que mulheres não são boas para cargos de liderança? Isso não é coincidência. É o resultado de quem escolheu os dados, quem programou os filtros e quem decidiu que "normal" era um padrão estreito. E isso está em todos os lugares onde a IA é usada sem supervisão. A boa notícia? Você não precisa ser cientista para entender ou questionar isso. Ainda que você só use ChatGPT para escrever e-mails ou gerar ideias, você está interagindo com sistemas que carregam esses vieses. O que você pede, o que aceita como resposta, o que ignora — tudo isso alimenta ou combate o problema.

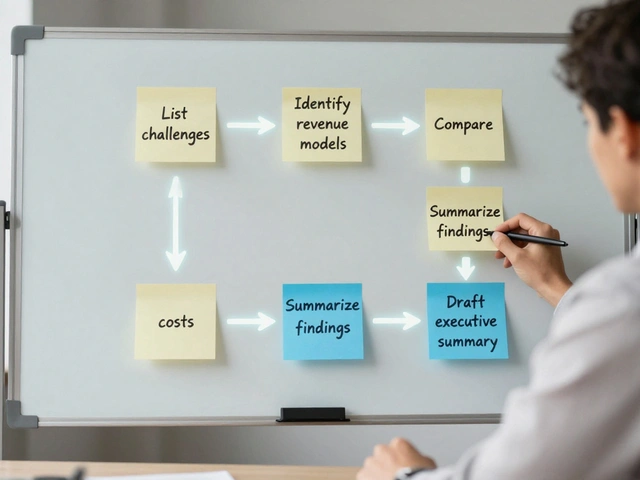

Na lista abaixo, você vai encontrar artigos que explicam exatamente isso: como a IA reproduz preconceitos, quais ferramentas já estão causando danos reais, e o que você pode fazer para não se tornar parte do problema. Temos textos sobre como a IA pode ser discriminatória no mercado de trabalho, sobre os riscos legais de usar imagens geradas por IA sem saber de onde vieram, e até sobre como empresas estão sendo processadas por isso. Não é sobre ser contra a tecnologia. É sobre usá-la com consciência. E isso começa quando você entende que a IA não é neutra — ela só reflete quem a criou.