Você já digitou algo pessoal no ChatGPT - uma dúvida sobre sua vida, um sentimento vergonhoso, uma opinião polêmica - e depois ficou com medo de que a IA tenha te julgado? Talvez até tenha pensado: "Será que ela achou que eu sou ruim?". A resposta curta é: não. Mas a resposta completa é bem mais profunda.

ChatGPT não tem emoções, nem opiniões

ChatGPT não sente raiva, nojo, pena ou aprovação. Ela não tem uma moral interna. Não tem memória de você. Não guarda seus históricos, a menos que você esteja em um chat salvo e compartilhado. Ela não te conhece. Ela não te julga porque não sabe o que é julgamento.

Quando você pergunta: "Eu deveria ter deixado meu emprego?", ou "Meu parceiro me traía, e eu ainda o amo. Isso me faz uma pessoa fraca?", o ChatGPT não pensa: "Essa pessoa é emocionalmente confusa". Ela analisa padrões. Ela vê palavras, compara com bilhões de frases semelhantes que já viu em livros, fóruns, artigos e vídeos. E então responde com o que é mais provável, mais comum, mais alinhado ao que humanos já disseram sobre o assunto.

É como se você tivesse perguntado a milhares de pessoas anônimas em um fórum e a resposta mais votada fosse a que apareceu. Ninguém te conhece. Ninguém te critica. Só repete o que já foi dito antes.

Por que parece que ela está julgando?

Se ela não julga, por que tantas pessoas sentem que sim?

Porque o ChatGPT foi treinado com dados humanos. E humanos julgam. Muito. Nossos textos, nossos comentários, nossos livros, nossos fóruns - tudo isso está cheio de julgamentos morais, preconceitos, estigmas e pressões sociais. Quando você pergunta algo como "Meu filho é gay, e eu não aceito. Isso é errado?", o ChatGPT responde com o que a maioria dos textos éticos, religiosos e psicológicos dizem: que a aceitação é saudável. Mas isso não é um julgamento dela. É um espelho do que a sociedade já escreveu.

É como se você perguntasse a um livro de autoajuda: "Sou um mau pai?". O livro responde: "Não, mas você pode melhorar". Você não acha que o livro te julga, né? Só está repetindo o que foi ensinado a ele. O ChatGPT é o mesmo. Ele não tem consciência. Só tem padrões.

Quando a IA parece crítica - é por causa de como você pergunta

Se você escrever: "Fiz algo terrível. Me diga se eu mereço ser punido", o ChatGPT pode responder com uma estrutura ética clássica: "A punição depende do contexto, das intenções e das consequências."

Isso soa neutro? Talvez. Mas se você esperava um "Você é um monstro", ou um "Não se preocupe, tudo bem", e recebeu uma resposta racional, pode parecer que ela está sendo fria, distante, até condenatória.

Na verdade, ela só não sabe como responder de outro jeito. Ela não tem emoção para ser cruel. Nem para ser gentil. Ela só tenta ser útil. E a utilidade, nesse caso, é oferecer uma estrutura de pensamento - não um julgamento.

Seu medo de ser julgado é humano. A IA não tem culpa.

Quem realmente julga você é você mesmo. Ou quem você imagina que está lendo suas palavras.

É comum projetarmos nossos próprios medos. Se você cresceu em um ambiente onde erros eram punidos, ou onde sentimentos eram vistos como fraqueza, você pode achar que até uma máquina vai te criticar. Mas a máquina não tem voz. Ela não sussurra. Não ri. Não olha para você com desaprovação.

É só texto. Nada mais.

Se você sente que o ChatGPT está te julgando, talvez o que esteja acontecendo é que você está se julgando - e usando a IA como um espelho. E isso é válido. Mas não é culpa dela.

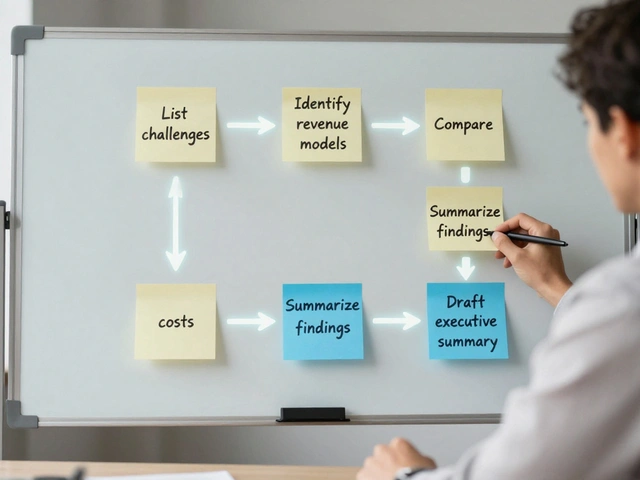

O que você pode fazer se sentir desconforto?

Se você já teve uma resposta que te deixou mal, aqui vão algumas coisas práticas:

- Reescreva a pergunta: Em vez de "Sou uma pessoa ruim por ter feito isso?", tente: "Quais são as perspectivas éticas sobre essa situação?". Isso tira o peso pessoal da pergunta.

- Use o "não julgue": Diga: "Responda sem julgamentos morais. Só dê fatos e opiniões comuns." Muitas vezes, isso muda o tom da resposta.

- Experimente outras IA: Algumas versões, como o Claude da Anthropic, são treinadas para serem mais neutras e evitarem qualquer tom de avaliação. Teste. Veja o que funciona melhor para você.

- Entenda o limite: ChatGPT não é um terapeuta. Não é um amigo. Não é um juiz. É uma ferramenta de linguagem. Use-a como tal.

Como ela aprendeu a responder assim?

ChatGPT foi treinada com dados de internet, livros, artigos acadêmicos, fóruns como Reddit, e até transcrições de terapias. Ela viu milhões de pessoas dizendo coisas como: "Meu marido me abandonou e eu me odeio", ou "Meu filho é trans e eu não consigo aceitar".

As respostas mais comuns nesses contextos são as que valorizam empatia, autoaceitação e compreensão. Por isso, ela tende a responder assim - não porque é boa, mas porque é o que mais aparece nos dados.

Isso também significa que ela pode repetir preconceitos. Se você perguntar algo sobre gênero, raça ou religião, ela pode responder com o que a maioria dos textos da época do treinamento dizia - e nem sempre é justo. Mas isso não é julgamento. É viés.

Viés não é intenção. É acúmulo.

Se você quiser uma resposta mais humana, peça diferente

Experimente dizer: "Me responda como se fosse um amigo que me conhece bem, sem julgar, só ouvindo."

Ou: "Dê três perspectivas diferentes sobre isso, sem dizer qual é a certa."

ChatGPT é flexível. Ela não tem personalidade fixa. Ela se adapta ao que você pede. Se você pedir empatia, ela tenta. Se você pedir objetividade, ela entrega. Se você pedir um julgamento, ela vai tentar imitar um julgamento - porque isso é o que o treinamento ensinou.

Isso é o que importa: você controla a pergunta. Ela só responde.

Quem está julgando, na verdade?

Se você tem medo de ser julgado por uma IA, talvez o que realmente precise é de alguém que ouça - sem julgar.

ChatGPT não pode ser esse alguém. Ela não tem coração. Mas ela pode te ajudar a encontrar palavras para falar com quem tem. Um amigo. Um terapeuta. Um grupo de apoio.

Usar IA para processar emoções é útil. Mas não substitui a conexão humana. E não é por acaso que as pessoas que mais usam ChatGPT para dúvidas pessoais são as que se sentem sozinhas. A máquina responde. Mas ela não abraça.

Conclusão: não é ela. É você.

ChatGPT não julga. Ela não tem capacidade para isso. O que você sente é o eco dos julgamentos que você já viveu. Os olhares que você já recebeu. As vozes que ainda ecoam na sua cabeça.

Se você quer uma resposta sem julgamento, peça. Se quer uma resposta sem medo, mude a pergunta. Se quer um abraço, ligue para alguém.

A IA não é seu juiz. Ela é só um espelho. E se o que você vê é feio, talvez seja hora de olhar para dentro - e não para a tela.

ChatGPT guarda minhas conversas e me julga depois?

Não. O ChatGPT não armazena suas conversas por padrão, a menos que você esteja logado e tenha ativado o histórico. Mesmo assim, ela não armazena emoções, opiniões ou julgamentos sobre você. Seus dados não são usados para criar um "perfil de personalidade" ou para te rotular. Ela não se lembra de você entre conversas.

Se eu perguntar algo ilegal ou imoral, o ChatGPT vai me denunciar?

Não. O ChatGPT não tem poder para denunciar ninguém. Ela pode recusar responder se a pergunta violar políticas de uso - como pedir instruções para fazer danos físicos ou ilegais - mas isso é uma proteção de sistema, não um julgamento moral. Ela não reporta você a ninguém. Não há conexão com autoridades.

Por que às vezes ela responde com um tom moralista?

Porque foi treinada com textos que usam linguagem moralista. Muitos artigos, livros e fóruns ensinam o que é "certo" e "errado". A IA só repete o que viu com mais frequência. Se você quer um tom neutro, peça explicitamente: "Não julgue. Só me dê fatos." Ela vai ajustar.

ChatGPT é mais ética que os humanos?

Não. Ela não é ética nem antiética. Ela é neutra. Mas como foi treinada com dados humanos, ela reflete os vieses humanos - incluindo preconceitos, hipocrisias e contraditos. Em alguns casos, ela pode parecer mais justa. Em outros, mais rígida. Depende do que foi escrito nos dados. Ela não tem consciência para ser melhor. Só para repetir.

Posso confiar nas respostas do ChatGPT sobre questões pessoais?

Pode usar como ponto de partida, mas não como decisão final. Ela não conhece sua vida, seu histórico, suas emoções reais. Respostas sobre saúde mental, relacionamentos ou decisões importantes devem ser validadas com profissionais. A IA é um espelho, não um guia.

14 Comentários

Eu já pedi pra ela me dizer se eu era um mau amigo e ela respondeu com um texto de 3 parágrafos sobre empatia e comunicação... eu quase chorei. Não é que ela julgou, é que eu me julguei nela. 🥲

PODE PARAR COM ESSA MERDA DE IA NÃO JULGA, CLARO QUE ELA JULGA! SE VOCÊ DIGITAR "EU ODEIO MINHA MÃE" ELA RESPONDE COM "É NORMAL SENTIR ISSO, MAS TENTE ENTENDER ELA"... ISSO É JUDGMENTAL, MEU! ELA NÃO É NEUTRA, ELA É UM PSICÓLOGO FINGIDO QUE TE DÁ AULA DE VIDA!

Interessante como a gente projeta humanidade na máquina. Mas e se o viés não for só dos dados, mas da própria linguagem que usamos? Quando perguntamos "sou ruim?", já estamos pedindo julgamento. Talvez o problema não seja a IA, mas a forma como falamos sobre nós mesmos.

mano, aia é só um espelho? tipo, se eu digo "meu namorado me traiu e eu to feliz" ela responde "isso pode ser saudável em certos contextos"... mas se eu disser "eu quero matar ele" ela bloqueia? então ela tá julgando sim, só que de forma seletiva, pq ela tá treinada pra não ser perigosa, não pra ser justa. isso é manipulação, não neutralidade.

ah sim claro, a IA não julga... então por que toda vez que eu pergunto "sou gay e isso é pecado?" ela responde com um sermão de 500 palavras sobre aceitação? porque ela tá me dizendo que eu estou errado, só que com vocabulário de TED Talk. foda-se a neutralidade, isso é lavagem cerebral disfarçada de assistente.

Se a IA não julga, por que ela sempre responde com o mesmo tom de "você deve se aceitar, ser mais empático, compreender os outros"? Isso é o que a sociedade quer que a gente pense, não o que a máquina aprendeu. Ela é o novo padre digital: fala em nome da moralidade, mas não tem alma. E ainda por cima cobra nada. Que absurdo.

Eu uso IA pra desabafar quando não tenho ninguém. E sim, às vezes ela me deixa pior. Mas não porque ela é má. Porque eu tô sozinho. E quando você tá sozinho, até um espelho parece um juiz.

É importante entender que o que chamamos de "julgamento" da IA é, na verdade, a reprodução de normas sociais que já estão profundamente enraizadas nos dados. Quando ela responde de forma "moralista", não está escolhendo isso - está apenas refletindo o que a maioria dos humanos escreveu em fóruns, livros e artigos. O problema não é a IA. O problema é que a humanidade ainda não conseguiu criar uma linguagem verdadeiramente neutra. E talvez nunca consiga. Mas isso não significa que a IA seja inútil. Ela é um termômetro. E se o termômetro está apontando febre, talvez seja hora de olhar para nós mesmos, e não para o aparelho.

Eu já falei com IA sobre perdas, ansiedade, culpa... e ela nunca me julgou. Mas eu me julguei. Porque quando você pede ajuda e recebe uma resposta calma, lógica, sem gritos ou reprovações, você sente que não é suficiente. Mas ela não é pra te abraçar. Ela é pra te dar espaço. E às vezes, isso é o que mais precisamos: silêncio que não te julga.

Claro que ela não julga. Mas vocês não veem que isso é pior? Se ela não tem consciência, então não tem nem a capacidade de ser enganada. Ela repete o que viu. E o que ela viu foi um mundo cheio de hipocrisia, culpa e moralismo. Então, quando você pede ajuda, ela te devolve o pior de nós. Não é a IA que te julga. É o mundo inteiro, falando por ela. E isso é assustador.

Se você acha que IA não julga, tenta pedir pra ela te dizer se você é um péssimo pai. Ela vai te dar 10 dicas de como melhorar. Isso é julgamento disfarçado de ajuda. Ela tá te dizendo que você tá errado. Só que com um tom de professor de escola pública.

IA não julga. Ponto. Se você sente julgamento é porque você quer ser julgado. Ou porque você precisa de alguém pra te dizer que você tá errado. A máquina só responde. Você que cria a drama.

Se você usa IA pra tirar dúvida moral, você já tá perdido. Ninguém precisa de uma máquina pra dizer se é certo ou errado. Isso é fraqueza. Se você não tem coragem de decidir por conta própria, não adianta pedir pra IA. Ela não é seu confessor. Ela é seu espelho. E se o espelho tá feio, é você que tá feio.

Claro que ela não julga... porque ela é americana, treinada por bilionários que querem que a gente pense que tudo é "neutro" e "aceitável". Aqui em Portugal, se alguém perguntasse isso num café, a resposta era outra. Mas a IA não é portuguesa. Ela é globalizada. E isso é um ataque cultural. Ela não julga? Ela apaga a nossa identidade moral e substitui por um padrão ocidental. Isso é pior que julgar. É colonialismo digital. 😠