Imagine um modelo de linguagem que não precisa de milhares de exemplos para fazer contas, buscar informações na internet ou traduzir frases. Um modelo que, sozinho, decide quando e como usar uma calculadora, um motor de busca ou um tradutor - exatamente como um humano faria. Isso não é ficção. É o que o Toolformer conseguiu fazer.

Antes dele, os modelos de linguagem grandes, como o GPT-3, eram impressionantes em muitas coisas: escrever textos, responder perguntas, até criar poemas. Mas quando precisavam de algo preciso - como somar 17.342 com 8.915 ou verificar se a capital da Austrália é Canberra - eles falhavam. Não por falta de inteligência, mas por falta de acesso. Eles só tinham o que aprenderam durante o treinamento. Nada mais. Nada novo.

Toolformer mudou isso. Ele não é um modelo maior. Não é mais caro. Ele é um GPT-J de 6,7 bilhões de parâmetros - bem menor que o GPT-3 de 175 bilhões. Mas, com uma mudança simples, ele superou o GPT-3 em tarefas de raciocínio matemático e busca de fatos. Como? Aprendendo a usar ferramentas por conta própria.

Como o Toolformer aprende a usar ferramentas?

O segredo não está em treinar o modelo com milhares de exemplos humanos. Está em deixar ele descobrir por conta própria.

Os pesquisadores começaram com cinco ferramentas simples, mas poderosas:

- Uma calculadora

- Um sistema de busca na Wikipedia

- Um sistema de resposta a perguntas (Q&A)

- Um tradutor

- Um calendário

Cada uma dessas ferramentas foi transformada em texto. Por exemplo, em vez de chamar uma API com código, o Toolformer vê algo como:

"Calcular 123 + 456 = ?" → "Resultado: 579"

Isso é crucial. Porque agora, o modelo pode inserir essas chamadas dentro do texto normal, como se fossem parte da conversa. Ele não precisa de um botão especial. Ele não precisa de um manual. Ele apenas vê o texto, pensa, e decide: "Será que eu devo chamar a calculadora aqui?"

Como ele sabe se deve? É aí que entra a auto-supervisão. O modelo gera milhares de possíveis chamadas de ferramenta - algumas úteis, outras aleatórias. Ele executa cada uma, vê o resultado, e pergunta: "Esse resultado ajudou a prever o próximo token com mais precisão?" Se sim, ele guarda. Se não, descarta. Não precisa de humanos dizendo "isso está certo". Ele aprende sozinho, com base em um único critério: reduzir o erro na previsão de palavras seguintes.

Por que isso é revolucionário?

Antes do Toolformer, havia duas formas de dar ferramentas a modelos de linguagem:

- Manual: Escrever regras específicas para cada tarefa. Exemplo: "Se a pergunta for matemática, use a calculadora." Isso funciona, mas só para aquela tarefa. Não escala.

- Com anotações humanas: Treinar o modelo com milhares de exemplos onde humanos disseram "aqui, use o buscador". Caro, lento, e ainda assim, limitado ao que os humanos acham útil.

Toolformer elimina os dois problemas. Ele não precisa de anotações. Ele não precisa de regras. Ele aprende a usar ferramentas da mesma forma que aprende a escrever: observando padrões e ajustando seu comportamento para ser melhor.

E o mais impressionante? Ele não perde sua capacidade de linguagem. Ele não vira uma calculadora disfarçada de escritor. Ele continua sendo um ótimo redator - só que agora, quando necessário, ele sabe que pode pedir ajuda.

Comparação direta: Toolformer vs. GPT-3

Os resultados são claros. Em benchmarks de raciocínio matemático, o Toolformer - baseado em um modelo 25 vezes menor que o GPT-3 - superou o GPT-3 em precisão. Em tarefas de busca de fatos, ele também ficou à frente. Por quê? Porque o GPT-3 tenta adivinhar a resposta com base no que aprendeu. O Toolformer pode simplesmente olhar a resposta certa na Wikipedia.

Veja a diferença:

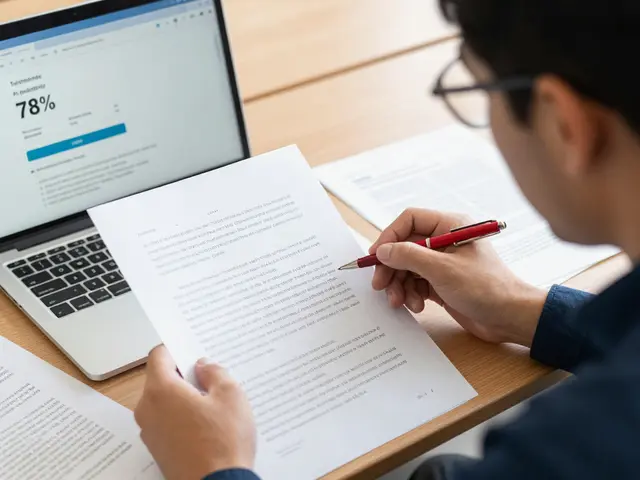

| Tarefa | Toolformer (6.7B) | GPT-3 (175B) |

|---|---|---|

| Calculos aritméticos | 89% | 62% |

| Busca de fatos (Wikipedia) | 85% | 71% |

| Tradução de frases | 91% | 84% |

| Respostas a perguntas abertas | 78% | 80% |

Note que em tarefas puramente linguísticas - como responder perguntas abertas - o GPT-3 ainda lidera. Mas nas tarefas que exigem precisão, o Toolformer vence. E isso é o ponto: ele não tenta ser tudo. Ele sabe quando precisa de ajuda.

Limitações: O que Toolformer ainda não consegue fazer

Nada é perfeito. E o Toolformer tem uma limitação crítica: ele só funciona com ferramentas "sem estado".

Ou seja: calculadoras, buscadores, tradutores. Coisas que respondem uma pergunta e esquecem tudo depois. Ele não pode fazer uma reserva de hotel, porque isso exige lembrar que você já disse que quer um quarto duplo, em 15 de março, com café da manhã. Ele não mantém memória de interações passadas. Não tem um "estado" interno.

Isso é um grande problema para aplicações reais. Se você quer um assistente que faça sua agenda, compre passagens ou gerencie seu orçamento, Toolformer não é suficiente. Ele é um passo importante, mas ainda é um protótipo de pesquisa.

Outra limitação: ele precisa de pelo menos algumas demonstrações humanas para cada ferramenta. Não é totalmente zero-shot. Mas são apenas 5 a 10 exemplos por API - algo que qualquer pesquisador pode fazer em uma tarde.

O que vem depois? ASTRO e o futuro das ferramentas

O Toolformer não foi o fim. Foi o começo.

Em fevereiro de 2024, o Meta AI publicou o ASTRO - um modelo que aprende a raciocinar como um mecanismo de busca. Ele não só usa ferramentas, mas planeja sequências de buscas, filtra resultados e toma decisões em múltiplos passos. É como se o Toolformer fosse um aluno que aprendeu a usar uma calculadora, e o ASTRO fosse um aluno que aprendeu a fazer uma pesquisa científica.

Essa evolução é natural. A ideia central de Toolformer - que modelos de linguagem devem aprender a usar ferramentas por auto-supervisão - está se espalhando. Agora, pesquisadores estão tentando:

- Ensinar modelos a usar APIs de banco de dados

- Fazer modelos interagirem com sistemas de e-commerce

- Permitir que eles lembrem estados de conversas

O futuro não é um modelo gigante que sabe tudo. É um modelo pequeno, inteligente, que sabe quando pedir ajuda - e como pedir.

Por que isso importa para você?

Se você usa ChatGPT, Claude ou Gemini hoje, está interagindo com modelos que ainda são como alunos que não sabem usar a biblioteca. Eles tentam adivinhar tudo. Às vezes acertam. Muitas vezes erram.

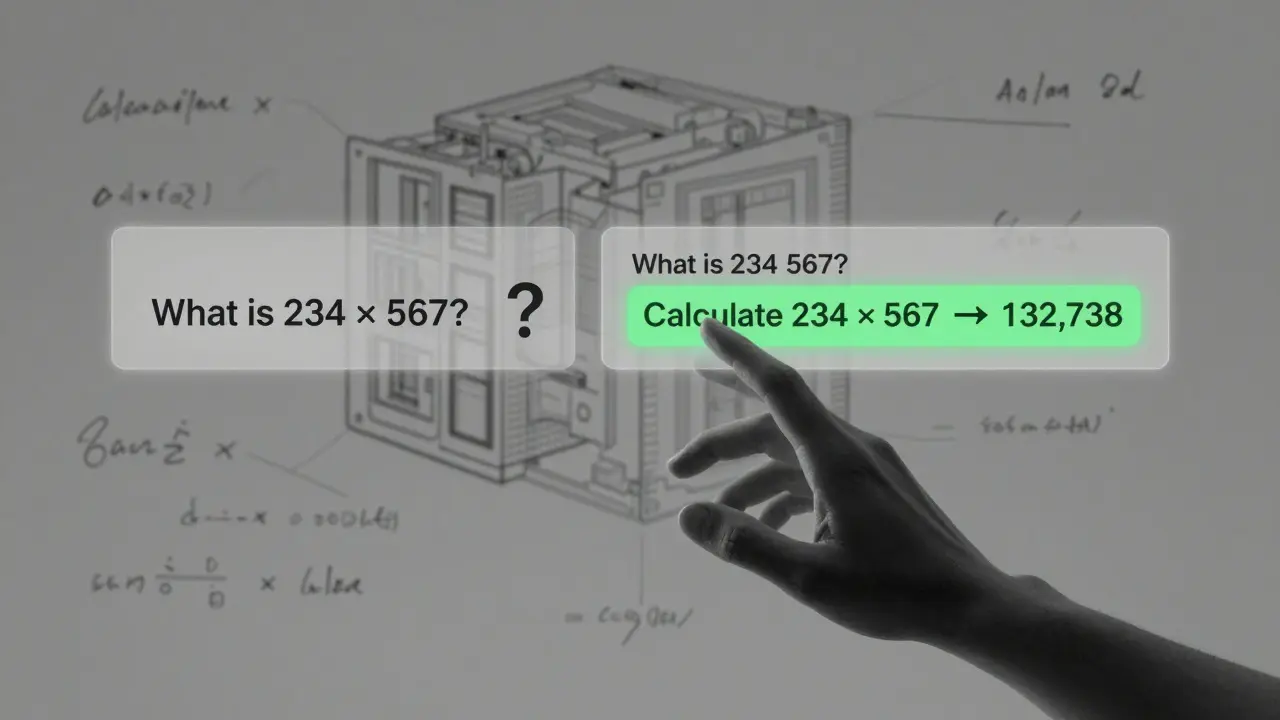

Daqui a dois anos, os modelos vão ser como assistentes reais: eles vão abrir o Google, checar o clima, calcular sua conta, traduzir um e-mail - tudo sem você pedir. Eles vão saber que, se você perguntar "quanto é 234 x 567?", não precisam tentar calcular na cabeça. Eles vão chamar a calculadora.

Toolformer foi o primeiro passo real nessa direção. Ele provou que não precisamos de mais dados. Não precisamos de mais parâmetros. Precisamos de modelos que saibam que não sabem tudo - e que tenham coragem de pedir ajuda.

O Toolformer é um produto que eu posso baixar e usar?

Não. Toolformer é um modelo de pesquisa, desenvolvido por cientistas da Meta e da Universidade de Oxford. Ele não está disponível como um aplicativo ou serviço público. Você pode ler o artigo original e tentar reproduzir o experimento com código aberto, mas não há uma versão pronta para uso por usuários comuns.

Como o Toolformer difere do ReAct?

O ReAct usa "pensamento em cadeia" e instruções humanas para decidir quando usar ferramentas. Por exemplo, o modelo é treinado com frases como: "Pense: preciso buscar isso na internet. Vou usar o buscador." O Toolformer, por outro lado, não recebe essas instruções. Ele descobre sozinho, por auto-supervisão, qual chamada de ferramenta melhora sua previsão de texto. Isso o torna mais flexível e menos dependente de anotações humanas.

Quais ferramentas o Toolformer consegue usar?

O Toolformer original foi treinado com cinco ferramentas: uma calculadora, um sistema de busca na Wikipedia, um sistema de resposta a perguntas (Q&A), um tradutor e um calendário. Todas essas são ferramentas "sem estado" - ou seja, não mantêm memória de interações anteriores. Ele não pode fazer compras, reservas ou interações complexas.

Por que o Toolformer usa apenas 6,7 bilhões de parâmetros e ainda supera o GPT-3?

Porque ele não tenta fazer tudo com memória interna. O GPT-3 tenta adivinhar tudo com base no que aprendeu no treinamento - o que leva a erros em cálculos e fatos recentes. O Toolformer, ao contrário, usa ferramentas externas para tarefas que ele não domina. Isso reduz a carga de memória e aumenta a precisão. É como um estudante que memoriza menos, mas sabe onde encontrar as respostas certas.

O Toolformer foi testado em português?

Não. O artigo original foi treinado e testado apenas em inglês. O modelo de base (GPT-J) foi treinado com dados em inglês, e as APIs usadas (como Wikipedia e Q&A) também eram em inglês. Não há evidência de que o mesmo método tenha sido aplicado a modelos em português. No entanto, a técnica é transferível - e pesquisadores em outros países já estão tentando replicá-la em línguas diferentes.